Nel mio articolo precedente, abbiamo introdotto il percettrone multistrato (MLP), che è solo un insieme di elementi impilati interconnessi percettroni. Ti consiglio vivamente di controllare il mio post precedente se non hai familiarità con il percettrone e l’MLP poiché ne parleremo un po’ in questo articolo:

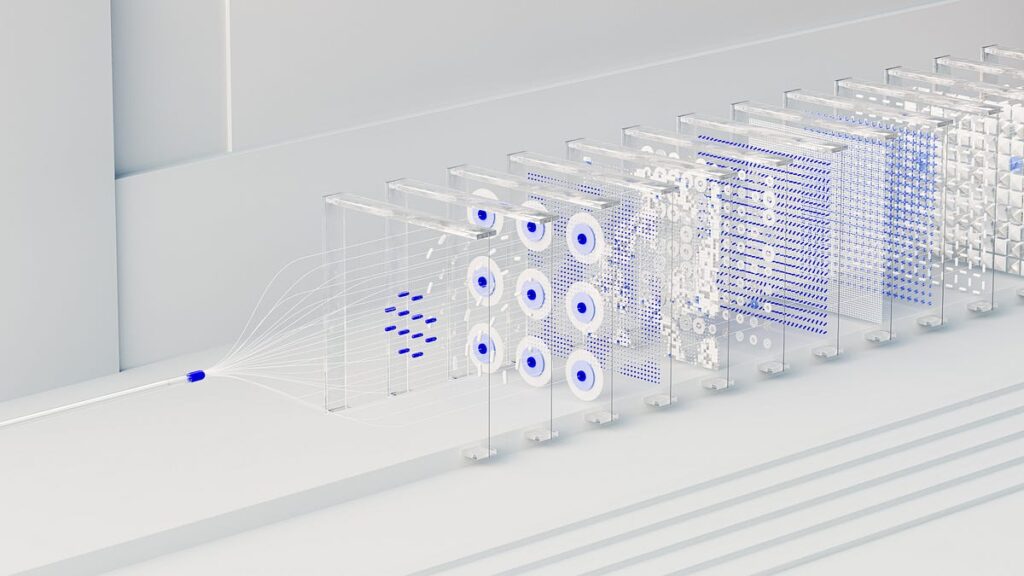

Di seguito è mostrato un esempio di MLP con due livelli nascosti:

Tuttavia, il problema con l’MLP è che può contenere solo a classificatore lineare. Questo perché i singoli percettroni hanno a funzione passo come il loro funzione di attivazioneche è lineare:

Quindi, nonostante l’impilamento dei nostri percettroni possa sembrare una rete neurale moderna, è pur sempre un classificatore lineare e non molto diverso dalla normale regressione lineare!

Un altro problema è che non è completamente differenziabile sull’intero intervallo di domini.

Quindi cosa facciamo a riguardo?

Funzioni di attivazione non lineare!

Cos’è la linearità?

Diciamo rapidamente cosa significa linearità per costruire un contesto. Matematicamente una funzione è considerata lineare se soddisfa la seguente condizione:

C’è anche un’altra condizione:

Ma lavoreremo con l’equazione precedente per questa dimostrazione.

Prendiamo questo caso molto semplice:

Fonte: towardsdatascience.com