I modelli unimodali sono progettati per funzionare con i dati di un’unica modalità, che possono essere testo o immagini. Questi modelli sono specializzati nella comprensione e nella generazione di contenuti specifici per la modalità scelta. Ad esempio, i GPT sono eccellenti nel generare testo simile a quello umano. Sono stati utilizzati per attività come la traduzione linguistica, la generazione di testi e la risposta a domande. Le reti neurali convoluzionali (CNN) sono esempi di modelli di immagine che eccellono in attività come la classificazione delle immagini, il rilevamento di oggetti e la generazione di immagini. Attualmente, molte attività interessanti come la risposta visiva alle domande (VQA) e il recupero di immagini-testo ecc. richiedono funzionalità multimodali. È possibile combinare l’elaborazione del testo e dell’immagine? Noi possiamo! CLIP si distingue come uno dei primi modelli immagine-testo di grande successo, dimostrando competenza sia nel riconoscimento delle immagini che nella comprensione del testo.

Divideremo questo articolo nelle seguenti sezioni:

- introduzione

- Architettura

- Processo formativo e perdita contrastiva

- Capacità di tiro zero

- CuPL

- Conclusioni

Il modello CLIP è un impressionante predittore a colpo zero, che consente previsioni su attività per le quali non è stato esplicitamente addestrato. Come vedremo più in dettaglio nelle prossime sezioni, utilizzando istruzioni in linguaggio naturale per interrogare le immagini, CLIP può eseguire la classificazione delle immagini senza richiedere dati di addestramento specifici dell’attività. Tuttavia, le sue prestazioni possono essere notevolmente migliorate con alcuni accorgimenti. In questa serie di articoli esploreremo metodi che sfruttano suggerimenti aggiuntivi generati da Large Language Models (LLM) o alcuni esempi di formazione di poche riprese senza coinvolgere alcuna formazione sui parametri. Questi approcci offrono un netto vantaggio in quanto sono meno impegnativi dal punto di vista computazionale e non richiedono la messa a punto di parametri aggiuntivi.

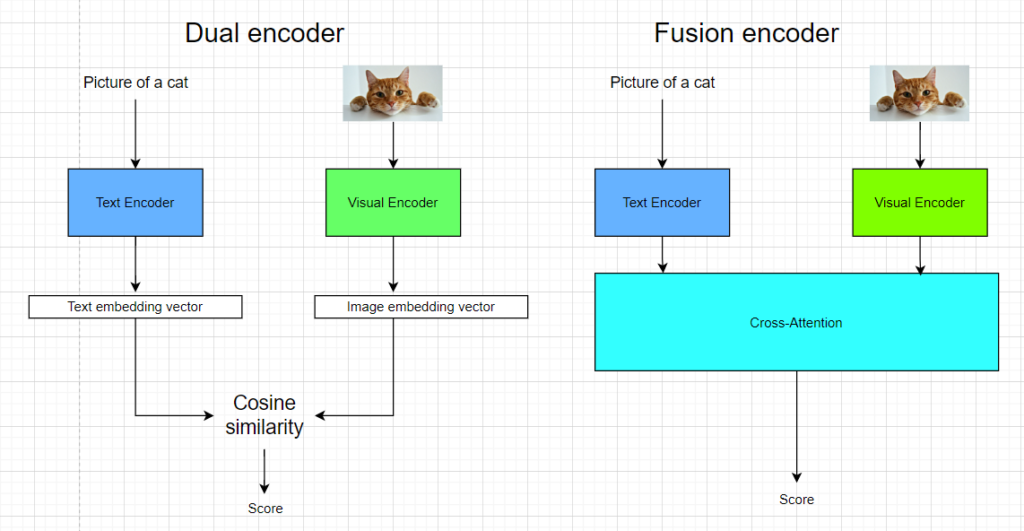

CLIP è un modello a doppio codificatore con due codificatori separati per modalità visive e testuali che codificano immagini e testi in modo indipendente. Tale architettura è diversa dal codificatore di fusione che consente l’interazione tra modalità visive e testuali attraverso l’attenzione incrociata che comporta l’apprendimento di pesi di attenzione che aiutano il modello a concentrarsi su regioni specifiche di…

Fonte: towardsdatascience.com