La selezione delle funzionalità è così lenta perché richiede la creazione di molti modelli. Scopri come renderlo incredibilmente più veloce grazie alle previsioni approssimative

Quando sviluppiamo un modello di machine learning, di solito iniziamo con un ampio set di funzionalità risultanti dai nostri sforzi di ingegneria delle funzionalità.

La selezione delle funzionalità è il processo di scelta di un sottoinsieme più piccolo di funzionalità ottimali per il nostro modello ML.

Perché farlo e non semplicemente mantenere tutte le funzionalità?

- Memoria. I big data occupano molto spazio. L’eliminazione delle funzionalità significa che è necessaria meno memoria per gestire i dati. A volte ci sono anche vincoli esterni.

- Tempo. Riqualificare un modello con meno dati può farti risparmiare molto tempo.

- Precisione. Less is more: questo vale anche per il machine learning. Includere funzionalità ridondanti o irrilevanti significa includere rumore non necessario. Accade spesso che un modello addestrato su meno dati funzioni meglio.

- Spiegabilità. Un modello più piccolo è più facilmente spiegabile.

- Debug. Un modello più piccolo è più facile da mantenere e risolvere i problemi.

Ora, il problema principale con la selezione delle funzionalità è che lo è molto lento perché richiede l’addestramento di molti modelli.

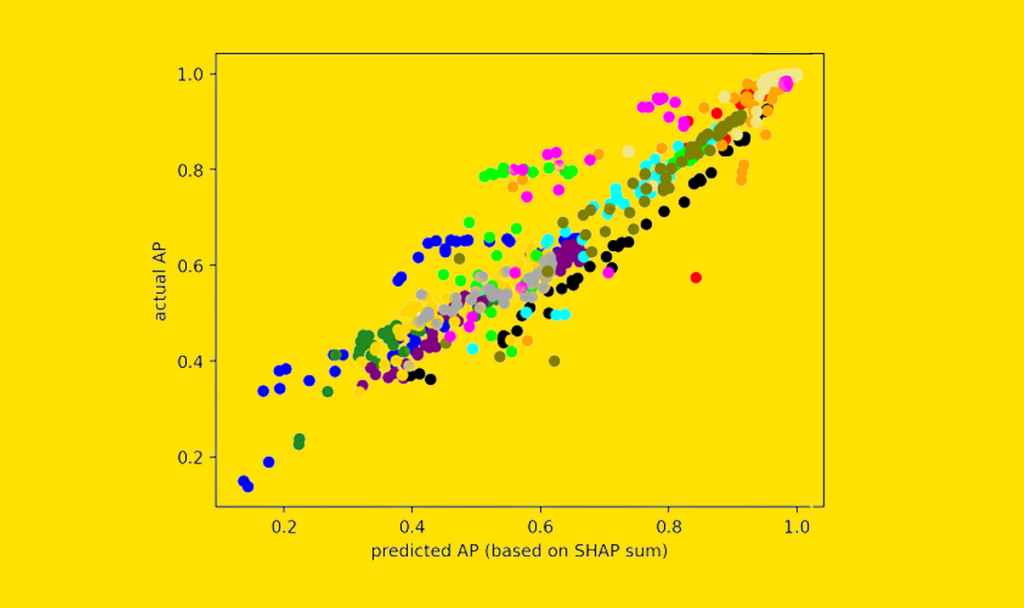

In questo articolo vedremo un trucco che rende la selezione delle caratteristiche estremamente più veloce grazie alle “previsioni-approssimate”.

Proviamo a visualizzare il problema della selezione delle caratteristiche. Iniziamo con N caratteristiche, dove N è in genere centinaia o migliaia.

Pertanto, l’output della selezione delle caratteristiche può essere visto come un array di lunghezza N composto da “sì”/“no”, dove ogni elemento dell’array ci dice se la caratteristica corrispondente è selezionata o meno.

Il processo di selezione delle funzionalità consiste nel provare diversi “candidati” e infine scegliere quello migliore (secondo la nostra metrica di prestazione).

Fonte: towardsdatascience.com