La forza trainante dietro i moderni modelli di trasformatori deriva in larga misura dai dati relativi, che consentono forti capacità di apprendimento nel contesto.

L’intelligenza artificiale generativa e i suoi popolari modelli di trasformatori sono pubblicizzati ovunque in questi giorni e nuovi modelli vengono rilasciati ogni ora (vedi l’inflazione dell’intelligenza artificiale). In questo campo dell’intelligenza artificiale in rapida evoluzione, le possibilità di valori che questi modelli potrebbero apportare sembrano essere infinite. Simili ai modelli linguistici di grandi dimensioni (LLM). chatGPT sono già entrati nelle risorse di ogni ingegnere, gli scrittori li usano per supportare i loro articoli e i designer creano le prime immagini o cercano ispirazione dai risultati dei modelli di visione artificiale.

Se non è magia, cosa alimenta davvero questi impressionanti modelli di trasformatori?

Tuttavia, anche se i risultati e l’utilità sono grandi e l’intelligenza artificiale generativa migliora la produttività, è importante ricordare che i moderni modelli di machine learning (come LLM o VisionTransformers) non stanno facendo alcuna magia (simile al fatto che ML o modelli statistici in generale, non sono mai stati magici). Anche se le notevoli capacità dei modelli potrebbero essere percepite come come per magia e alcuni esperti del settore parlano addirittura di cose del genere allucinazioni dei modelli, tuttavia, il fondamento di ogni modello è solo la matematica e le probabilità statistiche (a volte complesse, ma pur sempre matematica). Ciò porta alla domanda fondamentale: se non è magia, cosa alimenta davvero questi impressionanti modelli di trasformatori?

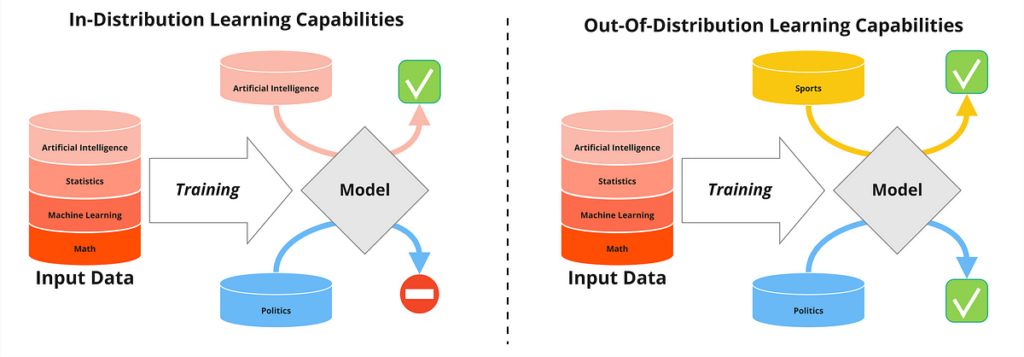

Come con qualsiasi modello (statistico o ML), sono i dati di training ad avere il maggiore impatto sulle prestazioni del modello successivo. Se non disponi di un volume elevato di dati di qualità che riflettono le relazioni che desideri che il modello apprenda, è disponibile Niente su cui addestrarsi e il modello risultante avrà prestazioni scadenti (il famoso principio GIGO: Garbage In Garbage Out). Questo principio fondamentale della modellazione dei dati non è cambiato affatto nel corso degli anni. Dietro ogni nuovo modello rivoluzionario di trasformatore c’è innanzitutto una cosa: dati. È il quantità, qualitàE contesto di quei dati che…

Fonte: towardsdatascience.com