Padroneggiare il RAG avanzato: sbloccare il futuro delle applicazioni basate sull’intelligenza artificiale

Attualmente lavoro come Solution Architect presso MongoDB, ho trovato ispirazione nel scrivere questo articolo dialogando con i miei colleghi Fabiano Valle, Brian Leonardo, Gabriel Paranthoe, Benjamin Flast E Henry Weller.

La generazione aumentata di recupero (RAG) rappresenta un progresso significativo nel campo dell’intelligenza artificiale generativa, combinando un recupero efficiente dei dati con la potenza di modelli linguistici di grandi dimensioni.

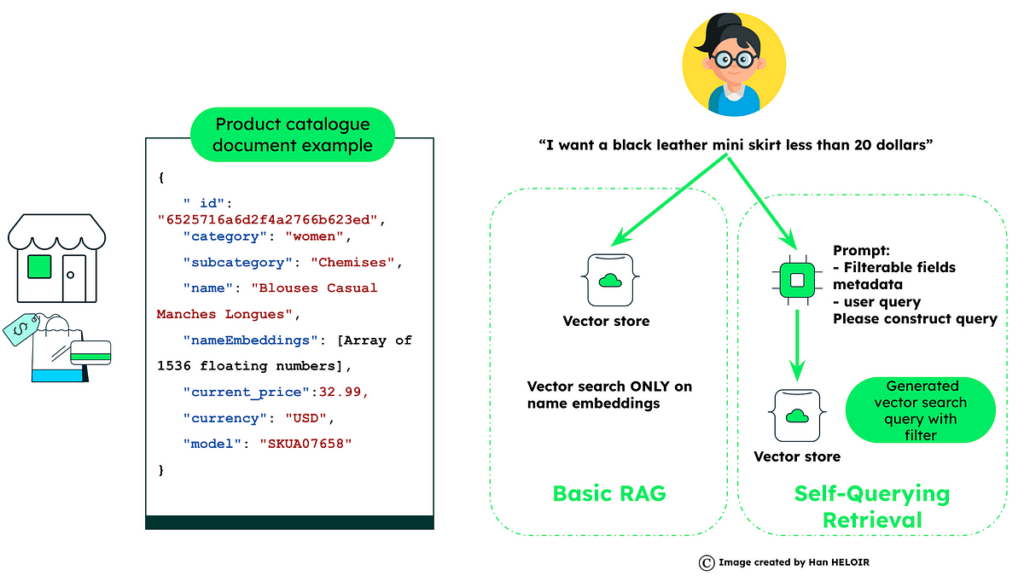

Fondamentalmente, RAG opera attraverso utilizzando la ricerca vettoriale per estrarre dati rilevanti ed esistenti, combinando queste informazioni recuperate con la query dell’utentepoi elaborandolo attraverso un ampio modello linguistico come ChatGPT.

Questo metodo RAG garantisce che le risposte generate non siano solo precise ma riflettano anche le informazioni attuali, riducendo sostanzialmente le imprecisioni o le “allucinazioni” nell’output.

Tuttavia, con l’espansione del panorama delle applicazioni IA, le richieste poste a RAG stanno diventando più complesse e varie. Il framework RAG di base, sebbene solido, potrebbe non essere più sufficiente per affrontare le esigenze sfumate di diversi settori e casi d’uso in evoluzione. È qui che entrano in gioco le tecniche RAG avanzate. Questi metodi avanzati sono adattati per soddisfare sfide specifiche, offrendo maggiore precisione, adattabilità ed efficienza nell’elaborazione delle informazioni.

L’essenza del RAG di base

La generazione aumentata di recupero (RAG) combina la gestione dei dati con query intelligenti per migliorare la precisione della risposta dell’intelligenza artificiale.

- Preparazione dei dati: Si inizia con il caricamento dei dati da parte dell’utente, che vengono poi suddivisi in blocchi e archiviati con incorporamenti, creando una base per il recupero.

- Recupero: Una volta posta una domanda, il sistema utilizza tecniche di ricerca vettoriale per estrarre i dati archiviati, individuando le informazioni rilevanti.

- Domanda LLM: Le informazioni recuperate vengono quindi utilizzate per fornire il contesto per il modello linguistico (LLM), che prepara il suggerimento finale fondendo il contesto con la domanda. Il risultato è una risposta generata sulla base dei dati ricchi e contestualizzati forniti, a dimostrazione della capacità di RAG di produrre risposte affidabili e informate.

Fonte: towardsdatascience.com