In questo post esaminiamo SentenceTransformer (1), pubblicato nel 2019. SentenceTransformer ha un’architettura bi-encoder e adatta BERT per produrre incorporamenti di frasi efficienti.

BERT (Bidirezionale Encoder Representation of Transformers) è costruito con l’ideologia secondo cui tutti i compiti della PNL si basano sul significato di token/parole. BERT viene formato in due fasi: 1) fase di pre-formazione in cui BERT apprende il significato generale della lingua e 2) messa a punto in cui BERT viene formato su compiti specifici.

BERT è molto bravo ad apprendere il significato di parole/gettoni. Ma non è bravo a imparare il significato delle frasi. Di conseguenza non è bravo in alcuni compiti come la classificazione delle frasi e la somiglianza tra le coppie di frasi.

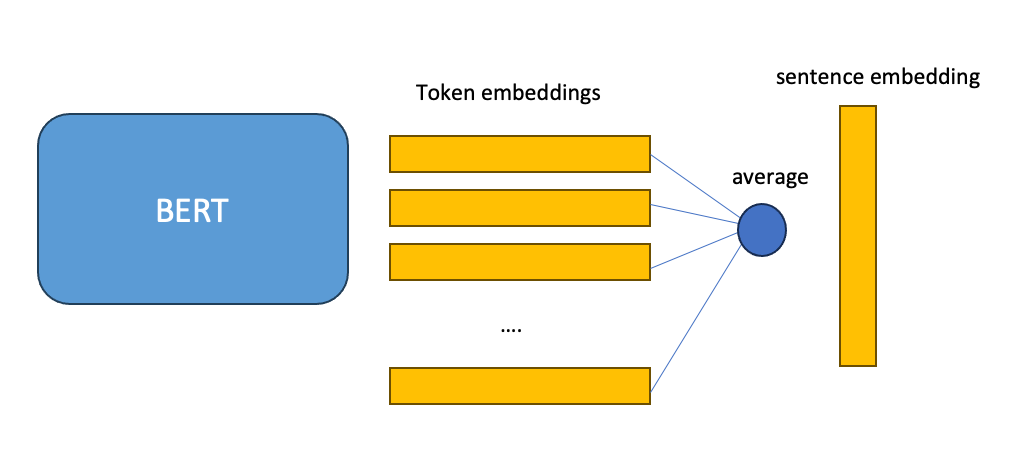

Poiché BERT produce l’incorporamento di token, un modo per ottenere l’incorporamento di frasi da BERT è calcolare la media dell’incorporamento di tutti i token. Il documento SentenceTransformer (1) ha dimostrato che questo produce incorporamenti di frasi di qualità molto bassa quasi altrettanto dannosi quanto ottenere incorporamenti di GLOVE. Questi incorporamenti non catturano il significato delle frasi.

Per creare incorporamenti di frasi da BERT che siano significativi, SentenceTransformer addestra BERT su alcune attività correlate a frasi come:

- NLI (inferenza del linguaggio naturale): questa attività riceve due frasi di input e restituisce “implicazione”, “contraddizione” o “neutrale”. In caso di “implicazione” la frase 1 implica la frase 2. In caso di “contraddizione” la frase 1 contraddice la frase 2. E nel terzo caso, che è “neutro”, le due frasi non hanno alcuna relazione.

- STS (somiglianza testuale delle frasi): questo compito riceve due frasi e ne decide la somiglianza. Spesso la somiglianza viene calcolata utilizzando la funzione di somiglianza del coseno.

- Set di dati tripletta

SentenceTransformer addestra BERT sull’attività NLI utilizzando una rete siamese. Siamese significa gemelli ed è composto da…

Fonte: towardsdatascience.com