Nel panorama in rapida evoluzione dell’intelligenza artificiale, i recenti progressi hanno spinto il campo a livelli sorprendenti, consentendo ai modelli di imitare capacità umane nella gestione sia di immagini che di testo. Dalla creazione di immagini con la finezza di un artista alla generazione di didascalie accattivanti, alla risposta a domande e alla composizione di interi saggi, l’intelligenza artificiale è diventata uno strumento indispensabile nel nostro arsenale digitale.

Tuttavia, nonostante queste imprese straordinarie, l’adozione su vasta scala di questa potente tecnologia non è universale. La natura “scatola nera” dei modelli di intelligenza artificiale solleva notevoli preoccupazioni, in particolare nei settori in cui la trasparenza è fondamentale. La mancanza di comprensione “perché il modello ha detto questo?” introduce rischi, come tossicità e pregiudizi ingiusti, in particolare nei confronti dei gruppi emarginati. In settori ad alto rischio come la sanità e la finanza, dove le conseguenze di decisioni errate sono costose, la necessità di spiegabilità diventa cruciale. Ciò significa che non è sufficiente che il modello arrivi alla decisione corretta, ma è altrettanto importante spiegare la logica alla base di tali decisioni.

Mentre i modelli in grado di importare, comprendere e generare più immagini o testo sono stati la nuova frenesia tra molte persone, molti domini ad alto rischio prendono decisioni partendo da dati compilati in tabelle come informazioni sul profilo utente, post che hanno messo mi piace all’utente, cronologia degli acquisti, cronologia delle visualizzazioni. eccetera.,

I dati tabulari non sono un fenomeno nuovo. Esiste da quando esiste Internet, come la cronologia del browser dell’utente con le pagine visitate, le interazioni con i clic, i prodotti visualizzati online, i prodotti acquistati online ecc.. Queste informazioni vengono spesso utilizzate dagli inserzionisti per mostrarti annunci pertinenti.

Anche molti casi d’uso critici nei settori ad alta posta in gioco come finanza, sanità, legale, ecc. fanno molto affidamento su dati organizzati in formato tabellare. Ecco alcuni esempi:

- Consideriamo un ospedale che cerca di calcolare la probabilità che un paziente si riprenda bene dopo un determinato trattamento. Potrebbero utilizzare tabelle di dati dei pazienti, inclusi fattori come età, problemi di salute precedenti e dettagli del trattamento. Se i modelli utilizzati sono troppo complessi o “scatola nera”, i medici potrebbero avere difficoltà a fidarsi o a comprendere le previsioni.

- Allo stesso modo, nel mondo finanziario, le banche analizzano diversi fattori in tabelle per decidere se qualcuno ha diritto a un prestito e quale tasso di interesse offrire. Se i modelli utilizzati sono troppo complessi, diventa difficile spiegare ai clienti il motivo per cui è stata presa una decisione, il che potrebbe portare a una mancanza di fiducia nel sistema.

Nel mondo reale, molti compiti decisionali critici come la diagnosi di malattie da esami medici, l’approvazione di prestiti sulla base dei rendiconti finanziari, l’ottimizzazione degli investimenti in base ai profili di rischio sui robo-advisor, l’identificazione di profili falsi sui social media e il targeting del pubblico giusto per servizi personalizzati tutti gli annunci pubblicitari implicano prendere decisioni sulla base di dati tabulari. Mentre le reti neurali profonde, come le reti neurali convoluzionali e i modelli di trasformazione come GPT, eccellono nel cogliere input non strutturati come immagini, testo e voce, i modelli Tree Ensemble come XGBoost rimangono ancora i campioni ineguagliati nella gestione dei dati tabulari. Ciò potrebbe sorprendere nell’era delle reti neurali profonde, ma è vero! Modelli profondi per dati tabulari come Moduli di perdita, TabNet ecc., funzionano bene quanto i modelli XGBoost, sebbene utilizzino molti più parametri.

In questo post del blog, analizzeremo le decisioni di classificazione binaria prese da un modello XGBoost. Un approccio intuitivo per spiegare tali modelli consiste nell’utilizzare regole comprensibili dall’uomo. Ad esempio, considera un modello che decide se un account utente è quello di un robot. Se il modello etichetta un utente come “robot”, una spiegazione interpretabile basata sulle caratteristiche del modello potrebbe essere che “il numero di connessioni con altri robot ≥ 100 e il numero di chiamate API al giorno ≥ 10k”.

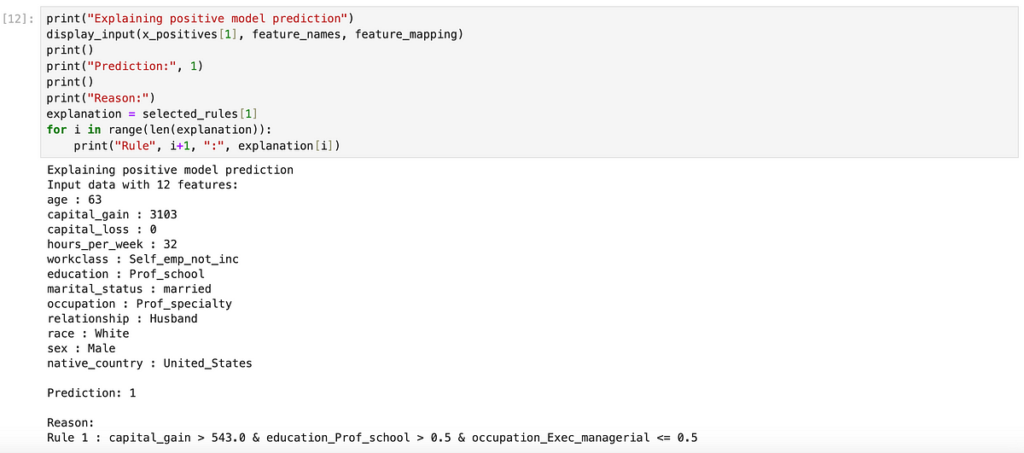

Regole TE2 è un algoritmo progettato proprio per questo scopo. TE2Rules sta per Tree Ensembles to Rules e la sua funzione principale è spiegare qualsiasi modello di insieme di alberi orientato alla classificazione binaria generando regole derivate da combinazioni di caratteristiche di input. Questo algoritmo combina percorsi decisionali estratti da più alberi all’interno del modello XGBoost, utilizzando un sottoinsieme di dati senza etichetta. I dati utilizzati per estrarre le regole dal modello XGBoost non devono necessariamente essere gli stessi dei dati di addestramento e non richiedono alcuna etichetta di verità. L’algoritmo utilizza questi dati per scoprire correlazioni implicite presenti nel set di dati. In particolare, le regole estratte da TE2Rules mostrano un’elevata precisione rispetto alle previsioni del modello (con un valore predefinito del 95%). L’algoritmo identifica sistematicamente tutte le potenziali regole del modello XGBoost per spiegare i casi positivi e successivamente le condensa in un insieme conciso di regole che coprono efficacemente la maggior parte dei casi positivi nei dati. Questo insieme condensato di regole funge da spiegazione globale e completa del modello. Inoltre, TE2Rules conserva l’insieme più lungo di tutte le regole immaginabili, che possono essere utilizzate per spiegare istanze specifiche attraverso l’uso di regole concise.

TE2Rules ha dimostrato la sua efficacia in vari ambiti medici fornendo approfondimenti sul processo decisionale dei modelli. Ecco alcuni esempi:

In questa sezione mostriamo come utilizzare TE2Rules per spiegare un modello addestrato per prevedere se il reddito di un individuo supera i 50.000 dollari. Il modello viene addestrato utilizzando Set di dati sul reddito degli adulti dal repository UCI. Il notebook Jupyter utilizzato in questo blog è disponibile qui: XGBoost-Model-Spiegazione-Demo. Il set di dati è coperto dalla licenza CC BY 4.0, che consente sia l’uso accademico che commerciale.

Passaggio 1: addestra il modello XGBoost

Fonte: towardsdatascience.com