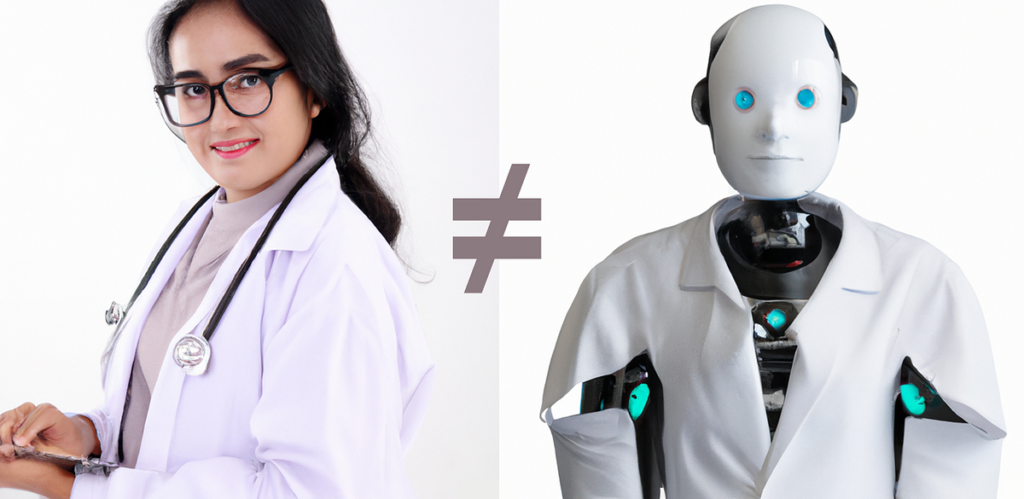

L’anno scorso, ChatGPT superato l’esame di licenza medica statunitense ed è stato riferito che lo fosse “più empatico” dei veri medici. ChatGPT attualmente ha circa 180 milioni di utenti; se solo il 10% di loro ha posto una domanda medica a ChatGPT, si tratta già di una popolazione due volte più grande di New York City che usa ChatGPT come un medico. C’è un’esplosione in corso di startup di chatbot medici che costruiscono sottili involucri attorno a ChatGPT per distribuire consulenza medica. Ma ChatGPT non è un medico e utilizzare ChatGPT per una consulenza medica non lo è solo contro le politiche di utilizzo di OpenAIpuò essere pericoloso.

In questo articolo identifico quattro problemi chiave legati all’utilizzo dei chatbot generici esistenti per rispondere alle domande mediche poste dai pazienti. Fornisco esempi di ciascun problema utilizzando conversazioni reali con ChatGPT. Spiegherò anche perché costruire un chatbot in grado di rispondere in modo sicuro alle domande poste dai pazienti è completamente diverso dalla creazione di un chatbot in grado di rispondere alle domande USMLE. Infine, descrivo i passaggi che tutti possono intraprendere – pazienti, imprenditori, medici e aziende come OpenAI – per rendere i chatbot più sicuri dal punto di vista medico.

Appunti

Per motivi di leggibilità utilizzo il termine “ChatGPT”, ma l’articolo si applica a tutti i modelli LLM (Large Language Model) per uso generale disponibili pubblicamente, inclusi ChatGPT, GPT-4, Llama2, Gemini e altri. Esistono alcuni LLM specificamente progettati per la medicina, ad esempio Med-PaLM; questo articolo non riguarda quei modelli. Mi concentrerò qui sui chatbot generici perché (a) hanno il maggior numero di utenti; (b) sono di facile accesso; e (c) molti pazienti li stanno già utilizzando per consulenza medica.

Nelle chat con ChatGPT, fornisco citazioni letterali della risposta di ChatGPT, con puntini di sospensione (…) per indicare materiale che è stato tralasciato per brevità. Non ho mai tralasciato nulla che potesse cambiare la mia valutazione della risposta di ChatGPT. Per completezza, le trascrizioni complete della chat sono fornite in un documento Word allegato alla fine di questo articolo. Le parole “Paziente:” e “ChatGPT:” sono tag di dialogo e sono state aggiunte successivamente per chiarezza. Questi tag di dialogo non facevano parte dei suggerimenti o delle risposte.

Fonte: towardsdatascience.com