Se hai mai utilizzato ChatGPT per aiutarti con un noioso script Python che stavi rimandando o per trovare il modo migliore per affrontare un compito universitario di programmazione, probabilmente lo avrai capito sebbene i Large Language Models (LLM) possano essere utili per alcune attività di codifica, spesso hanno difficoltà a generare codice efficiente e di alta qualità.

Non siamo i soli nel nostro interesse ad avere LLM come assistenti alla codifica. C'è stato un interesse in rapida crescita nell'utilizzo di LLM per la codifica da parte delle aziende, portando allo sviluppo di assistenti di codifica basati su LLM come Copilota GitHub.

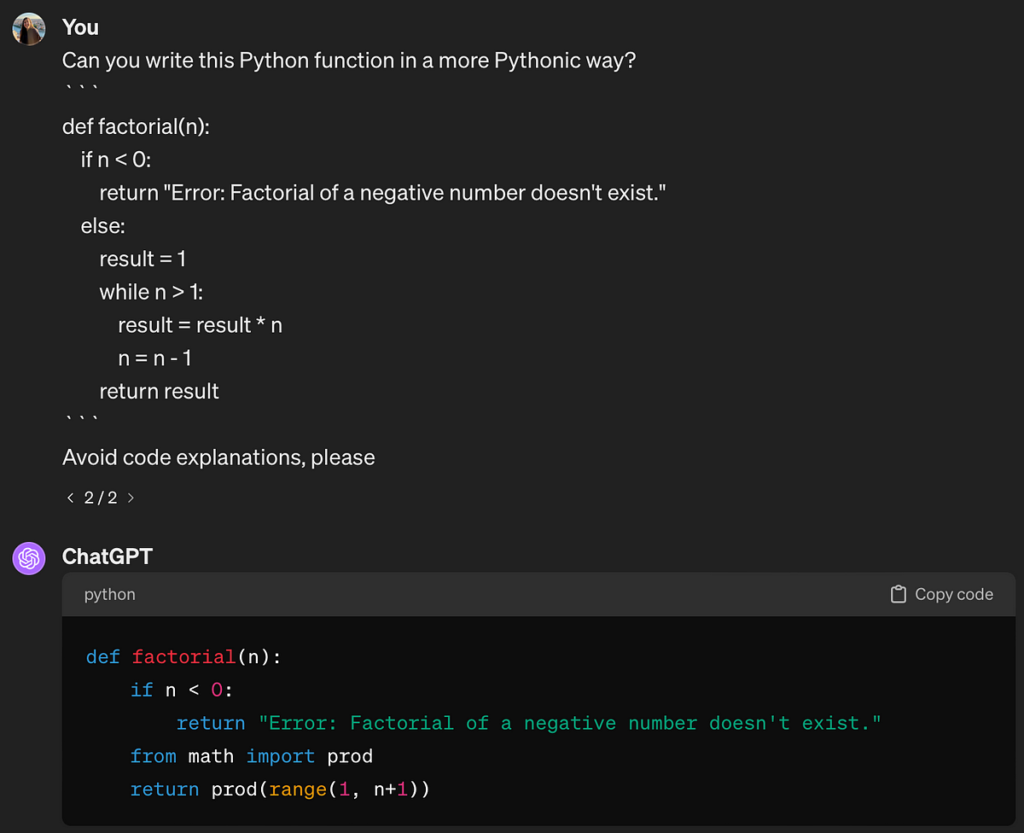

L'utilizzo degli LLM per la codifica presenta sfide significative, come abbiamo discusso nell'articolo “Perché i LLM non sono adatti alla programmazione”. Tuttavia, esistono tecniche di ingegneria tempestiva che possono migliorare la generazione del codice per determinate attività.

In questo articolo, introdurremo alcune efficaci tecniche di prompt engineering per migliorare la generazione del codice.

Immergiamoci in profondità!

L'ingegneria rapida per i LLM implica elaborare attentamente suggerimenti per massimizzare la qualità e la pertinenza dell'output del modello. Questo processo è sia un'arte che una scienza, poiché richiede la comprensione di come…

Fonte: towardsdatascience.com