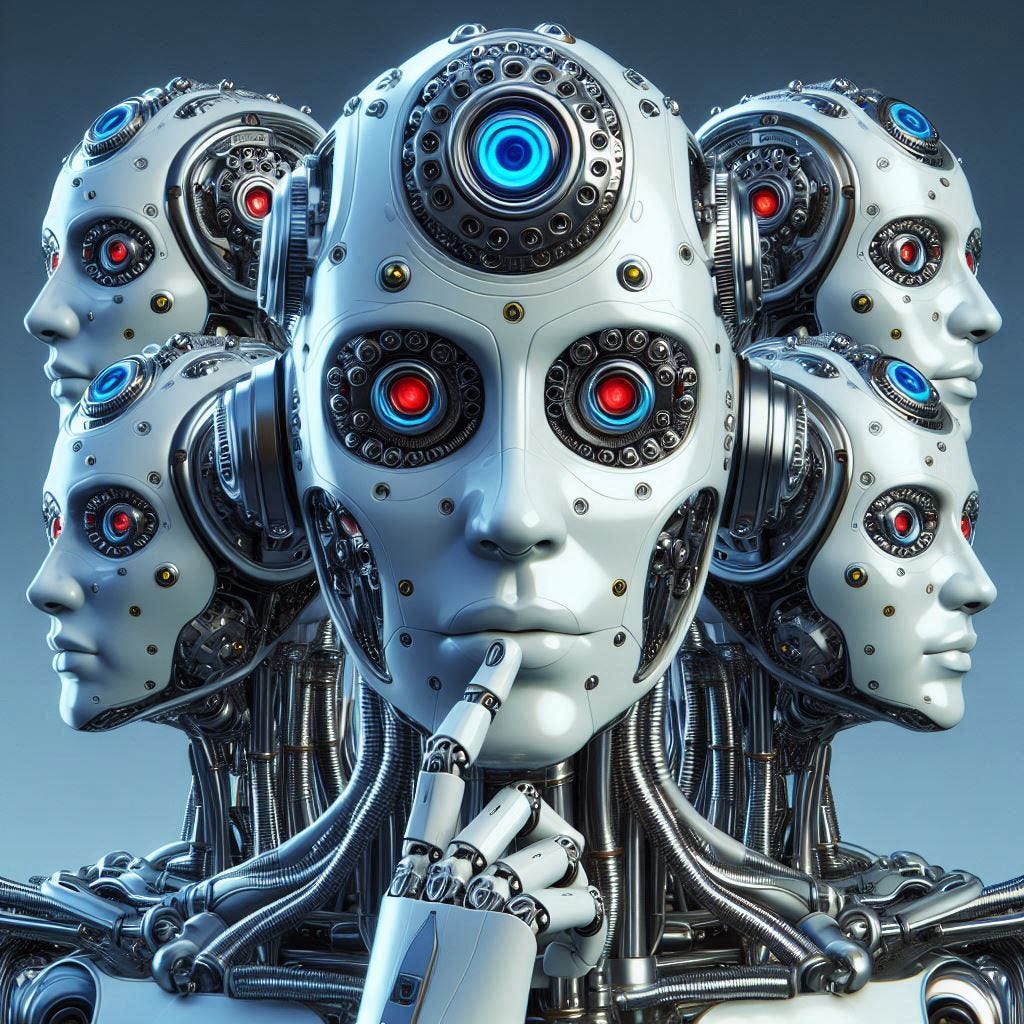

L’attenzione multitesta gioca un ruolo cruciale nei trasformatori, che hanno rivoluzionato l’elaborazione del linguaggio naturale (PNL). Comprendere questo meccanismo è un passo necessario per ottenere un quadro più chiaro degli attuali modelli linguistici all'avanguardia.

Fonte: towardsdatascience.com