Il team fondamentale di ricerca AI (Fair) di Meta ha annunciato cinque progetti che fa avanzare la ricerca di Machine Intelligence (AMI) da parte dell'azienda.

Le ultime uscite da Meta Concentrati fortemente sul miglioramento della percezione dell'intelligenza artificiale – la capacità delle macchine di elaborare e interpretare le informazioni sensoriali – insieme ai progressi nella modellazione linguistica, nella robotica e negli agenti di intelligenza artificiale collaborativa.

Meta ha dichiarato che il suo obiettivo prevede la creazione di macchine “che sono in grado di acquisire, elaborare e interpretare le informazioni sensoriali sul mondo che ci circonda e sono in grado di utilizzare queste informazioni per prendere decisioni con intelligenza e velocità simili all'uomo”.

Le cinque nuove versioni rappresentano sforzi diversi ma interconnessi per raggiungere questo obiettivo ambizioso.

Encoder percezione: Meta affila la “visione” di AI

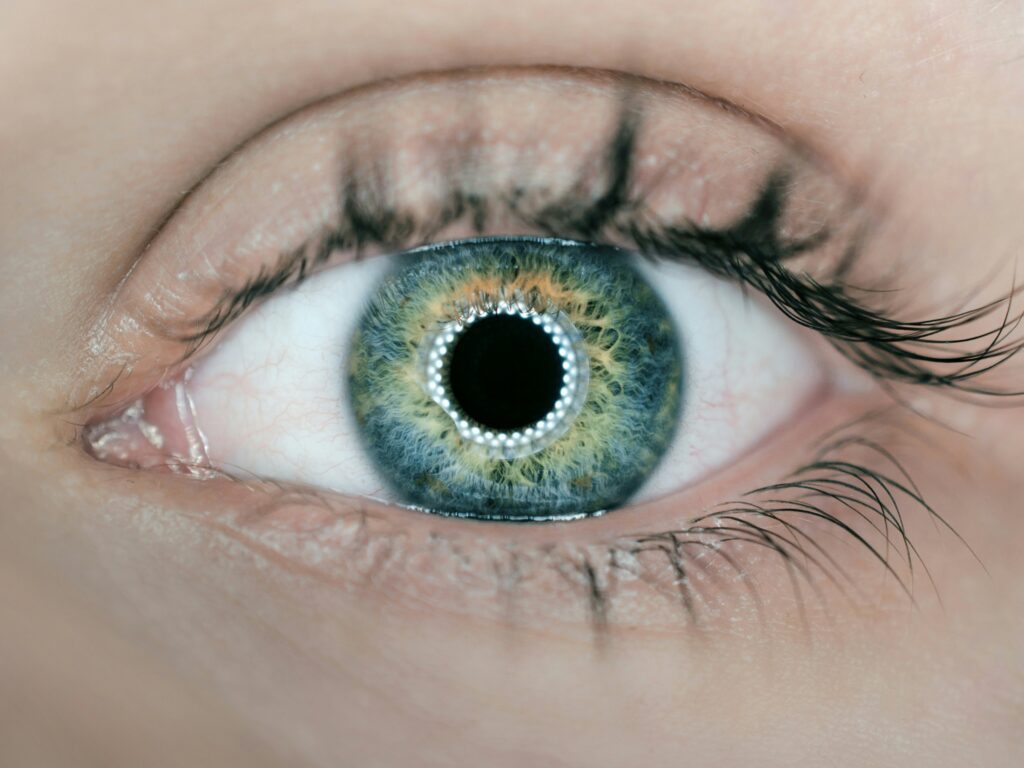

Al centro delle nuove versioni è il codificatore di percezione, descritto come un codificatore di visione su larga scala progettato per eccellere attraverso varie attività di immagine e video.

Gli encoder della visione funzionano come “occhi” per i sistemi di intelligenza artificiale, consentendo loro di comprendere i dati visivi.

Meta evidenzia la crescente sfida degli encoder di costruzione che soddisfano le esigenze dell'intelligenza artificiale avanzata, che richiedono capacità che ponte la visione e il linguaggio, gestiscono in modo efficace immagini e video e rimangono robusti in condizioni difficili, tra cui potenziali attacchi contraddittori.

L'encoder ideale, secondo Meta, dovrebbe riconoscere una vasta gamma di concetti distinguendo i dettagli sottili: esempi che si avvicinano a “una pastinaca scavata sotto il fondo del mare, identificando un piccolo cartiera d'oro sullo sfondo di un'immagine o catturare un Agouti da scatto su una fotocamera della fauna selvatica per la visione notturna”.

Meta afferma che l'encoder di percezione raggiunge “prestazioni eccezionali sulla classificazione e il recupero di immagini e video di immagini e video, superando tutti i modelli open source e proprietari esistenti per tali compiti”.

Inoltre, secondo quanto riferito, i suoi punti di forza percettivi si traducono bene in compiti linguistici.

Se allineato con un modello di linguaggio di grandi dimensioni (LLM), si dice che l'encoder sovraperformi altri encoder di visione in aree come la risposta visiva a rispondente (VQA), sottotitoli, comprensione del documento e messa a terra (collegamento del testo a regioni di immagine specifiche). Secondo quanto riferito, aumenta anche le prestazioni su compiti tradizionalmente difficili per LLM, come la comprensione delle relazioni spaziali (ad es. “Se un oggetto è dietro un altro”) o il movimento della telecamera rispetto a un oggetto.

“Poiché Encoder perception inizia a essere integrato in nuove applicazioni, siamo entusiasti di vedere come le sue capacità di visione avanzate consentiranno sistemi di intelligenza artificiale ancora più capaci”, ha affermato Meta.

Perception Language Model (PLM): ricerca aperta in linguaggio visivo

A complemento dell'encoder è il modello di lingua percezione (PLM), un modello di linguaggio aperto e riproducibile rivolto a complessi compiti di riconoscimento visivo.

Il PLM è stato addestrato utilizzando dati sintetici su larga scala combinati con set di dati aperti in linguaggio, esplicitamente senza distillare le conoscenze da modelli proprietari esterni.

Riconoscendo le lacune nei dati di comprensione dei video esistenti, il team Fair ha raccolto 2,5 milioni di nuovi campioni con labellatura umana incentrati su domande video a grana fine e sottotitoli spazio-temporali. Meta afferma che questo costituisce il “più grande set di dati del suo genere fino ad oggi”.

Il PLM è offerto in versioni di parametri 1, 3 e 8 miliardi, soddisfacenti alle esigenze di ricerca accademica che richiedono trasparenza.

Accanto ai modelli, Meta sta rilasciando PLM-Videobench, un nuovo punto di riferimento appositamente progettato per testare le capacità spesso mancate dai parametri di riferimento esistenti, vale a dire “comprensione delle attività a grana fine e ragionamento a terra spaziale”.

Meta spera che la combinazione di modelli aperti, il set di dati di grandi dimensioni e il benchmark impegnativo consentiranno alla comunità open source.

Meta Locate 3D: Dare robot consapevolezza situazionale

Colmare il divario tra comandi linguistici e azione fisica è Meta individuare 3D. Questo modello end-to-end mira a consentire ai robot di localizzare accuratamente gli oggetti in un ambiente 3D basato su query in linguaggio naturale a vocabulario aperto.

Meta individuare i processi 3D cloud di punti 3D direttamente da sensori RGB-D (come quelli che si trovano su alcuni robot o telecamere per il rilevamento della profondità). Dato un prompt testuale, come “Vaso di fiori vicino alla console TV”, il sistema considera le relazioni spaziali e il contesto per individuare l'istanza dell'oggetto corretto, distinguendolo da, diciamo, un “vaso sulla tabella”.

Il sistema comprende tre parti principali: una fase di preelaborazione che converte le caratteristiche 2D in nuvole di punti predefinite 3D; L'encoder 3D-JEPA (un modello pretratto che crea una rappresentazione mondiale 3D contestualizzata); e il decodificatore 3D localizza, che prende la rappresentazione 3D e la query linguistica per produrre caselle di controllo e maschere per gli oggetti specificati.

Accanto al modello, Meta sta rilasciando un nuovo set di dati sostanziale per la localizzazione degli oggetti in base alle espressioni di riferimento. Include 130.000 annotazioni linguistiche su 1.346 scene degli ARKITSCENES, della scanna e dei set di dati di scannet ++, raddoppiando efficacemente i dati annotati esistenti in questo settore.

Meta vede questa tecnologia come cruciale per lo sviluppo di sistemi robotici più capaci, incluso il proprio progetto di robot partNR, consentendo un'interazione e una collaborazione più naturali di robot umano.

Trasformatore latente byte dinamico: modellazione linguistica efficiente e robusta

Dopo la ricerca pubblicata alla fine del 2024, Meta sta ora rilasciando i pesi del modello per il suo trasformatore latente di byte dinamico da 8 miliardi di parametri.

Questa architettura rappresenta uno spostamento dai tradizionali modelli linguistici basati su tokenizzazione, operando invece a livello di byte. Meta afferma che questo approccio raggiunge prestazioni comparabili su vasta scala offrendo miglioramenti significativi nell'efficienza e robustezza dell'inferenza.

LLM tradizionali rompe il testo in “token”, che possono lottare con errori di ortografia, parole nuove o input contraddittori. I modelli a livello di byte elaborano byte grezzi, offrendo potenzialmente una maggiore resilienza.

Meta riferisce che il trasformatore latente di byte dinamico “supera i modelli a base di tokeniser su vari compiti, con un vantaggio medio di robustezza di +7 punti (su Hellaswag perturbato) e raggiungendo fino a +55 punti sui compiti dal grazioso benchmark di conquista dei token.”

Rilasciando i pesi insieme alla base di codice precedentemente condivisa, Meta incoraggia la comunità di ricerca a esplorare questo approccio alternativo alla modellizzazione del linguaggio.

Collaborative Reasoner: Meta avanza di agenti AI socialmente integrati

La versione finale, Collaborative Reasoner, affronta la complessa sfida della creazione di agenti di intelligenza artificiale che possono collaborare efficacemente con umani o altri IA.

Meta nota che la collaborazione umana spesso produce risultati superiori e mira a imbevere l'IA con capacità simili per compiti come aiutare con i compiti a casa o la preparazione di un colloquio di lavoro.

Tale collaborazione richiede non solo capacità di risoluzione dei problemi, ma anche abilità sociali come la comunicazione, l'empatia, la fornitura di feedback e la comprensione degli stati mentali degli altri (teoria della mente), spesso si svolgono su più turni di conversazione.

Gli attuali metodi di formazione e valutazione LLM spesso trascurano questi aspetti sociali e collaborativi. Inoltre, la raccolta di dati di conversazione pertinenti è costoso e difficile.

Collaborative Reasoner fornisce un quadro per valutare e migliorare queste abilità. Include compiti orientati agli obiettivi che richiedono ragionamenti a più fasi raggiunti attraverso la conversazione tra due agenti. Il framework mette in discussione abilità come non sono in disaccordo in modo costruttivo, persuaso un partner e raggiungendo una soluzione migliore condivisa.

Le valutazioni di Meta hanno rivelato che i modelli attuali lottano per sfruttare costantemente la collaborazione per risultati migliori. Per affrontare questo, propongono una tecnica di auto-miglioramento utilizzando dati di interazione sintetica in cui un agente LLM collabora con se stesso.

La generazione di questi dati su scala è abilitata da un nuovo motore al servizio del modello ad alte prestazioni chiamato Matrix. Secondo quanto riferito, l'uso di questo approccio sui compiti di matematica, scientifici e ragionamenti sociali ha prodotto miglioramenti fino al 29,4% rispetto alle prestazioni standard di “catena di pensiero” di un singolo LLM.

Open-sourcing della generazione di dati e della modellazione della pipeline, Meta mira a favorire ulteriori ricerche sulla creazione di “agenti sociali veramente che possono collaborare con umani e altri agenti”.

Queste cinque uscite sottolineano collettivamente i continui investimenti di Meta nella ricerca fondamentale dell'IA, in particolare concentrandosi su elementi costitutivi per macchine che possono percepire, comprendere e interagire con il mondo in modi più umani.

Vedi anche: Meta formerà i modelli AI utilizzando i dati dell'utente UE

Vuoi saperne di più sull'intelligenza artificiale e sui big da parte dei leader del settore? Guardare AI e Big Data Expo si svolge ad Amsterdam, in California e a Londra. L'evento completo è co-localizzato con altri eventi principali tra cui Conferenza di automazione intelligente, Blockx, Settimana di trasformazione digitaleE Cyber Security & Cloud Expo.

Esplora altri prossimi eventi tecnologici aziendali e webinar alimentati da TechForge Qui.

Fonte: www.artificialintelligence-news.com