Meta e Oracle stanno aggiornando i propri data center IA con gli switch di rete Ethernet Spectrum-X di NVIDIA, una tecnologia creata per gestire le crescenti richieste di sistemi IA su larga scala. Entrambe le società stanno adottando Spectrum-X come parte di un framework di rete aperto progettato per migliorare l’efficienza della formazione sull’intelligenza artificiale e accelerare l’implementazione in enormi cluster di elaborazione.

Jensen Huang, fondatore e CEO di NVIDIA, ha affermato che i modelli da trilioni di parametri stanno trasformando i data center in “fabbriche di intelligenza artificiale su scala gigante”, aggiungendo che Spectrum-X funge da “sistema nervoso” che collega milioni di GPU per addestrare i modelli più grandi mai costruiti.

Oracle prevede di utilizzare Spectrum-X Ethernet con la sua architettura Vera Rubin per costruire fabbriche di intelligenza artificiale su larga scala. Mahesh Thiagarajan, vicepresidente esecutivo di Oracle Cloud Infrastructure, ha affermato che la nuova configurazione consentirà all’azienda di connettere milioni di GPU in modo più efficiente, aiutando i clienti ad addestrare e implementare nuovi modelli di intelligenza artificiale più rapidamente.

Meta, nel frattempo, sta espandendo la propria infrastruttura AI integrando gli switch Ethernet Spectrum-X nel Facebook Open Switching System (FBOSS), la sua piattaforma interna per la gestione degli switch di rete su larga scala. Secondo Gaya Nagarajan, vicepresidente dell’ingegneria di rete di Meta, la rete di prossima generazione dell’azienda deve essere aperta ed efficiente per supportare modelli di intelligenza artificiale sempre più grandi e fornire servizi a miliardi di utenti.

Costruire sistemi di intelligenza artificiale flessibili

Secondo Joe DeLaere, a capo del portfolio di soluzioni di calcolo accelerato per data center di NVIDIA, la flessibilità è fondamentale man mano che i data center diventano sempre più complessi. Ha spiegato che il sistema MGX di NVIDIA offre un design modulare a blocchi che consente ai partner di combinare diverse CPU, GPU, storage e componenti di rete secondo necessità.

Il sistema promuove inoltre l’interoperabilità, consentendo alle organizzazioni di utilizzare lo stesso design su più generazioni di hardware. “Offre flessibilità, time-to-market più rapido e preparazione futura”, ha affermato DeLaere ai media.

Man mano che i modelli di intelligenza artificiale diventano più grandi, l’efficienza energetica è diventata una sfida centrale per i data center. DeLaere ha affermato che NVIDIA sta lavorando “dal chip alla rete” per migliorare l’utilizzo dell’energia e la scalabilità, collaborando a stretto contatto con i fornitori di alimentazione e raffreddamento per massimizzare le prestazioni per watt.

Un esempio è il passaggio all’erogazione di energia elettrica a 800 volt CC, che riduce la perdita di calore e migliora l’efficienza. L’azienda sta inoltre introducendo una tecnologia di livellamento energetico per ridurre i picchi sulla rete elettrica, un approccio che può ridurre il fabbisogno energetico massimo fino al 30%, consentendo una maggiore capacità di elaborazione con lo stesso ingombro.

Scalare verso l’alto, verso l’esterno e attraverso

Anche il sistema MGX di NVIDIA gioca un ruolo nel modo in cui i data center vengono scalati. Gilad Shainer, vicepresidente senior del networking dell’azienda, ha dichiarato ai media che i rack MGX ospitano sia componenti di elaborazione che di commutazione, supportando NVLink per la connettività scalabile e Spectrum-X Ethernet per la crescita scalabile.

Ha aggiunto che MGX può connettere più data center AI insieme come un sistema unificato: ciò di cui aziende come Meta hanno bisogno per supportare massicce operazioni di formazione AI distribuite. A seconda della distanza, possono collegare i siti tramite fibra spenta o switch aggiuntivi basati su MGX, consentendo connessioni ad alta velocità tra regioni.

L’adozione di Spectrum-X da parte dell’intelligenza artificiale da parte di Meta riflette la crescente importanza delle reti aperte. Shainer ha affermato che la società utilizzerà FBOSS come sistema operativo di rete, ma ha notato che Spectrum-X ne supporta molti altri, tra cui Cumulus, SONiC e NOS di Cisco attraverso partnership. Questa flessibilità consente agli hyperscaler e alle aziende di standardizzare la propria infrastruttura utilizzando i sistemi che meglio si adattano ai propri ambienti.

Espansione dell’ecosistema dell’intelligenza artificiale

NVIDIA vede Spectrum-X come un modo per rendere l’infrastruttura AI più efficiente e accessibile su diverse scale. Shainer ha affermato che la piattaforma Ethernet è stata progettata specificamente per carichi di lavoro di intelligenza artificiale come training e inferenza, offrendo fino al 95% di larghezza di banda effettiva e superando di gran lunga la tradizionale Ethernet.

Ha aggiunto che le partnership di NVIDIA con aziende come Cisco, xAI, Meta e Oracle Cloud Infrastructure stanno contribuendo a portare Spectrum-X in una gamma più ampia di ambienti, dagli hyperscaler alle imprese.

Preparazione per Vera Rubin e oltre

DeLaere ha affermato che l’imminente architettura Vera Rubin di NVIDIA dovrebbe essere disponibile in commercio nella seconda metà del 2026, con il prodotto Rubin CPX in arrivo entro la fine dell’anno. Entrambi lavoreranno insieme alla rete Spectrum-X e ai sistemi MGX per supportare la prossima generazione di fabbriche di intelligenza artificiale.

Ha inoltre chiarito che Spectrum-X e XGS condividono lo stesso hardware principale ma utilizzano algoritmi diversi per distanze variabili: Spectrum-X per i data center interni e XGS per la comunicazione tra data center. Questo approccio riduce al minimo la latenza e consente a più siti di operare insieme come un unico grande supercomputer AI.

Collaborare lungo la catena del potere

Per supportare la transizione a 800 volt CC, NVIDIA sta lavorando con partner dal livello del chip alla rete. L’azienda sta collaborando con Onsemi e Infineon sui componenti di alimentazione, con Delta, Flex e Lite-On a livello di rack e con Schneider Electric e Siemens sulla progettazione dei data center. Un libro bianco tecnico che descrive dettagliatamente questo approccio sarà pubblicato al vertice OCP.

DeLaere lo ha descritto come un “design olistico dal silicio all’erogazione di energia”, garantendo che tutti i sistemi funzionino perfettamente insieme negli ambienti AI ad alta densità gestiti da aziende come Meta e Oracle.

Vantaggi in termini di prestazioni per gli hyperscaler

Spectrum-X Ethernet è stato creato appositamente per l’elaborazione distribuita e i carichi di lavoro IA. Shainer ha affermato che offre routing adattivo e controllo della congestione basato sulla telemetria per eliminare gli hotspot di rete e fornire prestazioni stabili. Queste funzionalità consentono velocità di training e inferenza più elevate consentendo al tempo stesso l’esecuzione simultanea di più carichi di lavoro senza interferenze.

Ha aggiunto che Spectrum-X è l’unica tecnologia Ethernet che ha dimostrato di essere scalabile a livelli estremi, aiutando le organizzazioni a ottenere le migliori prestazioni e il miglior ritorno sugli investimenti nella GPU. Per gli hyperscaler come Meta, questa scalabilità aiuta a gestire le crescenti richieste di formazione sull’intelligenza artificiale e a mantenere efficiente l’infrastruttura.

Hardware e software lavorano insieme

Sebbene l’attenzione di NVIDIA sia spesso rivolta all’hardware, DeLaere afferma che l’ottimizzazione del software è altrettanto importante. L’azienda continua a migliorare le prestazioni attraverso la co-progettazione, allineando lo sviluppo di hardware e software per massimizzare l’efficienza dei sistemi di intelligenza artificiale.

NVIDIA sta investendo in kernel FP4, framework come Dynamo e TensorRT-LLM e algoritmi come la decodifica speculativa per migliorare il throughput e le prestazioni del modello AI. Questi aggiornamenti, ha affermato, garantiscono che sistemi come Blackwell continuino a fornire risultati migliori nel tempo per hyperscaler come Meta che si affidano a prestazioni IA costanti.

Networking per l’era dei trilioni di parametri

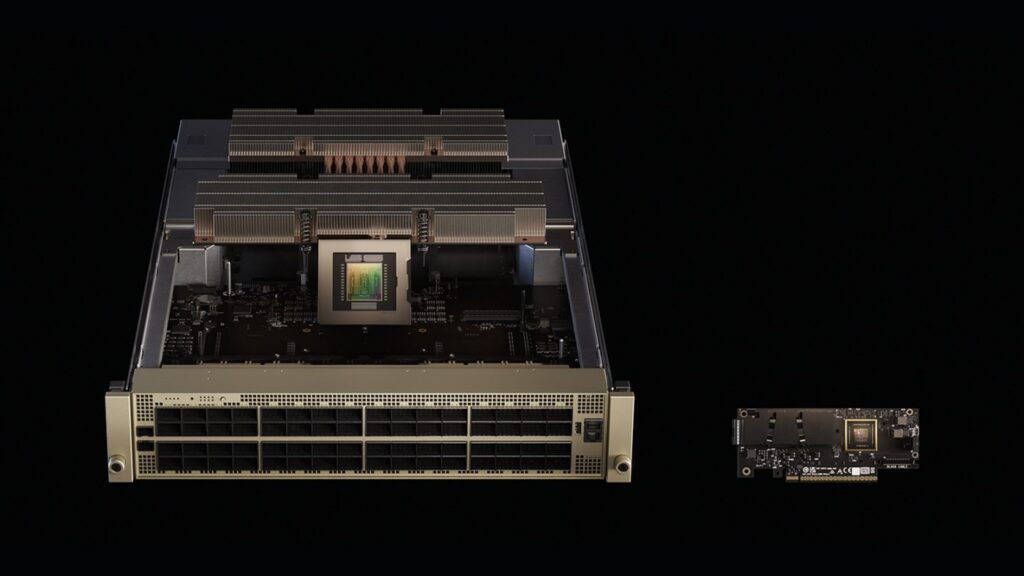

La piattaforma Spectrum-X, che include switch Ethernet e SuperNIC, è il primo sistema Ethernet di NVIDIA creato appositamente per i carichi di lavoro IA. È progettato per collegare milioni di GPU in modo efficiente mantenendo prestazioni prevedibili nei data center AI.

Con la tecnologia di controllo della congestione che raggiunge un throughput di dati fino al 95%, Spectrum-X segna un grande passo avanti rispetto a Ethernet standard, che in genere raggiunge solo circa il 60% a causa delle collisioni di flusso. La sua tecnologia XGS supporta anche collegamenti di data center AI a lunga distanza, collegando strutture in diverse regioni in “super fabbriche AI” unificate.

Unendo insieme l’intero stack NVIDIA (GPU, CPU, NVLink e software), Spectrum-X fornisce le prestazioni costanti necessarie per supportare modelli da trilioni di parametri e la prossima ondata di carichi di lavoro di intelligenza artificiale generativa.

(Foto di Nvidia)

Vuoi saperne di più sull’intelligenza artificiale e sui big data dai leader del settore? Guardare Fiera dell’intelligenza artificiale e dei big data che si svolge ad Amsterdam, in California, e a Londra. L’evento completo è parte di TechEx ed è situato in concomitanza con altri importanti eventi tecnologici, clicca Qui per ulteriori informazioni

AI News è alimentato da Media TechForge. Esplora altri prossimi eventi e webinar sulla tecnologia aziendale Qui.

Fonte: www.artificialintelligence-news.com