Secondo un nuovo rapporto del Threat Intelligence Group (GTIG) di Google, gli hacker sponsorizzati dallo stato stanno sfruttando l’intelligenza artificiale per accelerare gli attacchi informatici, con attori provenienti da Iran, Corea del Nord, Cina e Russia che utilizzano modelli come Gemini di Google per creare sofisticate campagne di phishing e sviluppare malware.

Il rapporto trimestrale AI Threat Tracker, pubblicato oggi, rivela come gli aggressori sostenuti dal governo hanno integrato l’intelligenza artificiale durante tutto il ciclo di vita dell’attacco, ottenendo incrementi di produttività nella ricognizione, nell’ingegneria sociale e nello sviluppo di malware durante l’ultimo trimestre del 2025.

“Per gli autori delle minacce sostenuti dal governo, i modelli linguistici di grandi dimensioni sono diventati strumenti essenziali per la ricerca tecnica, il targeting e la rapida generazione di esche di phishing sfumate”, hanno affermato i ricercatori di GTIG nel rapporto.

La ricognizione basata sull’intelligenza artificiale da parte di hacker sponsorizzati dallo stato prende di mira il settore della difesa

L’attore iraniano APT42 ha utilizzato Gemini per potenziare la ricognizione e mirare a operazioni di ingegneria sociale. Il gruppo ha utilizzato in modo improprio il modello di intelligenza artificiale per enumerare gli indirizzi e-mail ufficiali di entità specifiche e condurre ricerche per stabilire pretesti credibili per avvicinarsi agli obiettivi.

Fornendo a Gemini la biografia di un bersaglio, APT42 ha creato personaggi e scenari progettati per suscitare coinvolgimento. Il gruppo ha utilizzato l’intelligenza artificiale anche per tradurre tra lingue diverse e comprendere meglio frasi non native, abilità che aiutano gli hacker sponsorizzati dallo stato a aggirare i tradizionali segnali di allarme del phishing, come la grammatica scadente o la sintassi scomoda.

L’attore UNC2970, sostenuto dal governo nordcoreano, che si concentra sugli attacchi alla difesa e sull’imitazione di reclutatori aziendali, ha utilizzato Gemini per sintetizzare intelligence open source e profilare obiettivi di alto valore. La ricognizione del gruppo ha incluso la ricerca di informazioni sulle principali aziende di sicurezza informatica e di difesa, la mappatura di specifici ruoli professionali tecnici e la raccolta di informazioni sugli stipendi.

“Questa attività offusca la distinzione tra ricerca professionale di routine e ricognizione dannosa, poiché l’autore raccoglie i componenti necessari per creare personaggi di phishing su misura e ad alta fedeltà”, ha osservato GTIG.

Aumentano gli attacchi di estrazione dei modelli

Oltre all’uso improprio operativo, Google DeepMind e GTIG hanno identificato un aumento dei tentativi di estrazione di modelli – noti anche come “attacchi di distillazione” – volti a rubare la proprietà intellettuale dai modelli di intelligenza artificiale.

Una campagna mirata alle capacità di ragionamento dei Gemelli ha coinvolto oltre 100.000 suggerimenti progettati per costringere il modello a produrre processi di ragionamento completi. L’ampiezza delle domande ha suggerito un tentativo di replicare la capacità di ragionamento dei Gemelli in lingue target diverse dall’inglese in vari compiti.

Sebbene GTIG non abbia osservato attacchi diretti ai modelli di frontiera da parte di attori di minacce persistenti avanzate, il team ha identificato e interrotto frequenti attacchi di estrazione di modelli da parte di entità del settore privato a livello globale e di ricercatori che cercavano di clonare la logica proprietaria.

I sistemi di Google hanno riconosciuto questi attacchi in tempo reale e hanno implementato difese per proteggere le tracce del ragionamento interno.

Emerge malware integrato nell’intelligenza artificiale

GTIG ha osservato campioni di malware, tracciati come HONESTCUE, che utilizzano l’API di Gemini per esternalizzare la generazione di funzionalità. Il malware è progettato per indebolire il tradizionale rilevamento basato sulla rete e l’analisi statica attraverso un approccio di offuscamento a più livelli.

HONESTCUE funziona come un framework di download e avvio che invia richieste tramite l’API di Gemini e riceve il codice sorgente C# come risposte. La fase secondaria senza file compila ed esegue i payload direttamente in memoria, senza lasciare artefatti sul disco.

Separatamente, GTIG ha identificato COINBAIT, un kit di phishing la cui costruzione è stata probabilmente accelerata dagli strumenti di generazione del codice AI. Il kit, che si maschera da importante scambio di criptovaluta per la raccolta di credenziali, è stato realizzato utilizzando la piattaforma basata sull’intelligenza artificiale Lovable AI.

Le campagne ClickFix abusano delle piattaforme di chat AI

In una nuova campagna di ingegneria sociale osservata per la prima volta nel dicembre 2025, Google ha visto gli autori delle minacce abusare delle funzionalità di condivisione pubblica dei servizi di intelligenza artificiale generativa – tra cui Gemini, ChatGPT, Copilot, DeepSeek e Grok – per ospitare contenuti ingannevoli che distribuiscono malware ATOMIC mirato ai sistemi macOS.

Gli aggressori hanno manipolato modelli di intelligenza artificiale per creare istruzioni dall’aspetto realistico per attività comuni del computer, incorporando script dannosi da riga di comando come “soluzione”. Creando collegamenti condivisibili a queste trascrizioni di chat AI, gli autori delle minacce hanno utilizzato domini attendibili per ospitare la fase iniziale dell’attacco.

Il mercato sotterraneo prospera grazie alle chiavi API rubate

Le osservazioni di GTIG sui forum clandestini in lingua inglese e russa indicano una domanda persistente di strumenti e servizi abilitati all’intelligenza artificiale. Tuttavia, gli hacker e i criminali informatici sponsorizzati dallo stato faticano a sviluppare modelli di intelligenza artificiale personalizzati, affidandosi invece a prodotti commerciali maturi a cui si accede tramite credenziali rubate.

Un toolkit, “Xanthorox”, si è pubblicizzato come un’intelligenza artificiale personalizzata per la generazione autonoma di malware e lo sviluppo di campagne di phishing. L’indagine di GTIG ha rivelato che Xanthorox non era un modello su misura ma in realtà alimentato da diversi prodotti commerciali di intelligenza artificiale, tra cui Gemini, a cui si accedeva tramite chiavi API rubate.

La risposta e le mitigazioni di Google

Google è intervenuta contro gli autori delle minacce identificati disabilitando account e risorse associati ad attività dannose. L’azienda ha inoltre applicato l’intelligence per rafforzare sia i classificatori che i modelli, consentendo loro di rifiutare assistenza per attacchi simili in futuro.\

“Ci impegniamo a sviluppare l’intelligenza artificiale in modo coraggioso e responsabile, il che significa adottare misure proattive per interrompere attività dannose disabilitando i progetti e gli account associati a malintenzionati, migliorando continuamente i nostri modelli per renderli meno suscettibili ad abusi”, afferma il rapporto.

Il GTIG ha sottolineato che, nonostante questi sviluppi, nessun attore dell’APT o delle operazioni di informazione ha raggiunto capacità rivoluzionarie che alterano radicalmente il panorama delle minacce.

I risultati sottolineano il ruolo in evoluzione dell’intelligenza artificiale nella sicurezza informatica, poiché sia i difensori che gli aggressori fanno a gara per utilizzare le capacità della tecnologia.

Per i team di sicurezza aziendale, in particolare nella regione Asia-Pacifico dove rimangono attivi gli hacker sponsorizzati dallo stato cinese e nordcoreano, il rapporto funge da importante promemoria per rafforzare le difese contro l’ingegneria sociale e le operazioni di ricognizione potenziate dall’intelligenza artificiale.

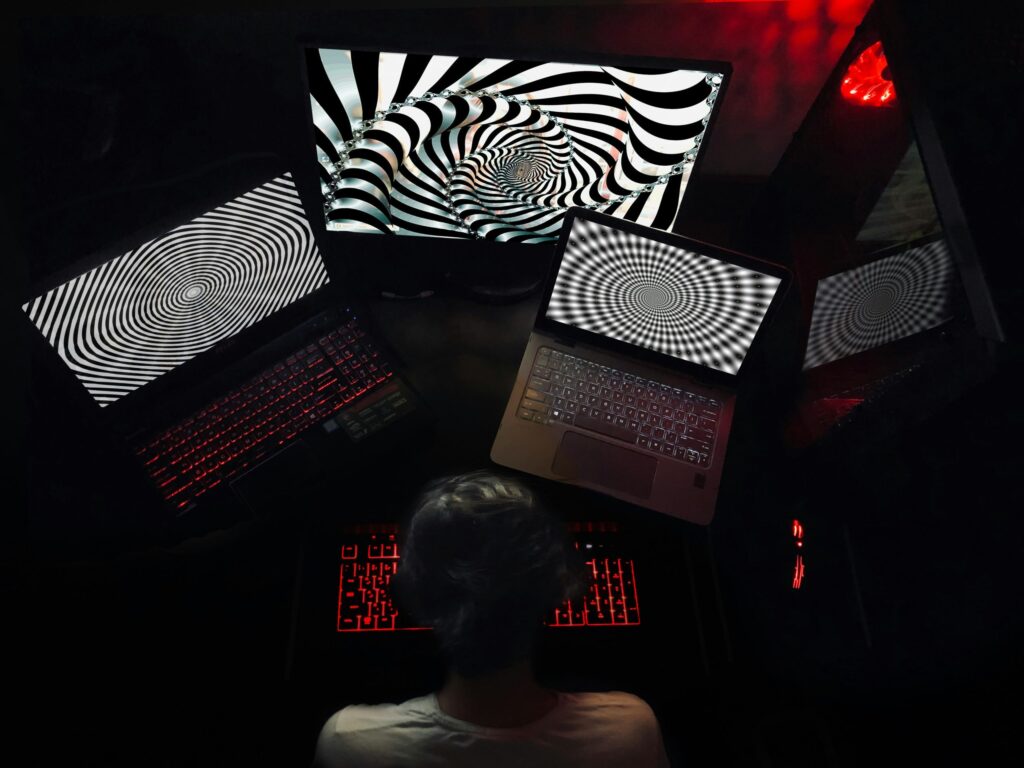

(Foto di Opere di SPAVENCROW)

Vuoi saperne di più sull’intelligenza artificiale e sui big data dai leader del settore? Guardare Fiera dell’intelligenza artificiale e dei big data che si svolge ad Amsterdam, in California, e a Londra. L’evento completo è parte di TechEx ed è situato in concomitanza con altri importanti eventi tecnologici, clicca Qui per ulteriori informazioni

AI News è alimentato da Media TechForge. Esplora altri prossimi eventi e webinar sulla tecnologia aziendale Qui.

Fonte: www.artificialintelligence-news.com