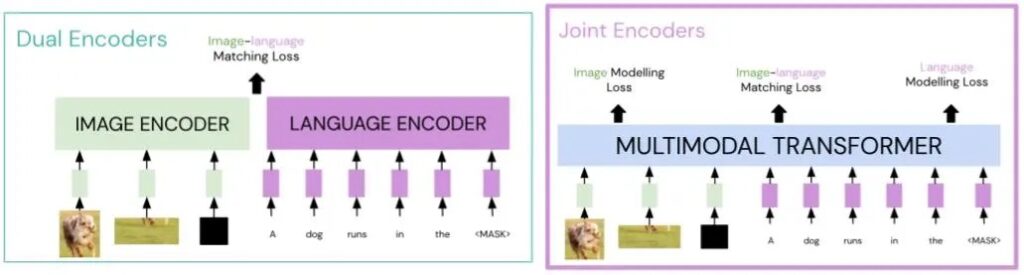

La capacità di radicare il linguaggio alla visione è un aspetto fondamentale dei sistemi di intelligenza artificiale del mondo reale; è utile in una serie di attività (per esempiorisposte visive alle domande) e applicazioni (per esempiogenerare descrizioni per non vedenti). I modelli multimodali (pre-addestrati su coppie immagine-linguaggio) mirano ad affrontare questo problema di base. Una recente famiglia di modelli, i trasformatori multimodali (ad esempio, Lu et al., 2019; Chen et al., 2020; Tan e Bansal, 2019; Li et al., 2020), hanno raggiunto prestazioni all’avanguardia in una serie di parametri di riferimento multimodali, suggerendo che l’architettura del trasformatore con codificatore congiunto è più adatta per catturare l’allineamento tra coppie immagine-linguaggio rispetto agli approcci precedenti (come i doppi codificatori).

In particolare, rispetto all’architettura a doppio codificatore in cui non vi è diafonia tra le modalità, i trasformatori multimodali (codificatori congiunti) sono più efficienti in termini di campionamento. Nel grafico seguente, vediamo che, quando testato sul recupero di immagini zero-shot, un trasformatore multimodale esistente (UNITER) funziona in modo simile a un doppio codificatore su larga scala (CLIP) che viene addestrato su 100 volte più dati.

In questo lavoro, esaminiamo quali aspetti dei trasformatori multimodali – attenzione, perdite e dati di pre-addestramento – sono importanti per il loro successo nel preaddestramento multimodale. Troviamo che l’attenzione multimodale, in cui sia il linguaggio che i trasformatori dell’immagine si prestano attenzione l’uno all’altro, è cruciale per il successo di questi modelli. I modelli con altri tipi di attenzione (anche con maggiore profondità o parametri) non riescono a ottenere risultati paragonabili ai modelli meno profondi e più piccoli con attenzione multimodale. Inoltre, è possibile ottenere risultati comparabili senza la perdita di immagine (modellazione della regione mascherata) originariamente proposta per i trasformatori multimodali. Ciò suggerisce che i nostri attuali modelli non stanno sfruttando il segnale utile nella modalità immagine, presumibilmente a causa della formulazione della perdita di immagine.

Studiamo anche diverse proprietà dei set di dati multimodali come la loro dimensione e il grado in cui il linguaggio descrive l’immagine corrispondente (rumore). Troviamo che la dimensione di un set di dati non sempre prevede le prestazioni dei trasformatori multimodali; il suo livello di rumore e la somiglianza del linguaggio con il compito di valutazione sono entrambi importanti fattori che contribuiscono. Questi suggeriscono che la cura di set di dati di immagini e testi meno rumorosi sia importante nonostante l’attuale tendenza a raccogliere set di dati rumorosi dal web.

Nel complesso, la nostra analisi mostra che i trasformatori multimodali sono più forti dell’architettura a doppio codificatore (data la stessa quantità di dati di pre-addestramento), principalmente a causa del cross-talk attraverso l’attenzione multimodale. Tuttavia, ci sono ancora molti problemi aperti quando si progettano modelli multimodali, tra cui migliori perdite per la modalità dell’immagine e la robustezza al rumore del set di dati.