Annuncio di una suite completa e aperta di codificatori automatici sparsi per l’interpretabilità del modello linguistico.

Per creare un modello linguistico di intelligenza artificiale (AI), i ricercatori costruiscono un sistema che impara da grandi quantità di dati senza la guida umana. Di conseguenza, il funzionamento interno dei modelli linguistici è spesso un mistero, anche per i ricercatori che li sviluppano. L’interpretabilità meccanicistica è un campo di ricerca focalizzato sulla decifrazione di questi meccanismi interni. I ricercatori in questo campo utilizzano gli autocodificatori sparsi come una sorta di “microscopio” che consente loro di vedere all’interno di un modello linguistico e di avere un’idea migliore di come funziona.

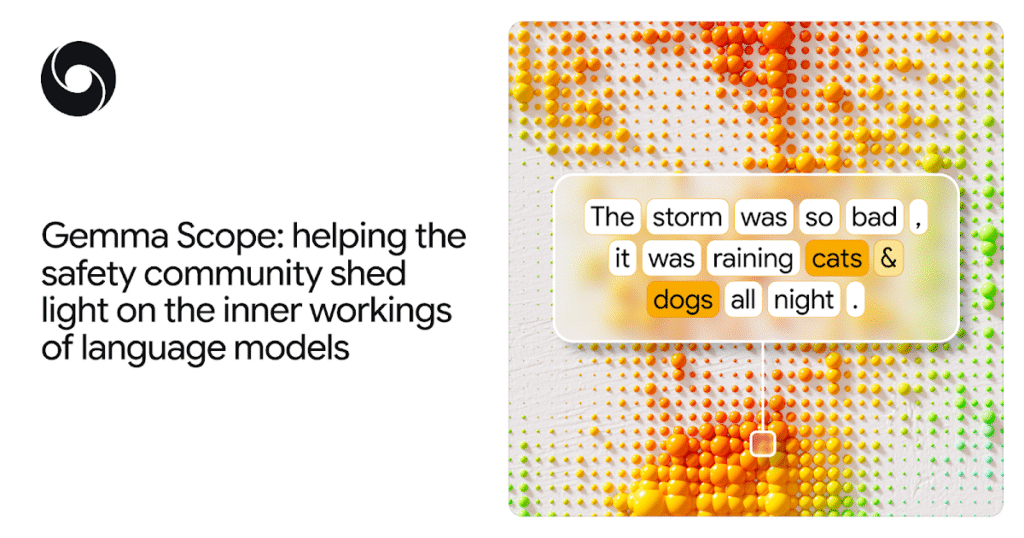

Oggi, stiamo annunciando Gemma Scopeuna nuova serie di strumenti per aiutare i ricercatori a comprendere il funzionamento interno di Gemma 2, la nostra famiglia leggera di modelli aperti. Gemma Scope è una raccolta di centinaia di codificatori automatici sparsi (SAE) aperti e disponibili gratuitamente per Gemma29B E Gemma222B. Siamo anche open source Mishaxuno strumento che abbiamo creato e che ha consentito gran parte del lavoro di interpretabilità dietro Gemma Scope.

Ci auguriamo che la versione odierna consenta una ricerca sull’interpretabilità più ambiziosa. Ulteriori ricerche hanno il potenziale per aiutare il campo a costruire sistemi più robusti, sviluppare migliori garanzie contro le allucinazioni modello e proteggere dai rischi derivanti da agenti di intelligenza artificiale autonomi come l’inganno o la manipolazione.

Prova la nostra demo interattiva Gemma Scopeper gentile concessione di Neuronpedia.

Interpretare ciò che accade all’interno di un modello linguistico

Quando fai una domanda a un modello linguistico, il tuo input di testo si trasforma in una serie di “attivazioni”. Queste attivazioni mappano le relazioni tra le parole inserite, aiutando il modello a creare connessioni tra parole diverse, che utilizza per scrivere una risposta.

Man mano che il modello elabora l’input di testo, le attivazioni a diversi livelli nella rete neurale del modello rappresentano molteplici concetti sempre più avanzati, noti come “caratteristiche”.

Ad esempio, i primi strati di un modello potrebbero imparare a farlo ricordare i fatti così Michael Jordan gioca a basketmentre gli strati successivi possono riconoscere concetti più complessi come la fattualità del testo.

Fonte: deepmind.google