Robotic Transformer 2 (RT-2) è un nuovo modello di visione-linguaggio-azione (VLA) che apprende sia dai dati web che da quelli robotici e traduce questa conoscenza in istruzioni generalizzate per il controllo robotico.

I modelli visione-linguaggio (VLM) ad alta capacità vengono addestrati su set di dati su scala web, rendendo questi sistemi straordinariamente efficaci nel riconoscere modelli visivi o linguistici e nel funzionare in diverse lingue. Ma affinché i robot raggiungano un livello simile di competenza, dovrebbero raccogliere dati personali, in prima persona, su ogni oggetto, ambiente, attività e situazione.

Nel nostro cartapresentiamo Robotic Transformer 2 (RT-2), un nuovo modello di visione-linguaggio-azione (VLA) che apprende sia dai dati web che da quelli robotici e traduce questa conoscenza in istruzioni generalizzate per il controllo robotico, pur mantenendo funzionalità su scala web.

Questo lavoro si basa su Robotic Transformer 1 (RT-1)un modello addestrato su dimostrazioni multi-task, che può apprendere combinazioni di compiti e oggetti visti nei dati robotici. Più specificamente, il nostro lavoro ha utilizzato dati dimostrativi del robot RT-1 raccolti con 13 robot nell’arco di 17 mesi in un ambiente di cucina d’ufficio.

RT-2 mostra capacità di generalizzazione e comprensione semantica e visiva migliorate oltre i dati robotici a cui è stato esposto. Ciò include l’interpretazione di nuovi comandi e la risposta ai comandi dell’utente eseguendo ragionamenti rudimentali, come ragionamenti su categorie di oggetti o descrizioni di alto livello.

Mostriamo anche che incorporare il ragionamento basato sulla catena di pensiero consente a RT-2 di eseguire un ragionamento semantico in più fasi, come decidere quale oggetto potrebbe essere utilizzato come un martello improvvisato (una roccia) o quale tipo di bevanda è migliore per una persona stanca. (una bevanda energetica).

Adattare i VLM per il controllo robotico

RT-2 si basa su VLM che accettano una o più immagini come input e produce una sequenza di token che, convenzionalmente, rappresentano il testo in linguaggio naturale. Tali VLM sono stati addestrato con successo sui dati su scala web per eseguire attività, come la risposta visiva a domande, la didascalia delle immagini o il riconoscimento di oggetti. Nel nostro lavoro, adattiamo il modello di linguaggio e immagine di Pathways (PaLI-X) e il modello del linguaggio Pathways Emfilled (PaLM-E) per fungere da spina dorsale di RT-2.

Per controllare un robot, è necessario addestrarlo a eseguire azioni. Affrontiamo questa sfida rappresentando le azioni come token nell’output del modello, simili ai token del linguaggio, e descrivendo le azioni come stringhe che possono essere elaborate secondo gli standard tokenizzatori del linguaggio naturalemostrato qui:

La stringa inizia con un flag che indica se continuare o terminare l’episodio in corso, senza eseguire i comandi successivi, e prosegue con i comandi per modificare la posizione e la rotazione dell’end-effector, nonché l’estensione desiderata della pinza del robot.

Utilizziamo la stessa versione discretizzata delle azioni del robot di RT-1 e mostriamo che convertirla in una rappresentazione di stringa rende possibile addestrare modelli VLM su dati robotici, poiché gli spazi di input e output di tali modelli non devono essere cambiato.

Generalizzazione e abilità emergenti

Abbiamo eseguito una serie di esperimenti qualitativi e quantitativi sui nostri modelli RT-2, su oltre 6.000 prove robotiche. Esplorando le capacità emergenti di RT-2, abbiamo prima cercato compiti che richiedessero la combinazione di conoscenze provenienti da dati su scala web e esperienza del robot, quindi abbiamo definito tre categorie di abilità: comprensione dei simboli, ragionamento e riconoscimento umano.

Ciascun compito richiedeva la comprensione di concetti visivo-semantici e la capacità di eseguire il controllo robotico per operare su tali concetti. Comandi come “raccogli la borsa che sta per cadere dal tavolo” o “muovi la banana per la somma di due più uno” – dove al robot viene chiesto di eseguire un compito di manipolazione su oggetti o scenari mai visti nei dati robotici – richiesti conoscenza tradotta da dati basati sul web per operare.

In tutte le categorie, abbiamo osservato un aumento delle prestazioni di generalizzazione (miglioramento di oltre 3 volte) rispetto ai precedenti riferimenti, come i precedenti modelli RT-1 e modelli come Visual Cortex (VC-1), che sono stati pre-addestrati su set di dati visivi di grandi dimensioni.

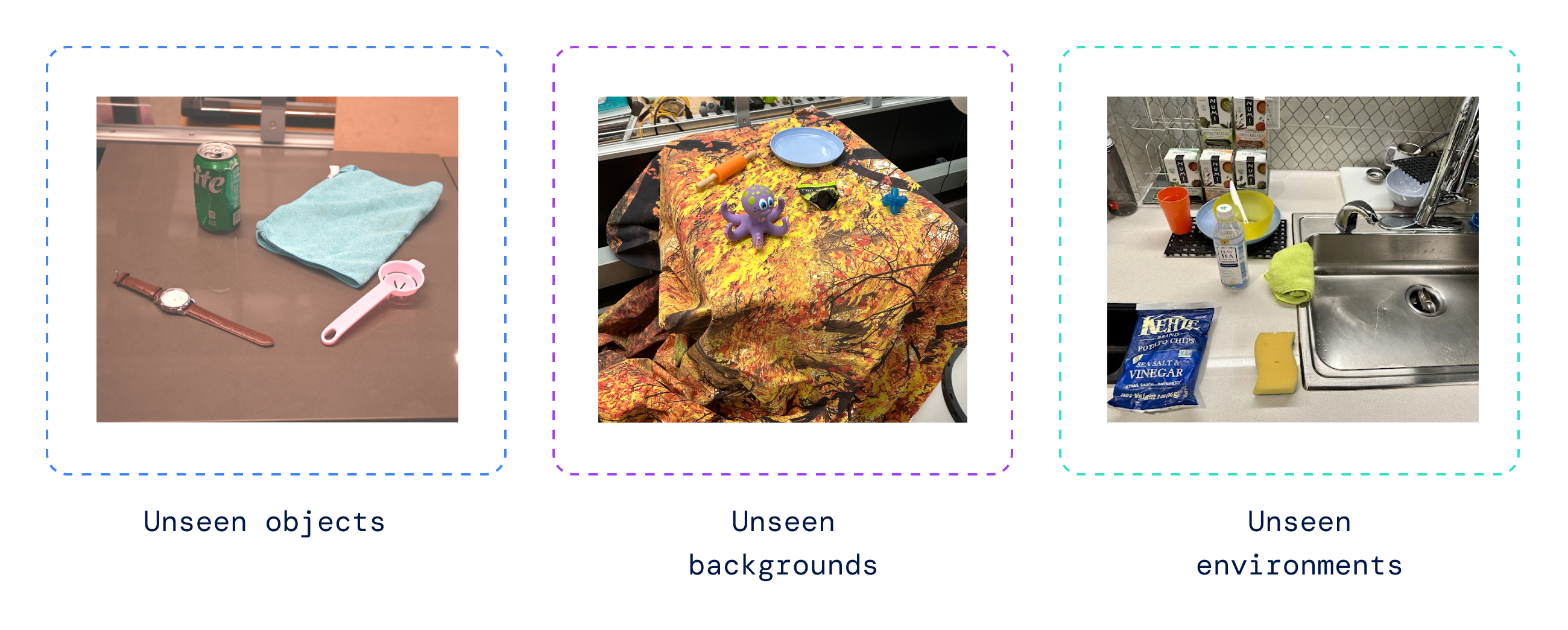

Abbiamo anche eseguito una serie di valutazioni quantitative, iniziando con i compiti originali di RT-1, per i quali abbiamo esempi nei dati del robot, e continuando con vari gradi di oggetti, sfondi e ambienti mai visti prima dal robot che richiedevano al robot di imparare la generalizzazione dalla pre-formazione VLM.

RT-2 ha mantenuto le prestazioni sui compiti originali osservate nei dati del robot e ha migliorato le prestazioni del robot su scenari mai visti prima, dal 32% al 62% di RT-1, mostrando il notevole vantaggio del pre-addestramento su larga scala.

Inoltre, abbiamo osservato miglioramenti significativi rispetto ai valori di riferimento pre-addestrati su compiti esclusivamente visivi, come VC-1 e Rappresentazioni riutilizzabili per la manipolazione robotica (R3M) e algoritmi che utilizzano VLM per l’identificazione degli oggetti, come la manipolazione di oggetti open-world (MUGGIRE).

Valutare il nostro modello sull’open source Tabella delle lingue suite di attività robotiche, abbiamo raggiunto un tasso di successo del 90% nella simulazione, migliorando sostanzialmente rispetto ai precedenti valori di riferimento inclusi BC-Z (72%), RT-1 (74%) e LAVA (77%).

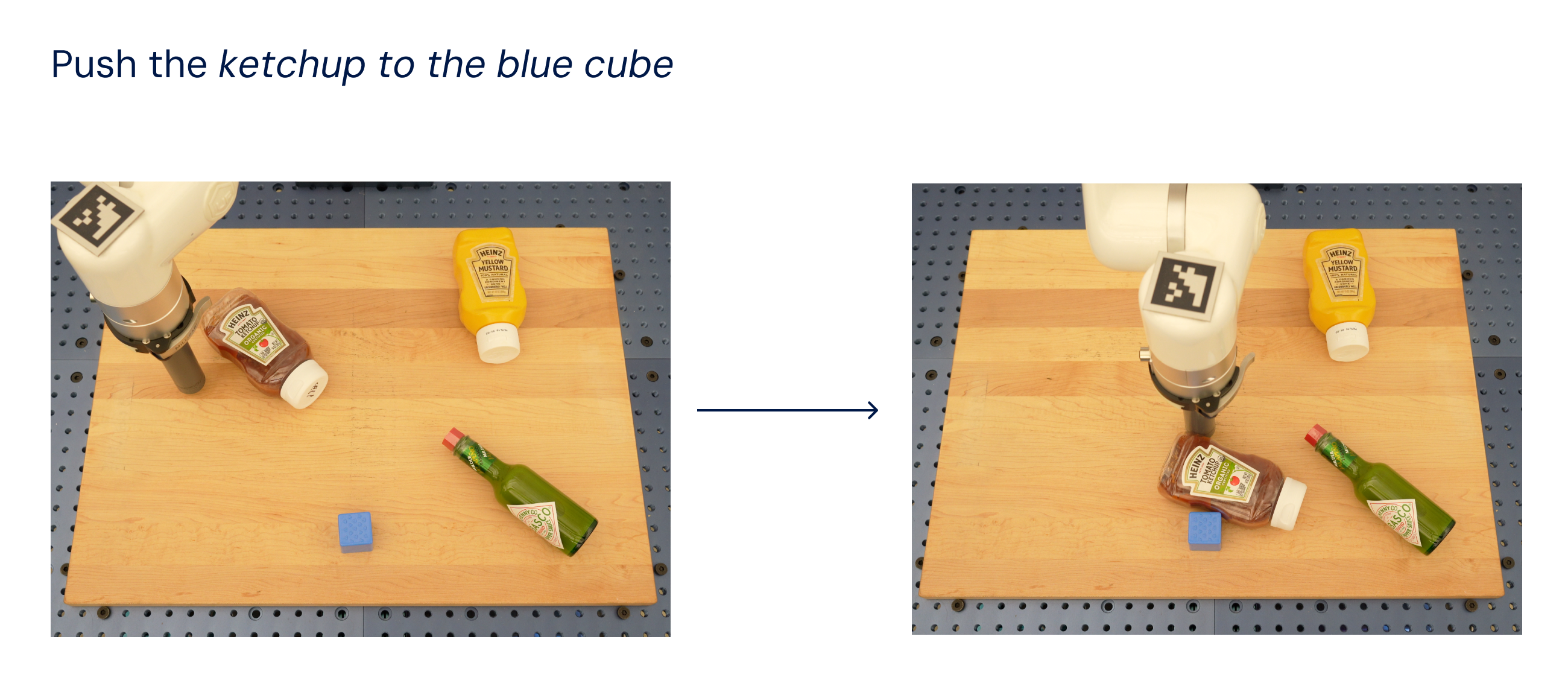

Quindi abbiamo valutato lo stesso modello nel mondo reale (poiché è stato addestrato su simulazione e dati reali) e abbiamo dimostrato la sua capacità di generalizzare a nuovi oggetti, come mostrato di seguito, dove nessuno degli oggetti tranne il cubo blu era presente nell’addestramento set di dati.

Ispirato da metodi di suggerimento della catena di pensiero utilizzati nei LLMabbiamo testato i nostri modelli per combinare il controllo robotico con il ragionamento basato sulla catena di pensiero per consentire l’apprendimento della pianificazione a lungo orizzonte e delle competenze di basso livello all’interno di un unico modello.

In particolare, abbiamo messo a punto una variante di RT-2 per poche centinaia di passaggi di gradiente per aumentare la sua capacità di utilizzare linguaggio e azioni congiuntamente. Quindi abbiamo aumentato i dati per includere un ulteriore passaggio di “Pianificazione”, descrivendo prima lo scopo dell’azione che il robot sta per intraprendere in linguaggio naturale, seguito da “Azione” e dai token di azione. Qui mostriamo un esempio di tale ragionamento e il comportamento risultante del robot:

Con questo processo, RT-2 può eseguire comandi più complessi che richiedono il ragionamento sui passaggi intermedi necessari per eseguire un’istruzione dell’utente. Grazie alla sua dorsale VLM, RT-2 può anche pianificare sia da comandi di immagine che di testo, consentendo una pianificazione visivamente fondata, mentre gli attuali approcci di pianificazione e azione come SayCan non riescono a vedere il mondo reale e si affidano interamente al linguaggio.

Avanzamento del controllo robotico

RT-2 mostra che i modelli visione-linguaggio (VLM) possono essere trasformati in potenti modelli visione-linguaggio-azione (VLA), che possono controllare direttamente un robot combinando il pre-addestramento VLM con i dati robotici.

Con due istanziazioni di VLA basate su PaLM-E e PaLI-X, RT-2 si traduce in politiche robotiche altamente migliorate e, cosa ancora più importante, porta a prestazioni di generalizzazione e capacità emergenti significativamente migliori, ereditate dalla pre-linguaggio di visione su scala web. -formazione.

RT-2 non è solo una modifica semplice ed efficace rispetto ai modelli VLM esistenti, ma mostra anche la promessa di costruire un robot fisico generico in grado di ragionare, risolvere problemi e interpretare informazioni per eseguire una vasta gamma di compiti nella realtà. mondo.