Durante l’esplorazione puramente curiosa, il braccio JACO scopre come raccogliere i cubi, spostarli nello spazio di lavoro ed esplorare anche se possono essere bilanciati sui bordi.

L’esplorazione curiosa consente a OP3 di camminare in posizione eretta, restare in equilibrio su un piede, sedersi e persino riprendersi in sicurezza quando si salta all’indietro, il tutto senza un compito specifico da ottimizzare.

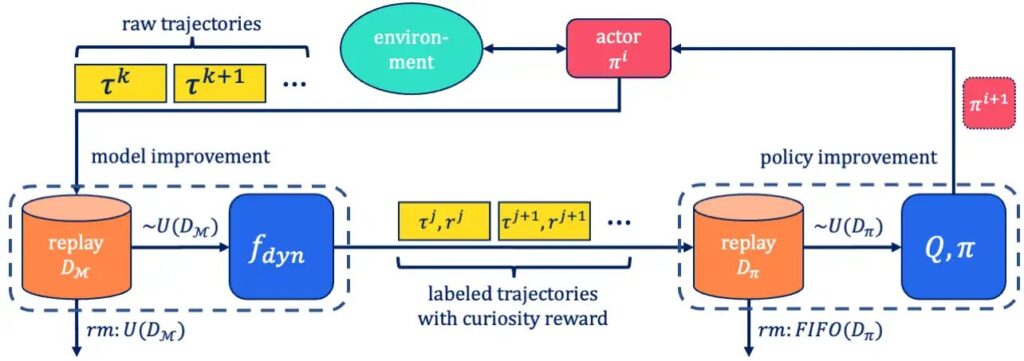

La motivazione intrinseca (1, 2) può essere un concetto potente per dotare un agente di un meccanismo per esplorare continuamente il suo ambiente in assenza di informazioni sul compito. Un modo comune per implementare la motivazione intrinseca è tramite l’apprendimento per curiosità (3, 4). Con questo metodo, un modello predittivo sulla risposta dell’ambiente alle azioni di un agente viene addestrato insieme alla politica dell’agente. Questo modello può anche essere chiamato modello mondiale. Quando viene intrapresa un’azione, il modello mondiale fa una previsione sulla successiva osservazione dell’agente. Questa previsione viene quindi confrontata con l’osservazione reale fatta dall’agente. Fondamentalmente, la ricompensa data all’agente per aver intrapreso questa azione è proporzionale all’errore commesso nel prevedere l’osservazione successiva. In questo modo, l’agente viene ricompensato per aver intrapreso azioni i cui esiti non sono ancora ben prevedibili. Allo stesso tempo, il modello mondiale viene aggiornato per prevedere meglio l’esito di tale azione.

Questo meccanismo è stato applicato con successo in contesti politici, ad esempio per gestire i giochi per computer 2D senza supervisione (4) o per elaborare una politica generale facilmente adattabile a compiti concreti a valle (5). Tuttavia, crediamo che la vera forza dell’apprendimento per curiosità risieda nel diverso comportamento che emerge durante il processo di esplorazione curiosa: man mano che l’obiettivo della curiosità cambia, cambia anche il comportamento risultante dell’agente, scoprendo così molte politiche complesse che potrebbero essere utilizzate in seguito, se fossero conservati e non sovrascritti.

in questo documentodiamo due contributi per studiare l’apprendimento per curiosità e sfruttare il suo comportamento emergente: in primo luogo, introduciamo focauna realizzazione fuori politica di un metodo di esplorazione automotivato e basato sulla curiosità. Mostriamo che utilizzando SelMo, un comportamento significativo e diversificato emerge esclusivamente sulla base dell’ottimizzazione dell’obiettivo della curiosità nei domini simulati di manipolazione e locomozione. In secondo luogo, proponiamo di estendere l’attenzione nell’applicazione dell’apprendimento per curiosità verso l’identificazione e il mantenimento di comportamenti intermedi emergenti. Supportiamo questa congettura con un esperimento che ricarica i comportamenti scoperti da soli come abilità ausiliarie preaddestrate in una configurazione di apprendimento con rinforzo gerarchico.

Eseguiamo SelMo in due domini robotici simulati a controllo continuo: su un braccio JACO da 6 DoF con una pinza a tre dita e su un robot umanoide da 20 DoF, l’OP3. Le rispettive piattaforme presentano ambienti di apprendimento stimolanti rispettivamente per la manipolazione degli oggetti e la locomozione. Ottimizzando solo per curiosità, osserviamo che nel corso dei cicli di formazione emerge un comportamento complesso interpretabile dall’uomo. Ad esempio, JACO impara a sollevare e spostare i cubi senza alcuna supervisione oppure l’OP3 impara a restare in equilibrio su un solo piede o a sedersi in sicurezza senza cadere.

.jpg)

.jpg)

Tuttavia, i comportamenti impressionanti osservati durante l’esplorazione curiosa presentano uno svantaggio cruciale: non sono persistenti poiché continuano a cambiare con la funzione di ricompensa della curiosità. Poiché l’agente continua a ripetere un certo comportamento, ad esempio JACO che solleva il cubo rosso, i premi per la curiosità accumulati da questa politica diminuiscono. Di conseguenza, questo porta all’apprendimento di una politica modificata che acquisisce nuovamente maggiori ricompense di curiosità, ad esempio spostando il cubo fuori dallo spazio di lavoro o addirittura occupandosi dell’altro cubo. Ma questo nuovo comportamento sovrascrive quello vecchio. Tuttavia, riteniamo che trattenere i comportamenti emergenti dall’esplorazione curiosa doti l’agente di una preziosa serie di competenze per apprendere nuovi compiti più rapidamente. Per indagare su questa congettura, abbiamo organizzato un esperimento per sondare l’utilità delle abilità scoperte da soli.

.jpg)

Trattiamo istantanee campionate casualmente da diverse fasi dell’esplorazione curiosa come abilità ausiliarie in un quadro di apprendimento modulare (7) e misuriamo la velocità con cui una nuova abilità target può essere appresa utilizzando tali ausiliari. Nel caso del braccio JACO, impostiamo il compito target su “sollevare il cubo rosso” e utilizziamo cinque comportamenti auto-scoperti campionati casualmente come ausiliari. Confrontiamo l’apprendimento di questo compito a valle con una linea di base SAC-X (8) che utilizza un curriculum di funzioni di ricompensa per premiare il raggiungimento e lo spostamento del cubo rosso che alla fine facilita l’apprendimento anche del sollevamento. Troviamo che anche questa semplice impostazione per il riutilizzo delle competenze accelera già il progresso dell’apprendimento del compito a valle, commisurato a un programma di ricompensa progettato manualmente. I risultati suggeriscono che l’identificazione automatica e il mantenimento di comportamenti utili emergenti dall’esplorazione curiosa sono una strada fruttuosa per l’indagine futura nell’apprendimento per rinforzo non supervisionato.