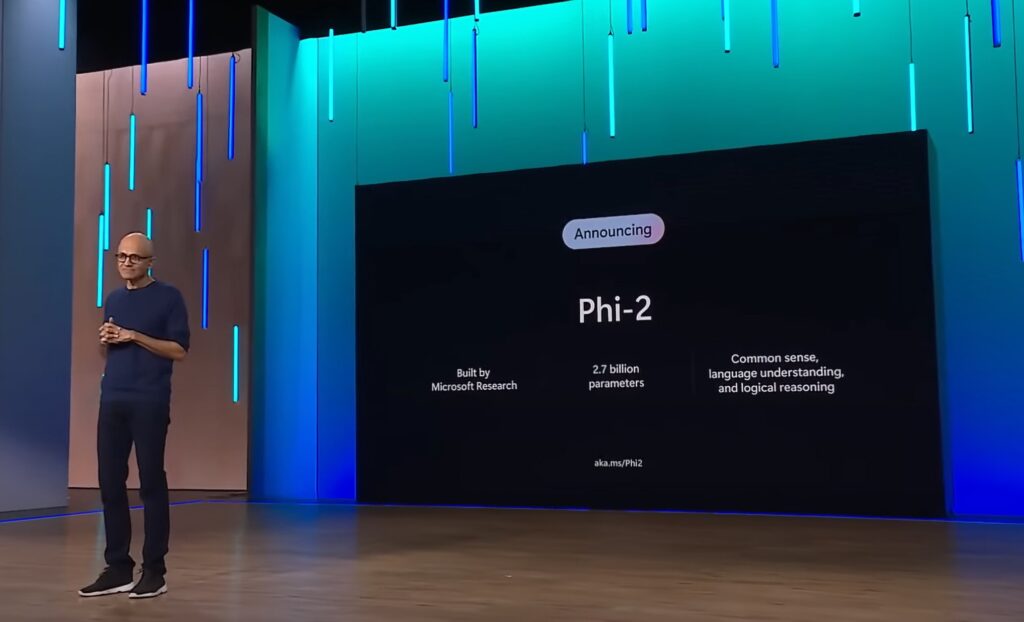

Il modello da 2,7 miliardi di parametri di Microsoft Phi-2 mette in mostra eccezionali capacità di ragionamento e comprensione del linguaggio, stabilendo un nuovo standard di prestazioni tra i modelli linguistici di base con meno di 13 miliardi di parametri.

Phi-2 si basa sul successo dei suoi predecessori, Phi-1 e Phi-1.5, abbinando o superando modelli fino a 25 volte più grandi, grazie alle innovazioni nel dimensionamento dei modelli e nella formazione dei dati.

Le dimensioni compatte di Phi-2 lo rendono un parco giochi ideale per i ricercatori, facilitando l’esplorazione dell’interpretabilità meccanicistica, i miglioramenti della sicurezza e la messa a punto della sperimentazione in vari compiti.

I risultati di Phi-2 sono sostenuti da due aspetti chiave:

- Qualità dei dati di addestramento: Microsoft sottolinea il ruolo fondamentale dell’addestramento della qualità dei dati nelle prestazioni del modello. Phi-2 sfrutta dati di “qualità da libro di testo”, concentrandosi su set di dati sintetici progettati per impartire ragionamenti basati sul buon senso e conoscenze generali. Il corpus formativo è arricchito con dati web accuratamente selezionati, filtrati in base al valore formativo e alla qualità dei contenuti.

- Tecniche di ridimensionamento innovative: Microsoft adotta tecniche innovative per ampliare Phi-2 rispetto al suo predecessore, Phi-1.5. Il trasferimento di conoscenze dal modello da 1,3 miliardi di parametri accelera la convergenza della formazione, portando a un chiaro aumento dei punteggi dei benchmark.

Valutazione delle prestazioni

Phi-2 è stato sottoposto a una valutazione rigorosa attraverso vari benchmark, tra cui Big Bench Hard, ragionamento basato sul buon senso, comprensione del linguaggio, matematica e programmazione.

Con solo 2,7 miliardi di parametri, Phi-2 supera i modelli più grandi – tra cui Mistral e Llama-2 – e eguaglia o supera il Gemini Nano 2 recentemente annunciato da Google:

Al di là dei benchmark, Phi-2 mostra le sue capacità in scenari del mondo reale. I test che coinvolgono suggerimenti comunemente utilizzati nella comunità di ricerca rivelano l’abilità di Phi-2 nel risolvere problemi di fisica e correggere gli errori degli studenti, dimostrando la sua versatilità oltre le valutazioni standard:

Phi-2 è un modello basato su Transformer con un obiettivo di previsione della parola successiva, addestrato su 1,4 trilioni di token da set di dati sintetici e web. Il processo di formazione, condotto su 96 GPU A100 per 14 giorni, si concentra sul mantenimento di un elevato livello di sicurezza e afferma di superare i modelli open source in termini di tossicità e bias.

Con l’annuncio di Phi-2, Microsoft continua ad ampliare i limiti di ciò che i modelli linguistici di base più piccoli possono ottenere.

(Credito immagine: Microsoft)

Guarda anche: AI & Big Data Expo: demistificare l’intelligenza artificiale e vedere oltre l’hype

Vuoi saperne di più sull’intelligenza artificiale e sui big data dai leader del settore? Guardare Fiera dell’intelligenza artificiale e dei big data che si svolge ad Amsterdam, in California, e a Londra. L’evento completo è co-localizzato con Settimana della trasformazione digitale.

Esplora altri prossimi eventi e webinar sulla tecnologia aziendale forniti da TechForge Qui.

Fonte: www.artificialintelligence-news.com