Quando i data center AI esauriscono lo spazio, affrontano un dilemma costoso: costruire strutture più grandi o trovare modi per far funzionare più posizioni insieme senza soluzione di continuità. L’ultima tecnologia Ethernet di Spectrum-XGS di Nvidia promette di risolvere questa sfida collegando i data center di intelligenza artificiale su vaste distanze in ciò che l’azienda chiama “Super-Factories AI su scala giga”.

Annunciato Davanti a Hot Chips 2025, questa innovazione in rete rappresenta la risposta dell’azienda a un problema crescente che sta costringendo l’industria dell’intelligenza artificiale a ripensare il modo in cui viene distribuito il potere computazionale.

Il problema: quando un edificio non è sufficiente

Man mano che i modelli di intelligenza artificiale diventano più sofisticati e impegnativi, richiedono un enorme potere computazionale che spesso supera ciò che ogni singola struttura può fornire. I data center tradizionali di intelligenza artificiale affrontano vincoli di capacità di potenza, spazio fisico e capacità di raffreddamento.

Quando le aziende hanno bisogno di più potere di elaborazione, in genere devono costruire strutture completamente nuove, ma il coordinamento del lavoro tra luoghi separati è stato problematico a causa delle limitazioni di networking. Il problema risiede nell’infrastruttura Ethernet standard, che soffre di alta latenza, fluttuazioni imprevedibili delle prestazioni (chiamate “jitter”) e velocità di trasferimento dei dati incoerenti quando si collega a posizioni distanti.

Questi problemi rendono difficile per i sistemi di intelligenza artificiale distribuire calcoli complessi in più su più siti.

SOLUZIONE DI NVIDIA: tecnologia scale-acra

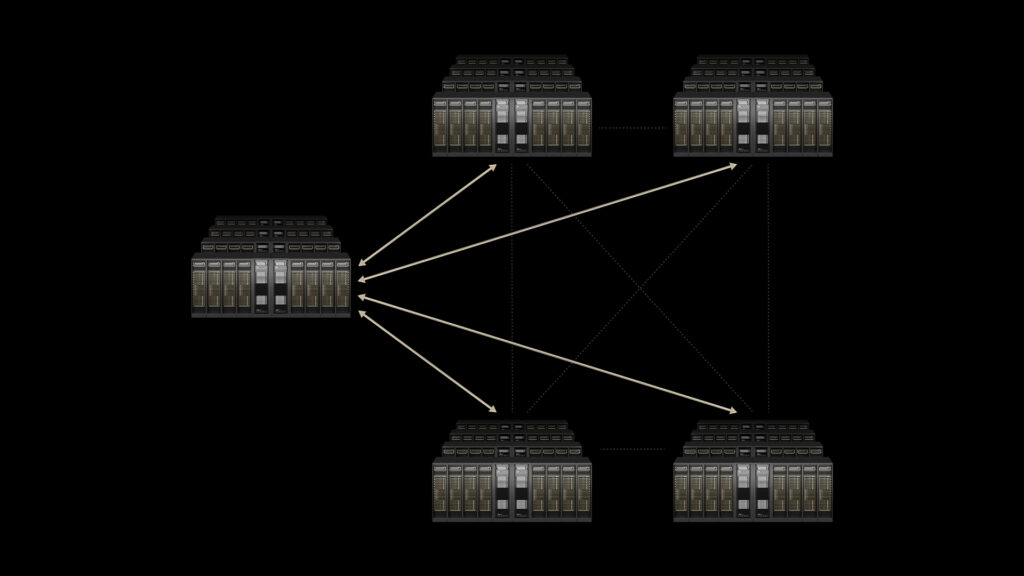

Spectrum-XGS Ethernet introduce ciò che NVIDIA termina la capacità di “scale-across”: un terzo approccio al calcolo dell’intelligenza artificiale che completa le strategie esistenti “scala-up” (rendendo i singoli processori più potenti) e “scala” (aggiungendo più processori nella stessa posizione).

La tecnologia si integra nella piattaforma Ethernet Spectrum-X esistente di Nvidia e include diverse innovazioni chiave:

- Algoritmi adattativi a distanza che regola automaticamente il comportamento della rete in base alla distanza fisica tra le strutture

- Controllo della congestione avanzata Ciò impedisce i colli di bottiglia di dati durante la trasmissione a lunga distanza

- Gestione della latenza di precisione per garantire tempi di risposta prevedibili

- Telemetria end-to-end Per il monitoraggio e l’ottimizzazione della rete in tempo reale

Secondo l’annuncio di Nvidia, questi miglioramenti possono “quasi raddoppiare le prestazioni della libreria di comunicazioni collettive NVIDIA”, che gestisce la comunicazione tra più unità di elaborazione grafica (GPU) e nodi di calcolo.

Implementazione del mondo reale

Coreweave, una società di infrastrutture cloud specializzata nel calcolo accelerato dalla GPU, prevede di essere tra i primi adottanti di Spectrum-XGS Ethernet.

“Con NVIDIA Spectrum-XGS, possiamo collegare i nostri data center a un singolo supercomputer unificato, dando ai nostri clienti l’accesso all’intelligenza artificiale su scala giga che accelererà le scoperte in ogni settore”, ha affermato Peter Salanki, cofondatore e direttore tecnologico di Coreweave.

Questa implementazione fungerà da caso pratico per se la tecnologia può mantenere le sue promesse in condizioni del mondo reale.

Contesto e implicazioni del settore

L’annuncio segue una serie di versioni focalizzate su networking da NVIDIA, tra cui la piattaforma Spectrum-X originale e gli switch di fotonica del silicio quantistico-X. Questo modello suggerisce che la società riconosce l’infrastruttura di networking come un collo di bottiglia critico nello sviluppo dell’IA.

“La rivoluzione industriale AI è qui e le fabbriche di intelligenza artificiale su scala gigante sono l’infrastruttura essenziale”, ha affermato Jensen Huang, fondatore e CEO di Nvidia, nel comunicato stampa. Mentre la caratterizzazione di Huang riflette la prospettiva di marketing di Nvidia, la sfida sottostante che descrive – la necessità di una maggiore capacità computazionale – è riconosciuta nel settore dell’intelligenza artificiale.

La tecnologia potrebbe potenzialmente avere un impatto su come sono pianificati e gestiti i data center di intelligenza artificiale. Invece di costruire enormi strutture singole che sforzano le reti elettriche locali e i mercati immobiliari, le aziende potrebbero distribuire la propria infrastruttura in più posizioni più piccole mantenendo i livelli di prestazione.

Considerazioni tecniche e limitazioni

Tuttavia, diversi fattori potrebbero influenzare l’efficacia pratica di Spectrum-XGS Ethernet. Le prestazioni della rete attraverso lunghe distanze rimane soggette a limiti fisici, compresa la velocità della luce e la qualità dell’infrastruttura Internet sottostante tra le posizioni. Il successo della tecnologia dipenderà in gran parte da quanto bene può funzionare all’interno di questi vincoli.

Inoltre, la complessità della gestione dei data center di AI distribuita si estende oltre il networking per includere la sincronizzazione dei dati, la tolleranza ai guasti e la conformità normativa tra diverse giurisdizioni: sfondi che i miglioramenti del networking da soli non possono risolvere.

Disponibilità e impatto del mercato

NVIDIA afferma che Ethernet Spectrum-XGS è “disponibile ora” come parte della piattaforma Spectrum-X, sebbene i prezzi e le scadenze specifiche di distribuzione non siano state divulgate. Il tasso di adozione della tecnologia dipenderà probabilmente dall’efficacia in termini di costi rispetto agli approcci alternativi, come la costruzione di strutture a sito singolo più grandi o l’utilizzo di soluzioni di networking esistenti.

La linea di fondo per i consumatori e le aziende è questo: se la tecnologia di Nvidia funziona come promesso, potremmo vedere servizi di intelligenza artificiale più veloci, applicazioni più potenti e costi potenzialmente più bassi man mano che le aziende guadagnano efficienza attraverso il calcolo distribuito. Tuttavia, se la tecnologia non riesce a fornire in condizioni del mondo reale, le aziende di intelligenza artificiale continueranno ad affrontare la costosa scelta tra la costruzione di singole strutture sempre più grandi o l’accettazione di compromessi delle prestazioni.

L’imminente implementazione di Coreweave fungerà da primo test importante se la connessione dei data center di intelligenza artificiale attraverso le distanze possa davvero funzionare su vasta scala. I risultati determineranno probabilmente se altre aziende seguiranno l’esempio o si atteneranno agli approcci tradizionali. Per ora, Nvidia ha presentato una visione ambiziosa, ma l’industria dell’IA è ancora in attesa di vedere se la realtà corrisponde alla promessa.

Vedi anche: New Nvidia Blackwell Chip for China May Outpace Model H20

Vuoi saperne di più sull’intelligenza artificiale e sui big da parte dei leader del settore? Guardare AI e Big Data Expo si svolge ad Amsterdam, in California e a Londra. L’evento completo è co-localizzato con altri eventi principali tra cui Conferenza di automazione intelligente, Blockx, Settimana di trasformazione digitaleE Cyber Security & Cloud Expo.

Esplora altri prossimi eventi tecnologici aziendali e webinar alimentati da TechForge Qui.

Fonte: www.artificialintelligence-news.com