Nvidia Ha lanciato Dynamo, un software di inferenza open source progettato per accelerare e scalare i modelli di ragionamento all'interno delle fabbriche di intelligenza artificiale.

Gestire e coordinare in modo efficiente le richieste di inferenza di intelligenza artificiale in una flotta di GPU è uno sforzo fondamentale per garantire che le fabbriche di intelligenza artificiale possano operare con efficacia in termini di costo ottimale e massimizzare la generazione di entrate token.

Man mano che il ragionamento AI diventa sempre più diffuso, ogni modello di intelligenza artificiale dovrebbe generare decine di migliaia di token con ogni prompt, che rappresenta essenzialmente il suo processo di “pensiero”. Migliorare le prestazioni dell'inferenza riducendo contemporaneamente il suo costo è quindi cruciale per accelerare la crescita e aumentare le opportunità di entrate per i fornitori di servizi.

Una nuova generazione di software di inferenza AI

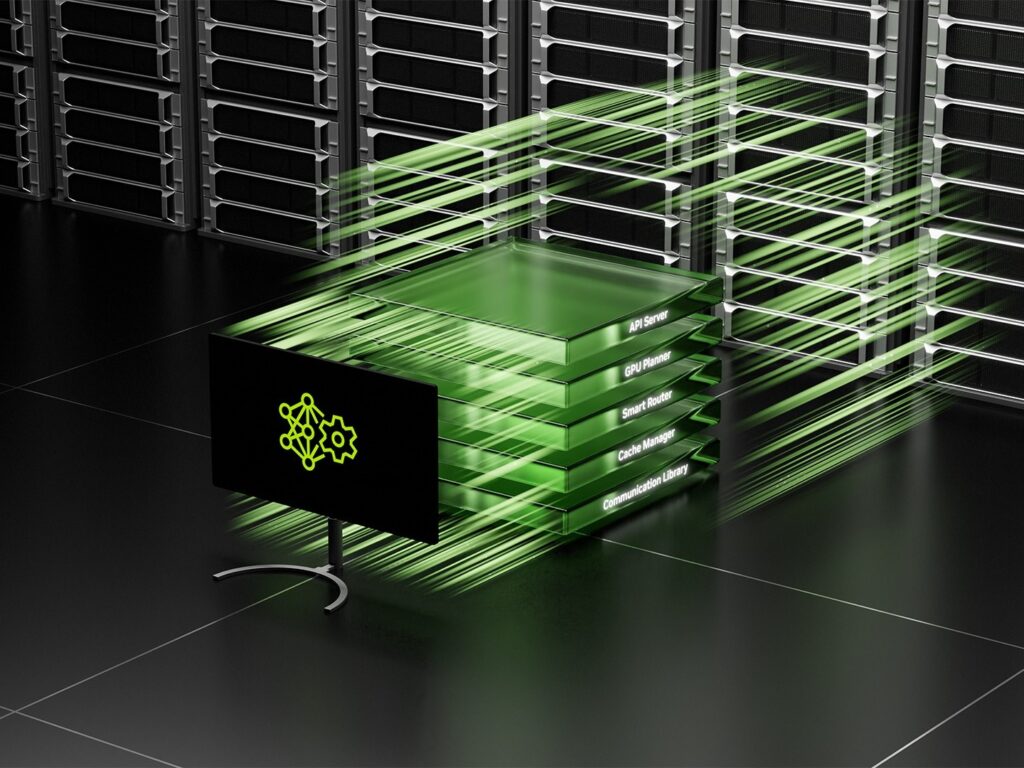

Nvidia Dynamo, che succede al server di inferenza Nvidia Triton, rappresenta una nuova generazione di AI Inferenza Il software è stato progettato in particolare per massimizzare la generazione di entrate token per le fabbriche di intelligenza artificiale che distribuiscono modelli di AI di ragionamento.

La dinamo orchestra e accelera la comunicazione di inferenza tra potenzialmente migliaia di GPU. Impiega un servizio disaggregato, una tecnica che separa le fasi di elaborazione e generazione dei modelli di grandi dimensioni (LLM) su GPU distinte. Questo approccio consente di ottimizzare ogni fase in modo indipendente, soddisfacendo le sue esigenze computazionali specifiche e garantendo il massimo utilizzo delle risorse GPU.

“Le industrie in tutto il mondo stanno allenando i modelli di intelligenza artificiale a pensare e imparare in diversi modi, rendendoli più sofisticati nel tempo”, ha dichiarato Jensen Huang, fondatore e CEO di Nvidia. “Per consentire un futuro del ragionamento personalizzato AI, Nvidia Dynamo aiuta a servire questi modelli su larga scala, guidando risparmi sui costi e efficienze tra le fabbriche di intelligenza artificiale.”

Usando lo stesso numero di GPU, Dynamo ha dimostrato la capacità di raddoppiare le prestazioni e le entrate delle fabbriche di intelligenza artificiale che servono modelli di lama sull'attuale piattaforma Hopper di Nvidia. Inoltre, quando si esegue il modello DeepSeek-R1 su un grande cluster di rack GB200 NVL72, le ottimizzazioni di inferenza intelligente di Nvidia Dynamo hanno dimostrato di aumentare il numero di token generati da oltre 30 volte per GPU.

Per ottenere questi miglioramenti nelle prestazioni di inferenza, Nvidia Dynamo incorpora diverse funzionalità chiave progettate per aumentare il throughput e ridurre i costi operativi.

La Dynamo può aggiungere, rimuovere e riallocare dinamicamente le GPU in tempo reale per adattarsi ai volumi e ai tipi fluttuanti di richieste. Il software può anche individuare le GPU specifiche all'interno di cluster di grandi dimensioni che sono più adatti per ridurre al minimo i calcoli di risposta e percorsi in modo efficiente le query. Dynamo può anche scaricare i dati di inferenza a dispositivi di memoria e archiviazione più convenienti mentre lo recupera rapidamente quando richiesto, riducendo così al minimo i costi di inferenza complessivi.

Nvidia Dynamo è stato rilasciato come progetto completamente open source, offrendo un'ampia compatibilità con framework popolari come Pytorch, Sglang, Nvidia Tensorrt-llm e VLLM. Questo approccio aperto supporta aziende, startup e ricercatori nello sviluppo e nell'ottimizzazione di nuovi metodi per servire i modelli di intelligenza artificiale attraverso infrastrutture di inferenza disaggregate.

Nvidia prevede che Dynamo acceleri l'adozione dell'inferenza di intelligenza artificiale attraverso una vasta gamma di organizzazioni, tra cui importanti fornitori di cloud e innovatori di intelligenza artificiale come AWS, Cohere, Coreweave, Dell, Fuochi d'artificio, Google Cloud, Lambda, Meta, Microsoft Azure, Nebio, NetApp, OCI, perplessità, AI e VAST.

Nvidia Dynamo: Inferenza di sovralimentazione e AI agente

Un'innovazione chiave di Nvidia Dynamo risiede nella sua capacità di mappare la consapevolezza che i sistemi di inferenza tengono in memoria dal servire richieste precedenti, note come cache KV, attraverso potenzialmente migliaia di GPU.

Il software quindi instrada in modo intelligente nuove richieste di inferenza alle GPU che possiedono la migliore corrispondenza delle conoscenze, evitando efficacemente le ricomputazioni costose e liberando altre GPU per gestire nuove richieste in arrivo. Questo meccanismo di routing intelligente migliora significativamente l'efficienza e riduce la latenza.

“Per gestire centinaia di milioni di richieste mensilmente, facciamo affidamento su GPU NVIDIA e software di inferenza per fornire le prestazioni, l'affidabilità e ridimensionare la nostra domanda di attività e utenti”, ha affermato Denis Yarats, CTO di Perplessità ai.

“Non vediamo l'ora di sfruttare la dinamo, con le sue capacità di servizio distribuite migliorate, per guidare ancora più efficienze che servono le inferenze e soddisfare le esigenze di calcolo dei nuovi modelli di ragionamento AI.”

Hai una piattaforma Cohere sta già pianificando di sfruttare Nvidia Dynamo per migliorare le funzionalità AI agenti all'interno della sua serie di modelli di comandi.

“Il ridimensionamento di modelli AI avanzati richiede una sofisticata pianificazione multi-GPU, coordinamento senza soluzione di continuità e librerie di comunicazione a bassa latenza che trasferiscono i contesti di ragionamento senza soluzione di continuità attraverso la memoria e la memoria”, ha spiegato Saurabh Baji, SVP dell'ingegneria presso Cohere.

“Ci aspettiamo che Nvidia Dynamo ci aiuterà a offrire un'esperienza utente principale ai nostri clienti aziendali.”

Supporto per il servizio disaggregato

La piattaforma di inferenza Nvidia Dynamo presenta anche un solido supporto per il servizio disaggregato. Questa tecnica avanzata assegna le diverse fasi computazionali degli LLM, comprese le fasi cruciali per comprendere la query utente e quindi generare la risposta più appropriata – a diverse GPU all'interno dell'infrastruttura.

Il servizio disaggregato è particolarmente adatto per i modelli di ragionamento, come la nuova famiglia di modelli di nemotron Nvidia Llama, che impiega tecniche di inferenza avanzate per una migliore comprensione contestuale e generazione di risposta. Consentendo a ogni fase di essere perfezionata e risorse in modo indipendente, il servizio disaggregato migliora il throughput complessivo e offre tempi di risposta più rapidi agli utenti.

Insieme aiUn giocatore di spicco nello spazio cloud di accelerazione AI, sta anche cercando di integrare il suo motore di inferenza proprietario insieme con Nvidia Dynamo. Questa integrazione mira a consentire il ridimensionamento senza soluzione di continuità dei carichi di lavoro di inferenza su più nodi GPU. Inoltre, consentirà all'intelligenza artificiale di affrontare dinamicamente i colli di bottiglia del traffico che possono sorgere in varie fasi della pipeline del modello.

“I modelli di ragionamento di ridimensionamento richiedono efficacemente nuove tecniche di inferenza avanzate, tra cui il servizio disaggregato e il routing consapevole del contesto”, ha dichiarato CE Zhang, CTO di Together Ai.

“L'apertura e la modularità di Nvidia Dynamo ci permetteranno di collegare perfettamente i suoi componenti al nostro motore per servire più richieste ottimizzando l'utilizzo delle risorse, maximando i nostri investimenti informatici accelerati. Siamo entusiasti di sfruttare le capacità di rottura della piattaforma per portare i modelli di ragionamento open source ai nostri utenti.”

Quattro innovazioni chiave di Nvidia Dynamo

NVIDIA ha messo in evidenza quattro innovazioni chiave all'interno di Dynamo che contribuiscono a ridurre i costi di servizio all'inferenza e a migliorare l'esperienza dell'utente:

- Pianificatore GPU: Un sofisticato motore di pianificazione che aggiunge e rimuove dinamicamente le GPU in base alla domanda di utenti fluttuanti. Ciò garantisce un'allocazione ottimale delle risorse, prevenendo sia il sovravisione che il sottovalutazione della capacità GPU.

- Router intelligente: Un router intelligente consapevole LLM che dirige le richieste di inferenza su grandi flotte di GPU. La sua funzione principale è quella di ridurre al minimo le costose ricompsioni della GPU di richieste ripetute o sovrapposte, liberando così preziose risorse GPU per gestire nuove richieste in arrivo in modo più efficiente.

- Biblioteca di comunicazione a bassa latenza: Una libreria ottimizzata per l'inferenza progettata per supportare la comunicazione GPU-to-GPU all'avanguardia. Estrae le complessità dello scambio di dati attraverso dispositivi eterogenei, accelerando significativamente le velocità di trasferimento dei dati.

- Memory Manager: Un motore intelligente che gestisce lo scarico e il ricarico dei dati di inferenza da e verso i dispositivi di memoria e archiviazione a basso costo. Questo processo è progettato per essere senza soluzione di continuità, garantendo alcun impatto negativo sull'esperienza dell'utente.

NVIDIA Dynamo sarà resa disponibile all'interno di microservizi NIM e sarà supportata in una versione futura della piattaforma software Enterprise AI dell'azienda.

Vedi anche: LG Exaone Deep è un appassionato di matematica, scienza e codifica

Vuoi saperne di più sull'intelligenza artificiale e sui big da parte dei leader del settore? Guardare AI e Big Data Expo si svolge ad Amsterdam, in California e a Londra. L'evento completo è co-localizzato con altri eventi principali tra cui Conferenza di automazione intelligente, Blockx, Settimana di trasformazione digitaleE Cyber Security & Cloud Expo.

Esplora altri prossimi eventi tecnologici aziendali e webinar alimentati da TechForge Qui.

Fonte: www.artificialintelligence-news.com