I sistemi di intelligenza artificiale agente fungono da lavoratori digitali autonomi per svolgere compiti complessi con una supervisione minima. Attualmente stanno crescendo con una rapida attrazione, al punto che uno stima ipotizza che entro il 2025, il 35% delle imprese implementerà agenti di intelligenza artificiale. Tuttavia, l’autonomia solleva preoccupazioni negli alti errori sottili in questi campi possono avere gravi conseguenze. Quindi, fa credere alle persone che il feedback umano nell’intelligenza artificiale agente garantisca sicurezza, responsabilità e fiducia.

L’approccio umano-nel-loop-convalida (HITL) è un design collaborativo in cui gli umani convalidano o influenzano le uscite di un’intelligenza artificiale. I checkpoint umani catturano errori prima e mantengono il sistema orientato verso i valori umani, il che a sua volta aiuta meglio la conformità e la fiducia nei confronti dell’intelligenza artificiale agente. Agisce come una rete di sicurezza per compiti complessi. In questo articolo, confronteremo i flussi di lavoro con e senza HITL per illustrare questi compromessi.

Human-in-the-Loop: concetto e benefici

Human-in-the-loop (HITL) è un modello di design in cui un flusso di lavoro AI include esplicitamente il giudizio umano nei punti chiave. L’intelligenza artificiale può generare un output provvisorio e mettere in pausa per consentire alla revisione umana, approvare o modificare questo output. In tale flusso di lavoro, la fase di revisione umana viene interposta tra il componente AI e l’output finale.

Benefici della convalida umana

- Riduzione e precisione dell’errore: L’uomo-in-loop esaminerà i potenziali errori negli output forniti dall’intelligenza artificiale e perfezionerà l’uscita.

- Fiducia e responsabilità: La convalida umana rende un sistema comprensibile e responsabile nelle sue decisioni.

- Conformità e sicurezza: L’interpretazione umana delle leggi ed etica garantisce che le azioni di intelligenza artificiale sono conformi ai regolamenti e ai problemi di sicurezza.

Quando non usare umano nel loop

- Attività di routine o ad alto volume: Gli umani sono un collo di bottiglia quando la velocità conta. Esternamente, in tali condizioni, l’intera generazione di automazione potrebbe essere più efficace.

- Sistemi critici: la risposta in tempo reale non può aspettare l’input umano. Ad esempio, filtraggio rapido dei contenuti o avvisi in diretta; Hitl potrebbe trattenere il sistema.

Cosa fa la differenza: confrontare due scenari

Senza umano nel loop

Nello scenario completamente automatizzato, il flusso di lavoro agente procede autonomamente. Non appena viene fornito l’input, l’agente genera contenuto e intraprende l’azione. Ad esempio, un assistente di intelligenza artificiale potrebbe, in alcuni casi, inviare la richiesta di tempo libero di un utente senza confermare. Ciò beneficia della massima velocità e della potenziale scalabilità. Naturalmente, il rovescio della medaglia è che nulla è controllato da un essere umano. C’è una differenza concettuale tra un errore commesso da un essere umano e un errore commesso da un Hai un agente. Un agente potrebbe interpretare erroneamente le istruzioni o eseguire un’azione indesiderata che potrebbe portare a risultati dannosi.

Con umano nel loop

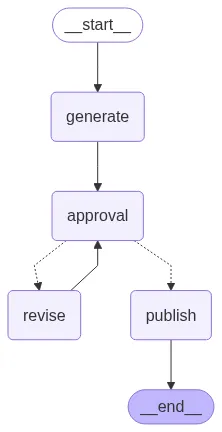

Nello scenario HITL (umano nel loop), stiamo inserendo un passo umano. Dopo aver generato una bozza approssimativa, l’agente si ferma e chiede a una persona di approvare o apportare modifiche al progetto. Se il progetto soddisfa l’approvazione, l’agente pubblica il contenuto. Se il progetto non è approvato, l’agente rivede il progetto in base al feedback e ai cerchi. Questo scenario offre un maggiore grado di accuratezza e fiducia, poiché gli umani possono catturare errori prima di finalizzare. Ad esempio, l’aggiunta di una fase di conferma sposta le azioni per ridurre le azioni “accidentali” e conferma che l’agente non ha frainteso l’input. L’aspetto negativo di questo, ovviamente, è che richiede più tempo e sforzo umano.

Esempio di implementazione in Langgraph

Di seguito è un esempio usando Langgraph E GPT-4o-Mini. Definiamo due flussi di lavoro: uno completamente automatizzato e uno con una fase di approvazione umana.

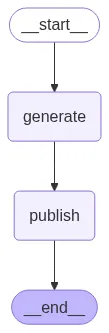

Scenario 1: senza umano nel loop

Quindi, nel primo scenario, creeremo un agente con un semplice flusso di lavoro. Ci vorrà l’input dell’utente, come quale argomento vogliamo creare il contenuto o su quale argomento vogliamo scrivere un articolo. Dopo aver ottenuto l’input dell’utente, l’agente utilizzerà GPT-4o-Mini per generare la risposta.

from langgraph.graph import StateGraph, END

from typing import TypedDict

from openai import OpenAI

from dotenv import load_dotenv

import os

load_dotenv()

OPENAI_API_KEY = os.getenv("OPENAI_API_KEY")

# --- OpenAI client ---

client = OpenAI(api_key=OPENAI_API_KEY) # Replace with your key

# --- State Definition ---

class ArticleState(TypedDict):

draft: str

# --- Nodes ---

def generate_article(state: ArticleState):

prompt = "Write a professional yet engaging 150-word article about Agentic AI."

response = client.chat.completions.create(

model="gpt-4o-mini",

messages=({"role": "user", "content": prompt})

)

state("draft") = response.choices(0).message.content

print(f"\n(Agent) Generated Article:\n{state('draft')}\n")

return state

def publish_article(state: ArticleState):

print(f"(System) Publishing Article:\n{state('draft')}\n")

return state

# --- Autonomous Workflow ---

def autonomous_workflow():

print("\n=== Autonomous Publishing ===")

builder = StateGraph(ArticleState)

builder.add_node("generate", generate_article)

builder.add_node("publish", publish_article)

builder.set_entry_point("generate")

builder.add_edge("generate", "publish")

builder.add_edge("publish", END)

graph = builder.compile()

# Save diagram

with open("autonomous_workflow.png", "wb") as f:

f.write(graph.get_graph().draw_mermaid_png())

graph.invoke({"draft": ""})

if __name__ == "__main__":

autonomous_workflow()Implementazione del codice: Questo codice imposta un flusso di lavoro con due nodi: generate_article E publish_articlecollegato in sequenza. Quando viene eseguito, ha l’agente stampare la sua bozza e quindi pubblicare immediatamente.

Diagramma del flusso di lavoro degli agenti

Risposta dell’agente

“””Agentic AI refers to advanced artificial intelligence systems that possess the ability to make autonomous decisions based on their environment and objectives. Unlike traditional AI, which relies heavily on predefined algorithms and human input, agentic AI can analyze complex data, learn from experiences, and adapt its behavior accordingly. This technology harnesses machine learning, natural language processing, and cognitive computing to perform tasks ranging from managing supply chains to personalizing user experiences.

The potential applications of agentic AI are vast, transforming industries such as healthcare, finance, and customer service. For instance, in healthcare, agentic AI can analyze patient data to provide tailored treatment recommendations, leading to improved outcomes. As businesses increasingly adopt these autonomous systems, ethical considerations surrounding transparency, accountability, and job displacement become paramount. Embracing agentic AI offers opportunities to enhance efficiency and innovation, but it also calls for careful contemplation of its societal impact. The future of AI is not just about automation; it's about intelligent collaboration.

”””

Scenario 2: con l’uomo in loop

In questo scenario, in primo luogo, creeremo 2 strumenti, revise_article_tool E publish_article_tool. IL revise_article_tool Revisionerà/modificherà il contenuto dell’articolo secondo il feedback dell’utente. Una volta che l’utente ha finito con il feedback e soddisfatto della risposta dell’agente, solo scrivendo pubblica il secondo strumento publish_article_toolVerrà eseguito e fornirà il contenuto dell’articolo finale.

from langgraph.graph import StateGraph, END

from typing import TypedDict, Literal

from openai import OpenAI

from dotenv import load_dotenv

import os

load_dotenv()

# --- OpenAI client ---

OPENAI_API_KEY = os.getenv("OPENAI_API_KEY")

client = OpenAI(api_key=OPENAI_API_KEY)

# --- State Definition ---

class ArticleState(TypedDict):

draft: str

approved: bool

feedback: str

selected_tool: str

# --- Tools ---

def revise_article_tool(state: ArticleState):

"""Tool to revise article based on feedback"""

prompt = f"Revise the following article based on this feedback: '{state('feedback')}'\n\nArticle:\n{state('draft')}"

response = client.chat.completions.create(

model="gpt-4o-mini",

messages=({"role": "user", "content": prompt})

)

revised_content = response.choices(0).message.content

print(f"\n(Tool: Revise) Revised Article:\n{revised_content}\n")

return revised_content

def publish_article_tool(state: ArticleState):

"""Tool to publish the article"""

print(f"(Tool: Publish) Publishing Article:\n{state('draft')}\n")

print("Article successfully published!")

return state('draft')

# --- Available Tools Registry ---

AVAILABLE_TOOLS = {

"revise": revise_article_tool,

"publish": publish_article_tool

}

# --- Nodes ---

def generate_article(state: ArticleState):

prompt = "Write a professional yet engaging 150-word article about Agentic AI."

response = client.chat.completions.create(

model="gpt-4o-mini",

messages=({"role": "user", "content": prompt})

)

state("draft") = response.choices(0).message.content

print(f"\n(Agent) Generated Article:\n{state('draft')}\n")

return state

def human_approval_and_tool_selection(state: ArticleState):

"""Human validates and selects which tool to use"""

print("Available actions:")

print("1. Publish the article (type 'publish')")

print("2. Revise the article (type 'revise')")

print("3. Reject and provide feedback (type 'feedback')")

decision = input("\nWhat would you like to do? ").strip().lower()

if decision == "publish":

state("approved") = True

state("selected_tool") = "publish"

print("Human validated: PUBLISH tool selected")

elif decision == "revise":

state("approved") = False

state("selected_tool") = "revise"

state("feedback") = input("Please provide feedback for revision: ").strip()

print(f"Human validated: REVISE tool selected with feedback")

elif decision == "feedback":

state("approved") = False

state("selected_tool") = "revise"

state("feedback") = input("Please provide feedback for revision: ").strip()

print(f"Human validated: REVISE tool selected with feedback")

else:

print("Invalid input. Defaulting to revision...")

state("approved") = False

state("selected_tool") = "revise"

state("feedback") = input("Please provide feedback for revision: ").strip()

return state

def execute_validated_tool(state: ArticleState):

"""Execute the human-validated tool"""

tool_name = state("selected_tool")

if tool_name in AVAILABLE_TOOLS:

print(f"\n Executing validated tool: {tool_name.upper()}")

tool_function = AVAILABLE_TOOLS(tool_name)

if tool_name == "revise":

# Update the draft with revised content

state("draft") = tool_function(state)

# Reset approval status for next iteration

state("approved") = False

state("selected_tool") = ""

elif tool_name == "publish":

# Execute publish tool

tool_function(state)

state("approved") = True

else:

print(f"Error: Tool '{tool_name}' not found in available tools")

return state

# --- Workflow Routing Logic ---

def route_after_tool_execution(state: ArticleState) -> Literal("approval", "end"):

"""Route based on whether the article was published or needs more approval"""

if state("selected_tool") == "publish":

return "end"

else:

return "approval"

# --- HITL Workflow ---

def hitl_workflow():

print("\n=== Human-in-the-Loop Publishing with Tool Validation ===")

builder = StateGraph(ArticleState)

# Add nodes

builder.add_node("generate", generate_article)

builder.add_node("approval", human_approval_and_tool_selection)

builder.add_node("execute_tool", execute_validated_tool)

# Set entry point

builder.set_entry_point("generate")

# Add edges

builder.add_edge("generate", "approval")

builder.add_edge("approval", "execute_tool")

# Add conditional edges after tool execution

builder.add_conditional_edges(

"execute_tool",

route_after_tool_execution,

{"approval": "approval", "end": END}

)

# Compile graph

graph = builder.compile()

# Save diagram

try:

with open("hitl_workflow_with_tools.png", "wb") as f:

f.write(graph.get_graph().draw_mermaid_png())

print("Workflow diagram saved as 'hitl_workflow_with_tools.png'")

except Exception as e:

print(f"Could not save diagram: {e}")

# Execute workflow

initial_state = {

"draft": "",

"approved": False,

"feedback": "",

"selected_tool": ""

}

graph.invoke(initial_state)

if __name__ == "__main__":

hitl_workflow()

"""Human Feedback:

Keep the discussion big and simple so that both tech and non-tech people can understand

"""Diagramma del flusso di lavoro degli agenti

Risposta dell’agente

“””Understanding Agentic AI: The Future of Intelligent Assistance Agentic AI represents a groundbreaking advancement in the field of artificial intelligence, characterized by its ability to operate independently while exhibiting goal-directed behavior. Unlike traditional AI systems that require constant human intervention, Agentic AI can analyze data, make decisions, and execute tasks autonomously. This revolutionary technology has the potential to transform various sectors, including healthcare, finance, and customer service, by streamlining processes and enhancing efficiency. One of the most notable features of Agentic AI is its adaptability; it learns from interactions and outcomes, continuously improving its performance. As more businesses adopt this technology, the opportunities for personalized user experiences and advanced predictive analytics expand significantly. However, the rise of Agentic AI also raises important discussions about ethics, accountability, and security. Striking the right balance between leveraging its capabilities and ensuring responsible usage will be crucial as we navigate this new era of intelligent automation. Embracing Agentic AI could fundamentally change our interactions with technology, ultimately enriching our daily lives and reshaping industries. Article successfully published!

”””

Osservazioni

Questa dimostrazione rifletteva i risultati HITL comuni. Con la revisione umana, l’articolo finale è stato più chiaro e accurato, coerente con i risultati che HITL migliora AI qualità di output. Il feedback umano ha rimosso gli errori e il fraseggio raffinato, confermando questi benefici. Nel frattempo, ogni ciclo di revisione ha aggiunto latenza e carico di lavoro. La corsa automatizzata è terminata quasi all’istante, mentre il flusso di lavoro HITL si è fermato due volte per il feedback. In pratica, questo compromesso è previsto: le macchine forniscono velocità, ma gli esseri umani forniscono precisione.

Conclusione

In conclusione, il feedback umano potrebbe migliorare significativamente la produzione di intelligenza artificiale agente. Agisce come una rete di sicurezza per errori e può mantenere output allineati con l’intento umano. In questo articolo, abbiamo sottolineato che anche una semplice fase di revisione ha migliorato l’affidabilità del testo. La decisione di utilizzare HITL dovrebbe in definitiva basarsi sul contesto: è necessario utilizzare la revisione umana in casi importanti e lasciarlo andare in situazioni di routine.

All’aumentare dell’uso dell’intelligenza artificiale agente, la sfida di quando utilizzare i processi automatizzati rispetto all’utilizzo della supervisione di tali processi diventa più importante. I regolamenti e le migliori pratiche richiedono sempre più un certo livello di revisione umana nelle implementazioni di intelligenza artificiale ad alto rischio. L’idea generale è quella di utilizzare l’automazione per la sua efficienza, ma che gli esseri umani prendano la proprietà delle decisioni chiave prese una volta al giorno! Checkpoint umani flessibili ci aiuteranno a utilizzare AI agente Possiamo in modo sicuro e responsabile.

Per saperne di più: Come entrare nell’intelligenza artificiale agente nel 2025?

Domande frequenti

A. HITL è un design in cui gli umani convalidano le uscite di intelligenza artificiale nei punti chiave. Garantisce accuratezza, sicurezza e allineamento con i valori umani aggiungendo i passaggi di revisione prima delle azioni finali.

A. HITL non è adatto per compiti di routine, ad alto volume o critico nel tempo in cui l’intervento umano rallenta le prestazioni, come avvisi in diretta o filtro dei contenuti in tempo reale.

A. Il feedback umano riduce gli errori, garantisce il rispetto delle leggi e dell’etica e crea fiducia e responsabilità nel processo decisionale dell’IA.

A. Senza HITL, l’IA agisce autonomamente con la velocità ma rischia errori incontrollati. Con HITL, gli umani rivedono le bozze, migliorando l’affidabilità ma aggiungendo tempo e sforzi.

A. La supervisione garantisce che le azioni di intelligenza artificiale rimangono sicure, etiche e allineate con l’intenzione umana, specialmente nelle applicazioni ad alto contenuto di poste in cui gli errori hanno gravi conseguenze.

Accedi per continuare a leggere e godere di contenuti curati da esperti.

Fonte: www.analyticsvidhya.com