introduzione

L'avvento dell'enorme modelli linguistici in cose del genere ChatGPT ha inaugurato una nuova epoca per quanto riguarda l'intelligenza artificiale conversazionale nel mondo in rapida evoluzione intelligenza artificiale. Il modello ChatGPT di Anthropic, che può impegnarsi in dialoghi simili a quelli umani, risolvere compiti difficili e fornire risposte ben ponderate e contestualmente rilevanti, ha affascinato persone in tutto il mondo. La decisione architettonica chiave per questo modello rivoluzionario è il suo approccio basato esclusivamente sul decodificatore.

Panoramica

- Capire perché ChatGPT utilizza solo un decodificatore come scelta architetturale principale.

- Identificare in che modo i vantaggi dell'architettura basata solo sul decodificatore includono un'autoattenzione efficiente, dipendenze a lungo raggio, formazione preliminare e messa a punto.

- Riconoscere che è possibile integrare la generazione aumentata con recupero e l'apprendimento multi-task nella progettazione flessibile e adattabile del solo decodificatore.

- L'utilizzo di un approccio basato esclusivamente sul decodificatore apre nuove possibilità per ampliare i limiti dell'intelligenza artificiale conversazionale. Ciò può portare a scoperte future nell’elaborazione del linguaggio naturale.

Perché ChatGPT utilizza solo l'architettura del decodificatore?

È abbastanza recente che i modelli linguistici basati su trasformatori sono sempre stati progettati dall'alto verso il basso come un codificatore-decodificatore. L'architettura del solo decodificatore di ChatGPT d'altro canto, viola le convenzioni e ha implicazioni sulla sua scalabilità, prestazioni ed efficienza.

Abbracciare il potere dell'auto-attenzione

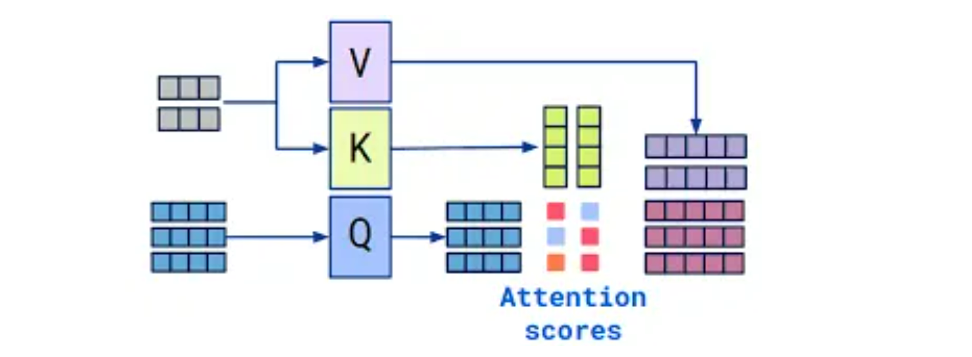

L'architettura di solo decodificatore di ChatGPT con l'autoattenzione come strumento consente al modello di bilanciare e mescolare contestualmente in modo consapevole varie sezioni della sequenza di input. Concentrandosi solo sul componente decodificatore, ChatGPT può elaborare e generare testo in modo efficace in un unico flusso. Questo approccio elimina la necessità di un codificatore separato.

Ci sono diversi vantaggi in questo metodo efficiente. Innanzitutto, riduce la complessità computazionale e i requisiti di memoria che lo rendono più efficiente pur essendo applicabile a diverse piattaforme e dispositivi. Inoltre, elimina qualsiasi necessità di distinguere chiaramente tra fasi di input e di output; portando così a un flusso di dialogo più semplice.

Catturare le dipendenze a lungo raggio

Uno dei vantaggi più importanti dell'architettura esclusivamente decodificatore è l'acquisizione accurata delle dipendenze a lungo raggio all'interno della sequenza di input. Le allusioni devono essere rilevate e su cui si deve reagire.

Quando gli utenti propongono nuovi argomenti, ulteriori domande o stabiliscono collegamenti a quanto discusso in precedenza, questo modello di dipendenza a lungo termine risulta molto utile. Grazie all'architettura basata solo sul decodificatore, ChatGPT può gestire facilmente queste complessità della conversazione e rispondere nel modo pertinente e appropriato mantenendo viva la conversazione.

Pre-formazione e messa a punto efficienti

La compatibilità con efficaci tecniche di pre-addestramento e messa a punto è un vantaggio significativo del design esclusivamente decodificatore. Attraverso approcci di apprendimento autocontrollato, ChatGPT è stato pre-addestrato su un ampio corpus di dati di testo che lo hanno aiutato ad acquisire un'ampia conoscenza in più domini e una profonda comprensione del linguaggio.

Quindi, utilizzando le competenze pre-addestrate su attività o set di dati specifici, è possibile incorporare nel modello le specificità e le esigenze del dominio. Poiché non richiede la riqualificazione dell'intero modello codificatore-decodificatore, questo processo è più efficiente ai fini della messa a punto, che accelera i tassi di convergenza e aumenta le prestazioni.

Architettura flessibile e adattabile

Di conseguenza, “l'architettura esclusivamente decoder di ChatGPT è intrinsecamente versatile e quindi facile da fondere bene con diversi componenti”. Ad esempio, insieme ad esso possono essere utilizzate strategie di generazione aumentata dal recupero

Sfidare i limiti dell'intelligenza artificiale conversazionale

Sebbene ChatGPT abbia beneficiato della progettazione basata esclusivamente sul decodificatore, è anche un punto di partenza per modelli di intelligenza artificiale conversazionale più sofisticati e avanzati. Mostrandone la fattibilità e i vantaggi, ChatGPT ha avviato future ricerche su altre architetture che possano estendere le frontiere del campo dell’intelligenza artificiale conversazionale.

L’architettura basata solo sul decodificatore potrebbe portare a nuovi paradigmi e metodi nell’elaborazione del linguaggio naturale mentre la disciplina si evolve verso lo sviluppo di sistemi di intelligenza artificiale più simili a quelli umani, consapevoli del contesto e adattabili, in grado di impegnarsi in discussioni significative senza soluzione di continuità in più domini e casi d’uso.

Conclusione

L'architettura di ChatGPT è un puro decodificatore che sconvolge i modelli linguistici tradizionali. Con l'aiuto dell'autoattenzione e di un'architettura semplificata, ChatGPT può analizzare in modo efficace le risposte di tipo umano e generarle incorporando dipendenza a lungo raggio e sfumature contestuali. Inoltre, questa decisione architettonica innovativa, che ha dato a chatGPT le sue incredibili capacità di conversazione, apre la strada a future innovazioni nell'intelligenza artificiale conversazionale. Dobbiamo anticipare importanti progressi nell’interazione uomo-macchina e nell’elaborazione del linguaggio naturale poiché questo approccio continua a essere studiato e migliorato da ricercatori e sviluppatori.

Punti chiave

- A differenza dei modelli linguistici basati su trasformatore codificatore-decodificatore, ChatGPT utilizza un approccio esclusivamente decodificatore.

- Questa architettura impiega tecniche di auto-attenzione per ridurre la complessità informatica e i requisiti di memoria, facilitando al tempo stesso la generazione e l'elaborazione fluida del testo.

- In questo modo, questa architettura preserva la coerenza contestuale all'interno delle sequenze di input e cattura le dipendenze a lungo raggio. Ciò porta a risposte pertinenti durante le conversazioni in ambienti chatbot come quelli forniti da ChatGPT.

- L'approccio basato esclusivamente sul decodificatore porta a una convergenza più rapida con prestazioni migliori grazie alle fasi di pre-addestramento e messa a punto

Domande frequenti

R. Nel metodo codificatore-decodificatore, la sequenza di input è codificata da un codificatore e il decodificatore utilizza questa rappresentazione codificata per generare una sequenza di output. Al contrario, un progetto esclusivamente decodificatore si concentra principalmente sul decodificatore, utilizzando meccanismi di auto-attenzione per gestire le sequenze di input e output.

A. L'autoattenzione consente al modello di elaborare e generare testo in modo efficiente soppesando e unendo contestualmente diversi input di una sequenza. Questo meccanismo cattura le dipendenze a lungo raggio. Per migliorare l’efficienza, è possibile applicare tecniche come meccanismi di autoattenzione ottimizzati, architetture di trasformatori efficienti e potatura dei modelli.

R. Il pre-addestramento e la messa a punto sono più efficienti con un'architettura basata solo sul decodificatore perché richiede meno parametri e calcoli rispetto a un modello codificatore-decodificatore. Ciò si traduce in una convergenza più rapida e prestazioni migliorate, eliminando la necessità di riqualificare l'intero modello codificatore-decodificatore.

R. Sì, le architetture basate solo sul decodificatore sono flessibili e possono integrare metodi aggiuntivi come la generazione aumentata con recupero e l'apprendimento multi-task. Questi miglioramenti possono migliorare le capacità e le prestazioni del modello.

R. L'utilizzo di un progetto basato solo sul decodificatore nell'intelligenza artificiale conversazionale ha dimostrato la fattibilità e i vantaggi di questo approccio. Ha aperto la strada a ulteriori ricerche su architetture alternative che potrebbero superare gli attuali confini della conversazione. Ciò porta a sistemi di intelligenza artificiale conversazionale più avanzati ed efficienti.

Fonte: www.analyticsvidhya.com