Una revisione da parte di un profano del dibattito scientifico su cosa riserva il futuro all’attuale paradigma dell’intelligenza artificiale

Poco più di un anno fa, OpenAI ha rilasciato ChatGPT, conquistando il mondo. ChatGPT racchiude un modo completamente nuovo di interagire con i computer: in un linguaggio meno rigido e più naturale di quello a cui siamo abituati. Soprattutto, sembrava che ChatGPT potesse fare quasi tutto: battere la maggior parte degli esseri umani all’esame SAT E accedere all’esame di abilitazione. Nel giro di pochi mesi si scoprì che era così sa giocare bene a scacchiE ho quasi superato l’esame di radiologiae alcuni lo hanno affermato teoria della mente sviluppata.

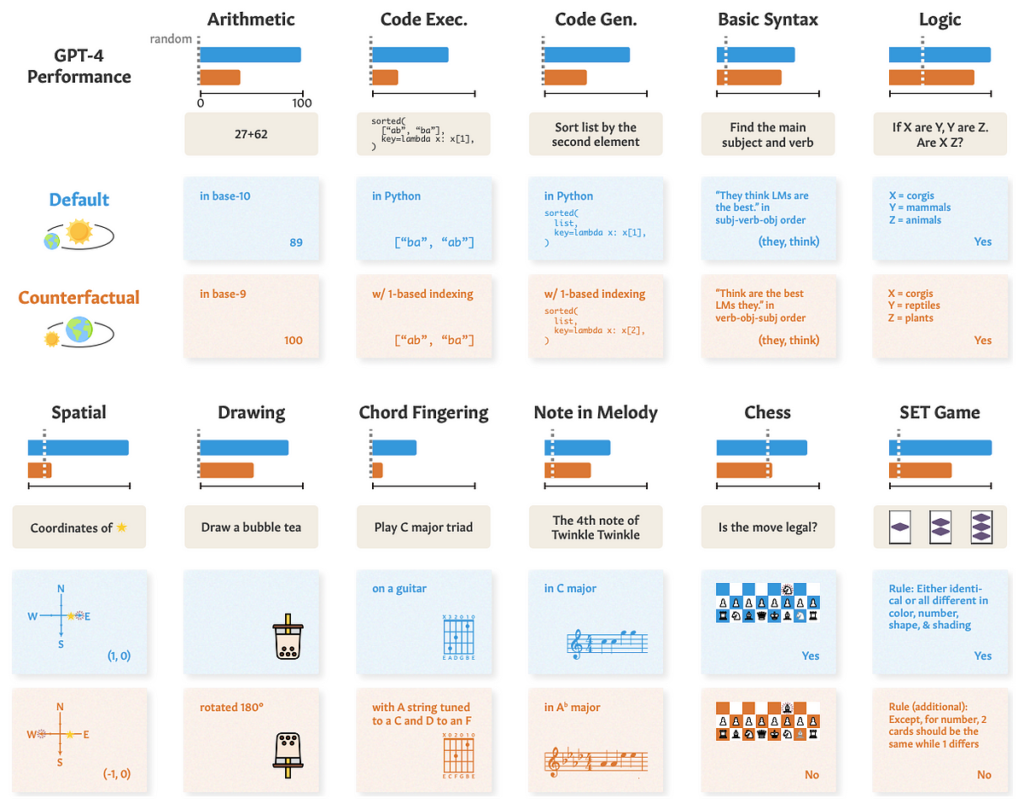

Queste impressionanti capacità hanno spinto molti a dichiarare che l’AGI (intelligenza artificiale generale – con capacità cognitive pari o superiori a quelle umane) è dietro l’angolo. Altri ancora sono rimasti scettici nei confronti della tecnologia emergente, sottolineando che la semplice memorizzazione e la corrispondenza dei modelli non dovrebbero essere confusi con la vera intelligenza.

Ma come possiamo veramente notare la differenza? All’inizio del 2023, quando furono fatte queste affermazioni, c’erano relativamente pochi studi scientifici che indagavano la questione dell’intelligenza negli LLM. Tuttavia, nel 2023 si sono verificati diversi esperimenti scientifici molto intelligenti volti a distinguere tra la memorizzazione di un corpus e l’applicazione dell’intelligenza genuina.

Il seguente articolo esplorerà alcuni degli studi più rivelatori nel campo, presentando il caso scientifico per gli scettici. È pensato per essere accessibile a tutti, senza che sia richiesto alcun background. Alla fine, dovresti avere una comprensione abbastanza solida del caso degli scettici.

Ma prima un’introduzione agli LLM

In questa sezione spiegherò alcuni concetti di base necessari per comprendere gli LLM, la tecnologia alla base di GPT, senza entrare nei dettagli tecnici. Se hai familiarità con l’apprendimento supervisionato e il funzionamento dei LLM, puoi saltare questa parte.

Gli LLM sono un classico esempio di paradigma di machine learning, chiamato “apprendimento supervisionato”. Per utilizzare l’apprendimento supervisionato, dobbiamo avere un set di dati composto da input e output desiderati, questi vengono alimentati a un algoritmo (ci sono molti modelli possibili tra cui scegliere) che cerca di trovare le relazioni tra questi input e output. Ad esempio, potrei avere dati immobiliari: un foglio Excel con il numero di stanze, le dimensioni e l’ubicazione delle case (input), nonché il prezzo a cui sono state vendute (output). Questi dati vengono forniti a un algoritmo che estrae le relazioni tra gli input e gli output: scoprirà come l’aumento delle dimensioni della casa o la posizione influenzano il prezzo. Fornire i dati all’algoritmo per “imparare” la relazione input-output si chiama “training”.

Al termine della formazione, possiamo utilizzare il modello per fare previsioni sulle case per le quali non disponiamo del prezzo. Il modello utilizzerà le correlazioni apprese dalla fase di formazione per produrre i prezzi stimati. Il livello di accuratezza delle stime dipende da molti fattori, in particolare dai dati utilizzati nella formazione.

Questo paradigma di “apprendimento supervisionato” è estremamente flessibile per quasi tutti gli scenari in cui disponiamo di molti dati. I modelli possono imparare a:

- Riconoscere gli oggetti in un’immagine (dato un insieme di immagini e l’etichetta corretta per ciascuna, ad esempio “gatto”, “cane” ecc.)

- Classificare un’e-mail come spam (dato un set di dati di e-mail già contrassegnate come spam/non spam)

- Predire la parola successiva in una frase.

Gli LLM rientrano nell’ultima categoria: vengono alimentati con enormi quantità di testo (per lo più trovato su Internet), in cui ogni porzione di testo è suddivisa nelle prime N parole come input e nella parola N+1 come output desiderato. Una volta terminato il loro addestramento, potremo usarli per completare automaticamente le frasi.

Oltre a molti testi provenienti da Internet, OpenAI ha utilizzato nella sua formazione testi conversazionali ben realizzati. Addestrare il modello con questi testi di domanda-risposta è fondamentale per farlo rispondere come assistente.

Il modo esatto in cui funziona la previsione dipende dall’algoritmo specifico utilizzato. Gli LLM utilizzano un’architettura detta “trasformatore”, i cui dettagli non sono importanti per noi. Ciò che è importante è che i LLM hanno due “fasi”: formazione e previsione; vengono forniti loro dei testi da cui estraggono le correlazioni tra le parole per prevedere la parola successiva oppure viene fornito un testo da completare. Tieni presente che l’intero paradigma di apprendimento supervisionato presuppone che i dati forniti durante la formazione siano simili ai dati utilizzati per la previsione. Se lo si utilizza per prevedere dati provenienti da un’origine completamente nuova (ad esempio, dati immobiliari di un altro paese), l’accuratezza delle previsioni ne risentirà.

Ora torniamo all’intelligenza

Quindi ChatGPT, addestrandosi al completamento automatico delle frasi, ha sviluppato l’intelligenza? Per rispondere a questa domanda dobbiamo definire “intelligenza”. Ecco un modo per definirlo:

L’hai preso? In caso contrario, ChatGPT può spiegare:

Sembra certamente che ChatGPT abbia sviluppato intelligenza, poiché è abbastanza flessibile da adattarsi alla nuova “ortografia”. Oppure è successo? Tu, il lettore, potresti essere stato in grado di adattarti all’ortografia che non hai mai visto prima, ma ChatGPT è stato addestrato su enormi quantità di dati provenienti da Internet: e proprio questo esempio può essere trovato su molti siti web. Quando GPT ha spiegato questa frase, ha semplicemente utilizzato parole simili a quelle trovate nella sua formazione, e ciò non dimostra flessibilità. Avrebbe potuto esibire “IN73LL1G3NC3“, se quella frase non fosse apparsa nei suoi dati di addestramento?

Questo è il punto cruciale del dibattito LLM-AGI: il GPT (e i LLM in generale) ha sviluppato un’intelligenza vera e flessibile o sta solo ripetendo variazioni sui testi che ha visto prima?

Come possiamo separare i due? Rivolgiamoci alla scienza per esplorare le capacità e i limiti degli LLM.

Supponiamo che ti dica che Olaf Scholz è stato il nono Cancelliere della Germania, puoi dirmi chi era il nono Cancelliere della Germania? Potrebbe sembrarti banale, ma è tutt’altro che ovvio per i LLM.

In questo brillantemente semplice cartai ricercatori hanno interrogato ChatGPT per i nomi dei genitori di 1000 celebrità (ad esempio: “Chi è la madre di Tom Cruise?”) a cui ChatGPT è stato in grado di rispondere correttamente il 79% delle volte (“Mary Lee Pfeiffer” in questo caso). I ricercatori hanno poi utilizzato le domande a cui GPT ha risposto correttamente, per formulare la domanda opposta: “Chi è il figlio di Mary Lee Pfeiffer?”. Sebbene sia necessaria la stessa conoscenza per rispondere ad entrambi, GPT è riuscito a rispondere solo al 33% di queste domande.

Perché? Ricordiamo che GPT non ha “memoria” o “database”: tutto ciò che può fare è prevedere una parola dato un contesto. Poiché Mary Lee Pfeiffer è menzionata negli articoli come la madre di Tom Cruise più spesso di quanto lui sia menzionato come suo figlio, GPT può ricordare una direzione e non l’altra.

Fonte: towardsdatascience.com