1. Non determinismo negli LLM

I migliori casi d’uso LLM sono quelli in cui si utilizza LLM come strumento anziché esporlo direttamente. COME Riccardo Seroter dice, di quanti chatbot hai bisogno?

Tuttavia, questo caso d’uso di sostituzione delle pagine di prodotto statiche con riepiloghi di prodotto personalizzati è come molti altri casi d’uso LLM in quanto affronta rischi unici dovuti al non determinismo. Immagina che un cliente ti faccia causa tra un anno, dicendo che ha acquistato il prodotto perché il riepilogo del tuo prodotto affermava (erroneamente) che il prodotto era ignifugo e che la sua casa era andata a fuoco. L’unico modo per proteggersi sarebbe avere un registro di ogni riepilogo generato e i costi di archiviazione aumenterebbero rapidamente…

Un modo per evitare questo problema (e quello che suggerisco) è generare una serie di modelli utilizzando LLM e utilizzare un modello ML per scegliere quale modello servire. Ciò ha anche il vantaggio di consentire la supervisione umana del testo generato, quindi non sei alla mercé di un’ingegneria tempestiva. (Questo è, ovviamente, solo un modo per utilizzare i LLM per creare in modo efficiente diversi siti Web per diversi segmenti di clientela: più le cose cambiano, più rimano con le idee esistenti).

Molti casi d’uso degli LLM sono così: dovrai ridurre il comportamento non deterministico e il rischio associato attraverso un’attenta architettura.

2. Problemi di copyright con i LLM

Il New York Times ha citato in giudizio OpenAI e Microsoft per l’utilizzo degli articoli del Times. Ciò va ben oltre le precedenti cause legali, sostenendo che:

1. OpenAI ha utilizzato milioni di articoli e li ha ponderati più in alto, riconoscendo così implicitamente l’importanza del contenuto del Times.

2. Le recensioni di Wirecutter sono riprodotte alla lettera, ma con i link di affiliazione eliminati. Questo crea un prodotto competitivo.

3. GenAI imita lo stile espressivo del Times portando alla diluizione del marchio.

4. Il valore della tecnologia è di trilioni di dollari per Microsoft e miliardi di dollari per OpenAI in base all’aumento delle loro capitalizzazioni di mercato.

5. Produrre riassunti accurati non è trasformativo dato che il lavoro originale è stato creato con una spesa considerevole.

La causa riguarda anche la struttura aziendale di Open AI, la natura delle strette collaborazioni con Open AI su cui Microsoft ha fatto affidamento per costruire la piattaforma informatica di Azure e la selezione dei set di dati.

https://www.nytimes.com/2023/12/27/business/media/new-york-times-open-ai-microsoft-lawsuit.html

L’intero fascicolo è di 69 pagine, molto leggibile e contiene molti esempi. Consiglio vivamente di leggere il PDF completo collegato all’articolo.

Non sono un avvocato, quindi non entrerò nel merito della causa. Ma se il NYTimes vince, mi aspetterei che:

1. Il costo delle API LLM aumenterà poiché i fornitori LLM dovranno pagare le loro fonti. Questa causa colpisce la formazione e la qualità del servizio di base non solo quando gli articoli del NYTimes vengono riprodotti durante l’inferenza. Quindi i costi aumenteranno a tutti i livelli.

2. I LLM open source non saranno in grado di utilizzare Common Crawl (dove NYTimes è la quarta fonte più comune). La qualità dei loro set di dati peggiorerà e sarà più difficile per loro corrispondere alle offerte commerciali.

3. Ciò protegge i modelli di business associati alla produzione di contenuti unici e di alta qualità.

4. Il SEO privilegierà ulteriormente il fatto di essere la prima o la seconda autorità su un argomento. Sarà difficile per gli altri ottenere traffico organico. Aspettatevi che i costi di acquisizione dei clienti tramite gli annunci aumentino.

3. Non utilizzare direttamente un LLM; Utilizza un framework per la creazione di bot

Un incidente in una concessionaria Chevy

dimostra perché non dovresti mai implementare il chatbot sul tuo sito web direttamente su un’API LLM o con un GPT personalizzato: farai fatica a domare la bestia. Ci saranno anche tutti i tipi di attacchi avversari da cui spenderai molti soldi da parte dei programmatori per proteggerti.

Cosa dovresti fare? Utilizza un framework per la creazione di bot di livello superiore come Google Dialogflow o Amazon Lex. Entrambi hanno un modello linguistico integrato e risponderanno solo a un numero limitato di intenti. Risparmiandoti così una lezione costosa.

4. Gemini dimostra la fiducia di Google nel proprio team di ricerca

Ciò che a molte persone sembra mancare è la gelida fiducia che la leadership di Google aveva nel proprio team di ricerca.

Mettiti nei panni dei dirigenti di Google un anno fa. Hai perso il vantaggio di chi ha fatto la prima mossa a favore delle startup che sono entrate sul mercato con una tecnologia che consideravi troppo rischiosa. E tu devi rispondere.

Scommetteresti sulla capacità del tuo team di ricerca di costruire un *singolo* modello che supererebbe OpenAI, Midjourney, ecc.? Oppure distribuiresti le tue scommesse e costruiresti più modelli? (Gemini è un modello unico che ha battuto il miglior modello di testo sul testo, il miglior modello di immagine sulle immagini, il miglior modello video su video e il miglior modello vocale su parlato.)

Ora, immagina di avere due laboratori di livello mondiale: Google Brain e Deep Mind. Li combineresti e diresti a 1000 persone di lavorare su un unico prodotto? Oppure copriresti la scommessa facendoli lavorare su due approcci diversi nella speranza che uno abbia successo? (Google ha unito i due team chiamandolo Google Deep Mind sotto la guida di Demis, il capo di Deep Mind, e Jeff Dean, il capo di Brain, è diventato il capo scienziato.)

Disponi di un chip di apprendimento automatico personalizzato sviluppato internamente (il TPU). Nel frattempo, tutti gli altri stanno costruendo modelli su chip per uso generale (GPU). Raddoppi il tuo chip interno o proteggi le tue scommesse? (Gemini è stato addestrato e viene servito dalle TPU.)

In ciascuna di queste decisioni, Google ha scelto di andare all-in.

5. Chi sta effettivamente investendo nella Gen AI?

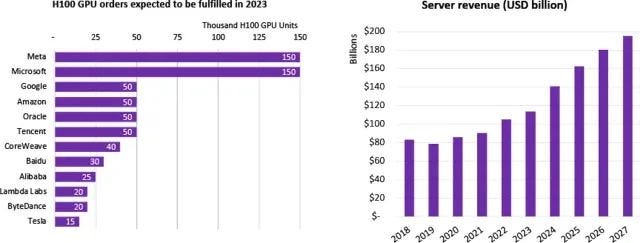

Stime Omdia delle spedizioni H100:

Un buon modo per superare l’hype del marketing nel settore tecnologico è guardare chi sta effettivamente investendo in nuove capacità. Pertanto, le stime di Omdia sulle spedizioni H100 sono un buon indicatore di chi sta vincendo nella Gen AI.

Meta e Microsoft hanno acquistato 150.000 H100 ciascuno nel 2023 mentre Google, Amazon e Oracle hanno acquistato 50.000 unità ciascuno. (L’utilizzo interno di Google e Anthropic sono su TPU, quindi la loro spesa per l’intelligenza artificiale di generazione è superiore a quanto indicherebbero i 50.000.)

Sorprese?

1. Apple brilla per la sua assenza.

2. Sono molto curioso di sapere cosa sta facendo Meta. Cerchi un grande annuncio lì?

3. Oracle è testa a testa con AWS.

I miglioramenti della velocità del chip al giorno d’oggi non derivano dall’inserimento di più transistor su un chip (limitazione fisica). Derivano invece dall’ottimizzazione per tipi di modelli ML specifici.

Pertanto, H100 ottiene velocità di inferenza 30 volte superiori rispetto a A100 (la generazione precedente) sui carichi di lavoro del trasformatore (1) passando dinamicamente tra la rappresentazione a 8 bit e 16 bit per diversi livelli di un’architettura del trasformatore (2) aumentando la velocità di rete tra le GPU consentendo il parallelismo del modello (necessario per LLM), non solo il parallelismo dei dati (sufficiente per i carichi di lavoro di immagini). Non spenderesti $ 30.000 per chip a meno che i tuoi modelli ML non avessero questa specifica serie di esigenze specifiche.

Allo stesso modo, l’A100 ha ottenuto miglioramenti rispetto al V100 utilizzando un tipo a virgola mobile con precisione a 10 bit appositamente progettato che bilancia velocità e precisione sui carichi di lavoro di incorporamento di immagini e testo.

Quindi, sapere quali chip sta acquistando un’azienda ti consente di indovinare in quali carichi di lavoro di intelligenza artificiale sta investendo un’azienda (in prima approssimazione: l’H100 ha anche istruzioni hardware per alcuni problemi di genomica e ottimizzazione, quindi non è chiaro al 100%).

6. Alla gente piacciono i contenuti generati dall’intelligenza artificiale, finché non dici loro che è generato dall’intelligenza artificiale

Affascinante studio del MIT:

1. Se hai contenuti, alcuni generati dall’intelligenza artificiale e altri generati dall’uomo, le persone preferiscono quelli generati dall’intelligenza artificiale! Se pensi che i contenuti generati dall’intelligenza artificiale siano insipidi e mediocri, tu (e io) siamo in minoranza. Questo è simile al modo in cui la maggior parte delle persone preferisce effettivamente il cibo nelle catene di ristoranti: funziona insipido per più persone.

2. Se etichetti il contenuto come generato dall’intelligenza artificiale o generato dall’uomo, le persone preferiscono quello umano. Questo perché ora assegnano un punteggio più alto ai contenuti generati dall’uomo mantenendo gli stessi punteggi per l’intelligenza artificiale. C’è una sorta di segnalazione di virtù o di favoritismo di specie in corso.

Sulla base di ciò, quando gli artisti chiedono che l’arte generata dall’intelligenza artificiale venga etichettata o gli scrittori chiedono che il testo generato dall’intelligenza artificiale sia chiaramente contrassegnato, si tratta solo di una supplica speciale? Artisti e scrittori stanno facendo pressioni per ottenere un trattamento preferenziale?

Non LLM, ma il mio primo amore per l’intelligenza artificiale, i metodi di previsione del tempo, stanno avendo il loro momento

Oltre a GraphCast, esistono altri modelli di previsione meteorologica globali basati sull’apprendimento automatico che vengono eseguiti in tempo reale. Imme Ebert-Uphoff Il gruppo di ricerca di li mostra fianco a fianco (con le previsioni meteorologiche numeriche ECMWF e GFS come controllo) qui:

La verifica affiancata in un contesto come lo Storm Prediction Center Spring Experiment è essenziale prima che queste previsioni vengano utilizzate nel processo decisionale. Non sono sicuro di quale sarebbe l’equivalente per le previsioni globali, ma tale valutazione è necessaria. Sono così felice di vedere che il CIRA sta fornendo questa capacità.

7. Gli LLM sono in fase di stallo

Non sono rimasto molto impressionato dopo il Dev day di OpenAI.

8. Economia del software Gen AI

Ci sono due caratteristiche uniche associate al software Gen AI: (1) il costo computazionale è elevato perché necessita di GPU per l’addestramento/inferenza (2) il fossato dei dati è basso perché modelli più piccoli ottimizzati su dati relativamente piccoli possono eguagliare le prestazioni di modelli più grandi . Detto questo, la consueta aspettativa secondo cui il software ha un costo marginale basso e fornisce enormi economie di scala potrebbe non essere più applicabile.

9. Aiuto! Il mio libro fa parte del dataset formativo dei LLM

Molti dei LLM sul mercato includono un set di dati chiamato Books3 nel loro corpus di formazione. Il problema è che questo corpus include copie piratate di libri. Ho utilizzato uno strumento creato dall’autore dell’articolo su Atlantic

per verificare se qualcuno dei miei libri è nel corpus. E in effetti, sembra che uno dei libri lo sia.

Era un post divertente, ma coglie il vero dilemma poiché nessuno scrive libri tecnici (l’intero pubblico è composto da poche migliaia di copie) per fare soldi.

10. Un modo per rilevare fatti allucinati nel testo generato da LLM

Poiché i LLM sono macchine a completamento automatico, sceglieranno la frase successiva più probabile in base al testo precedente. Ma cosa succede se non ci sono abbastanza dati su un argomento? Quindi, la frase successiva “più probabile” è una media di molti articoli diversi nell’area generale, e quindi è probabile che la frase risultante sia sostanzialmente sbagliata. Diciamo che il LLM ha “allucinato” un fatto.

Questo aggiornamento di Bard sfrutta la relazione tra la frequenza nel set di dati di addestramento e l’allucinazione per contrassegnare le aree del testo generato che potrebbero essere fattivamente errate.

Seguimi su LinkedIn: https://www.linkedin.com/in/valliappalakshmanan/

Fonte: towardsdatascience.com