Non c’è niente di sbagliato in questi sistemi purché soddisfino i requisiti aziendali. Tutti i sistemi che soddisfano le nostre esigenze aziendali sono buoni sistemi. Se ci sono semplici è ancora meglio.

In questa fase, esistono diversi modi per eseguire l’analisi dei dati:

- Invia semplicemente le query al nodo di replica del database OLTP. (Non consigliato).

- Abilitare CDC (Change Data Capture) del database OLTP e inserire tali dati nel database OLAP. Vieni all’opzione del servizio di acquisizione dei log CDC, puoi scegliere in base al database OLAP che hai selezionato. Per esempio, Streaming dati Flink con connettori CDC è un modo per gestire la situazione. Molti servizi aziendali vengono forniti con la propria soluzione suggerita, ad es Pipa da neve per Fiocco di neve. Si consiglia inoltre di caricare i dati dal nodo di replica per preservare la larghezza di banda CPU/IO del nodo master per il traffico online.

In questa fase, i carichi di lavoro ML potrebbero essere in esecuzione nel tuo ambiente locale. Puoi impostare un Giove notebook localmente e carica dati strutturati dal database OLAP, quindi addestra il tuo modello ML localmente.

Le potenziali sfide di questa architettura non sono limitate a:

- È difficile gestire dati non strutturati o semistrutturati con il database OLAP.

- OLAP potrebbe avere una regressione delle prestazioni quando si tratta di un’elaborazione massiccia dei dati. (più di TB di dati richiesti per una singola attività ETL)

- Mancanza di supporto per vari motori di calcolo, ad esempio Spark o Presto. La maggior parte del motore di calcolo supporta la connessione a OLAP con l’endpoint JDBC, ma l’elaborazione parallela sarà fortemente limitata dal collo di bottiglia I/O dell’endpoint JDBC stesso.

- Il costo di archiviazione di enormi quantità di dati nel database OLAP è elevato.

Potresti già conoscere la direzione per risolverlo. Costruisci un Data Lake! L’inserimento di Data Lake non significa necessariamente che sia necessario disattivare completamente il database OLAP. È ancora comune vedere aziende che fanno coesistere due sistemi per casi d’uso diversi.

Un data Lake consente di rendere persistenti dati non strutturati e semi-strutturati ed esegue schema-on-write. Ti consente di ridurre i costi archiviando grandi volumi di dati con una soluzione di archiviazione specializzata e creando cluster di elaborazione in base alla tua richiesta. Consente inoltre di gestire facilmente set di dati TB/PB aumentando i cluster di calcolo.

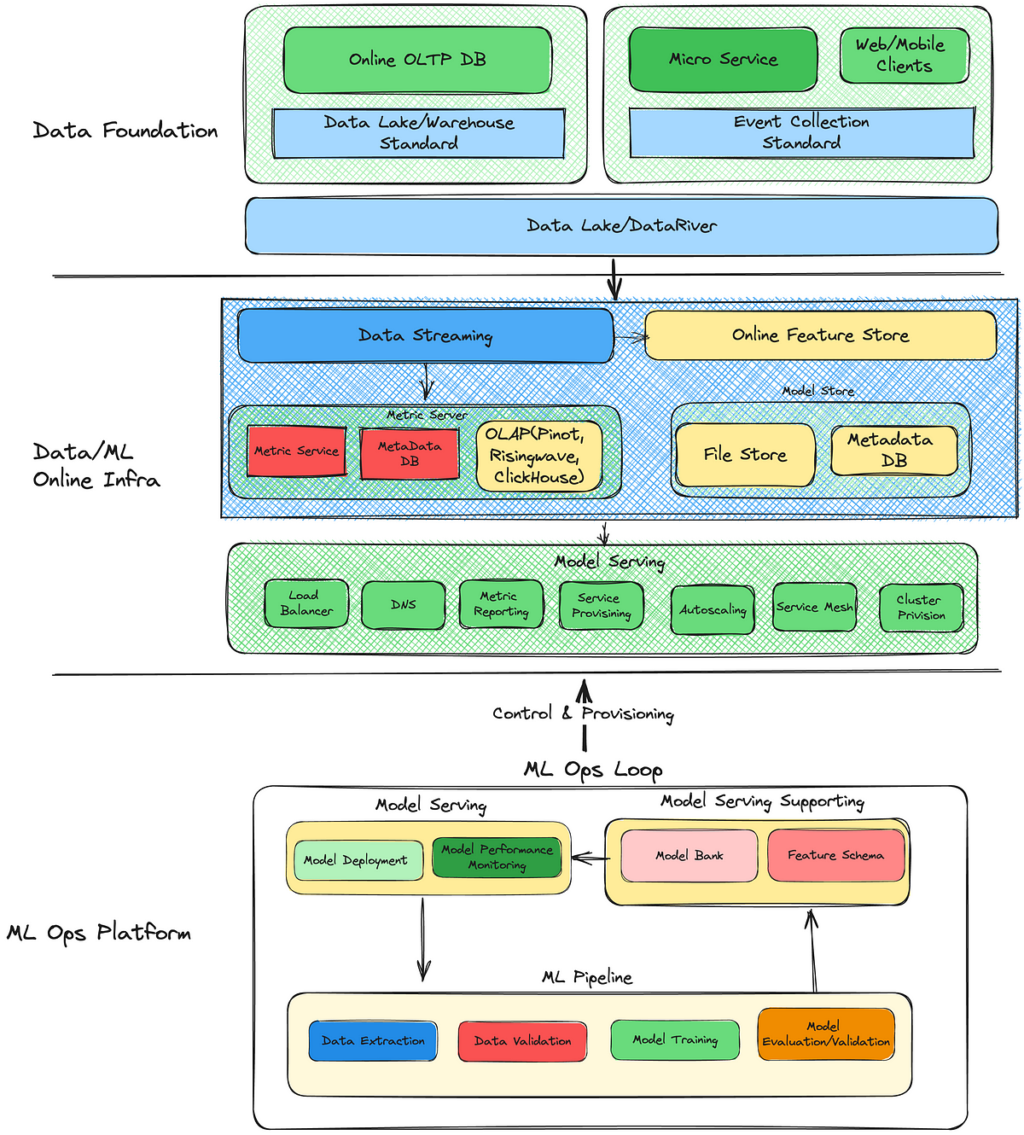

Ecco come potrebbe apparire la tua infrastruttura:

Fonte: towardsdatascience.com