La pipeline completa per la produzione di tour digitali (indicato come DIGITOUR e mostrato dentro Figura 3) è come segue.

2.1 Posizionamento dei tag e acquisizione delle immagini

Durante la creazione di un tour digitale per qualsiasi proprietà immobiliare, è essenziale fare clic su immagini a 360° da diverse posizioni della proprietà come camera da letto, soggiorno, cucina, ecc., quindi unirle automaticamente insieme per avere un “Procedura dettagliata“esperienza senza essere fisicamente presenti sul posto. Pertanto, per collegare più immagini equirettangolari, proponiamo di posizionare etichette di carta sul pavimento che coprano ogni posizione dell'immobile e di posizionare la telecamera (nel nostro caso abbiamo utilizzato Ricoh-Theta) al centro della scena per catturare l'intero sito (davanti, dietro, sinistra, destra e in basso).

Inoltre, ci assicuriamo che la scena sia priva di elementi rumorosi come luci soffuse e “indesiderato' artefatti per un migliore addestramento e inferenza del modello. Come mostrato in Figura 4abbiamo standardizzato i tag con dimensioni di 6â€ × 6†con due proprietà:

- sono numerati che aiuteranno il fotografo a posizionare i tag in sequenza e

- sono bicolori per formulare il problema del riconoscimento delle cifre come compito di classificazione e facilitare un migliore apprendimento dei compiti di visione artificiale a valle (cioè rilevamento dei tag e riconoscimento delle cifre).

Tieni presente che a ciascuna cifra sono assegnati colori diversi (dalle 0 alle 9) che utilizza lo schema colori HSV e la cifra iniziale di un tag presenta un cerchio nero per distinguerla dalla cifra finale, come mostrato in Figura 4. L'intuizione alla base della standardizzazione dei tag cartacei è quella di consentire di addestrare modelli di rilevamento dei tag e riconoscimento delle cifre, che sono invarianti a distorsioni, angolo di posizionamento dei tag, riflessione da fonti di illuminazione, condizioni di sfocatura e qualità della fotocamera.

2.2 Mappatura dell'immagine equirettangolare sulla proiezione della mappa cubica

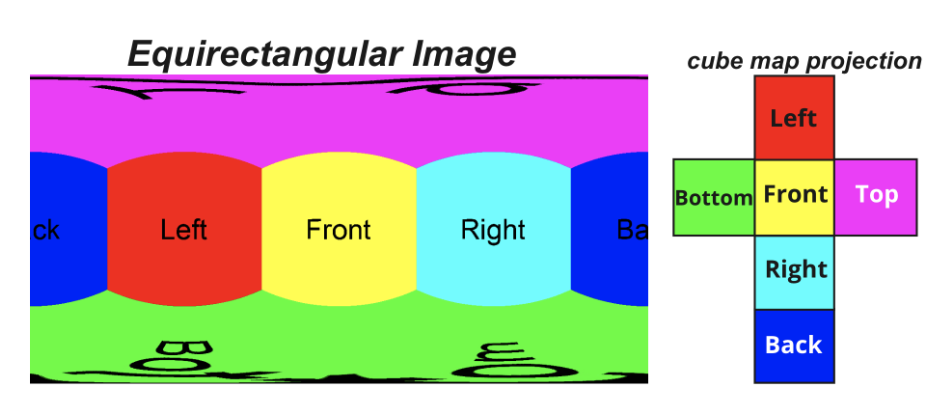

Un'immagine equirettangolare è costituita da una singola immagine la cui larghezza e altezza sono correlate come 2:1 (Come mostrato in Figura 1). Nel nostro caso, le immagini vengono scattate utilizzando una fotocamera Ricoh-Theta avente dimensioni 4096 × 2048 × 3. Tipicamente, ogni punto in un'immagine equirettangolare corrisponde a un punto in una sfera e le immagini vengono allungate nel ‘latitudinedirezione. Poiché i contenuti di un'immagine equirettangolare sono distorti, diventa difficile rilevare i tag e riconoscere le cifre direttamente da essa. Ad esempio, nel Figura 1il tag viene allungato nella parte centrale inferiore dell'immagine. Pertanto, è necessario mappare l'immagine su una proiezione meno distorta e tornare all'immagine equirettangolare originale per costruire il tour digitale.

In questo lavoro proponiamo di utilizzare la proiezione della mappa cubica, che è un insieme di sei immagini che rappresentano sei facce di un cubo. Qui ogni punto nello spazio delle coordinate sferiche corrisponde a un punto sulla faccia del cubo. Come mostrato in Figura 5mappiamo l'immagine equirettangolare su sei facce (sinistra, destra, davanti, dietro, sopra e sotto) di un cubo avente dimensioni 1024 × 1024 × 3 utilizzando la libreria Python vrProjector.

2.3 Rilevamento dei tag

Una volta ottenute le sei immagini corrispondenti alle facce di un cubo, rileviamo la posizione dei tag posizionati in ciascuna immagine. Per il rilevamento dei tag, abbiamo utilizzato il modello YOLOv5 all'avanguardia. Abbiamo inizializzato la rete con i pesi COCO seguiti dalla formazione sul nostro set di dati. Come mostrato in Figura 6il modello prende un'immagine come input e restituisce il tag rilevato insieme alle coordinate del riquadro di delimitazione e alla confidenza della previsione. Il modello viene addestrato sul nostro set di dati per 100 epoche con una dimensione batch di 32.

2.4 Riconoscimento delle cifre

Per i tag rilevati, dobbiamo riconoscere le cifre dal tag. In un ambiente reale, i tag rilevati potrebbero avere un orientamento errato, scarsa luminosità, riflesso delle lampadine nella stanza, ecc. Per questi motivi, è difficile utilizzare i motori di riconoscimento ottico dei caratteri (OCR) per ottenere un buon riconoscimento delle cifre. prestazione. Pertanto, abbiamo utilizzato un modello MobileNet personalizzato inizializzato sui pesi Imagenet, che utilizza le informazioni sul colore nei tag per il riconoscimento delle cifre. Nell'architettura proposta, abbiamo sostituito il blocco di classificazione finale della MobileNet originale con il dropout layer e il dense layer con 20 nodi che rappresentano i nostri tag da 1 a 20. Figura 7 illustra l'architettura proposta. Per addestrare il modello, abbiamo utilizzato Adam come ottimizzatore con un tasso di apprendimento di 0,001 e un fattore di sconto (𠜌) pari a 0,1. Abbiamo utilizzato l'entropia incrociata categorica come funzione di perdita e impostato la dimensione del batch su 64 e il numero di epoche su 50.

2.5 Mappatura delle coordinate dei tag sull'immagine 360â—¦ originale e creazione del tour virtuale

Una volta rilevati i tag e riconosciuto le cifre, utilizziamo la libreria Python vrProjector per mappare le coordinate della mappa del cubo sull'immagine equirettangolare originale. Un output di esempio è mostrato in Figura 8. Per ogni immagine equirettangolare, i tag rilevati formano i nodi di un grafico con un bordo tra di loro. Nelle successive immagini equirettangolari di una proprietà, il grafico viene popolato con più nodi, man mano che vengono rilevati più tag. Infine, colleghiamo più immagini equirettangolari in sequenza in base alle cifre riconosciute scritte su di esse e il grafico risultante è il

tour virtuale come mostrato in Figura 2(b).

Abbiamo raccolto dati inserendo tag e facendo clic su immagini equirettangolari utilizzando la fotocamera Ricoh-Theta per diverse proprietà residenziali a Gurugram, India (Città di primo livello). Durante la raccolta delle immagini ci siamo assicurati che fossero soddisfatte determinate condizioni, ad esempio tutte le porte erano aperte, le luci erano accese, “indesideratoGli oggetti sono stati rimossi e i cartellini sono stati posizionati coprendo ogni area della proprietà. Seguendo queste istruzioni, il numero medio di immagini equirettangolari cliccate per proprietà residenziale è stato di 7 o 8. Infine, abbiamo convalidato il nostro approccio sui seguenti set di dati generati (in base al colore di sfondo dei tag).

- Tag colorati verdi: Abbiamo mantenuto il colore di sfondo di questi tag (numerati da 1 a 20) essere verde. Abbiamo raccolto 1572 immagini equirettangolari da 212 proprietà. Una volta convertite queste immagini equirettangolari in proiezione di una mappa cubica, otteniamo 9432 immagini (corrispondenti alle facce del cubo). Poiché non tutte le facce del cubo hanno tag (per esempio la faccia superiore), otteniamo 1503 immagini con almeno un tag.

- Tag bicolore proposti (vedere Figura 4): Per questi tag abbiamo raccolto 2654 immagini equirettangolari da 350 proprietà. Alla fine, abbiamo ottenuto 2896 immagini (corrispondente alle facce del cubo) con almeno un tag.

Infine, etichettiamo i tag presenti nelle immagini di proiezione della mappa cubica utilizzando EtichettaImg che è uno strumento open source per etichettare le immagini in diversi formati come Pascal VOC e YOLO. Per tutti gli esperimenti abbiamo riservato il 20% dei dati ai test e il restante alla formazione.

Per qualsiasi immagine di input, rileviamo prima i tag e infine riconosciamo le cifre scritte sui tag. Da questo siamo stati in grado di individuare i veri aspetti positivi (tag rilevati e letti correttamente), falsi positivi (tag rilevati ma letti in modo errato) e falsi negativi (tag non rilevati). I valori mAP, precisione, richiamo e punteggio f1 ottenuti alla soglia di 0,5 IoU sono rispettivamente 88,12, 93,83, 97,89 e 95,81. Tieni presente che di tutti i parametri viene calcolata la media (ponderato) su tutte le 20 classi. Se tutti i tag su tutte le immagini equirettangolari di una proprietà vengono rilevati e letti correttamente, riceviamo un tour virtuale accurato al 100% poiché tutti i nodi del grafico vengono rilevati e collegati ai relativi bordi appropriati. Nei nostri esperimenti, siamo stati in grado di generare con precisione un tour virtuale accurato al 100% per il 94,55% delle proprietà. Le imprecisioni erano dovute alla presenza di artefatti colorati che venivano erroneamente rilevati come tag; e cattive condizioni di illuminazione.

Figura 9 dimostra le prestazioni del modello Yolov5 per il rilevamento dei tag basato su tag di colore verde e bicolore. Inoltre, vengono mostrati esperimenti e confronti di modelli sul riconoscimento delle cifre Figura 10.

Proponiamo una pipeline end-to-end (DIGITOUR) per la generazione automatica di tour digitali per proprietà immobiliari. Per ciascuna proprietà di questo tipo, posizioniamo innanzitutto le etichette di carta bicolore proposte che coprono ciascuna area della proprietà. Quindi, facciamo clic sulle immagini equirettangolari, quindi mappamo queste immagini su immagini di mappe cubiche meno distorte. Una volta ottenute le sei immagini corrispondenti alle facce del cubo, rileviamo la posizione dei tag utilizzando il modello YOLOv5, seguito dal riconoscimento delle cifre utilizzando il modello MobileNet. Il passaggio successivo consiste nel mappare le coordinate rilevate insieme alle cifre riconosciute sulle immagini equirettangolari originali. Infine, uniamo insieme tutte le immagini equirettangolari per costruire un tour virtuale. Abbiamo convalidato la nostra pipeline su un set di dati reali e dimostrato che le prestazioni della pipeline end-to-end sono 88,12 e 95,81 in termini di mAP e punteggio f1 alla soglia di 0,5 IoU mediata (ponderata) su tutte le classi.

Se trovi utile il nostro lavoro e lo utilizzi nei tuoi progetti, ti chiediamo gentilmente di citarlo. 😊

@inproceedings{chhikara2023digitour,

title={Digitour: Automatic digital tours for real-estate properties},

author={Chhikara, Prateek and Kuhar, Harshul and Goyal, Anil and Sharma, Chirag},

booktitle={Proceedings of the 6th Joint International Conference on Data Science \& Management of Data (10th ACM IKDD CODS and 28th COMAD)},

pages={223--227},

year={2023}

}

(1) Dragomir Anguelov, Carole Dulong, Daniel Filip, Christian Frueh, Stéphane Lafon, Richard Lyon, Abhijit Ogale, Luc Vincent e Josh Weaver. 2010. Google Street View: catturare il mondo a livello stradale. Computer 43, 6 (2010), 32–38.

(2) Mohamad Zaidi Sulaiman, Mohd Nasiruddin Abdul Aziz, Mohd Haidar Abu Bakar, Nur Akma Halili e Muhammad Asri Azuddin. 2020. Matterport: tour virtuale come nuovo approccio di marketing nel settore immobiliare durante la pandemia COVID-19. Nella Conferenza Internazionale sull'Innovazione nei Media e nel Visual Design (IMDES 2020). Atlantis Press, 221–226.

(3) Chinu Subudhi. 2021. Tour virtuali all'avanguardia a 360 gradi. https://www.mindtree.com/insights/resources/cutting-edge-360-degree-virtual-tours

(4) Glenn Jocher, Ayush Chaurasia, Alex Stoken, Jirka Borovec, NanoCode012, Yonghye Kwon, TaoXie, Jiacong Fang, Imyhxy, Kalen Michael, Lorna, Abhiram V, Diego Montes, Jebastin Nadar, Laughing, Tkianai, yxNONG, Piotr Skalski, Zhiqiang Wang, Adam Hogan, Cristi Fati, Lawrence Mammana, Alex Wang1900, Deep Patel, Ding Yiwei, Felix You, Jan Hajek, Laurentiu Diaconu e Mai Thanh Minh. 2022. ultralytics/yolov5: v6.1 – TensorRT, TensorFlow Edge TPU e OpenVINO Export and Inference.

(5) Mark Sandler, Andrew Howard, Menglong Zhu, Andrey Zhmoginov e LiangChieh Chen. 2018. Mobilenetv2: residui invertiti e colli di bottiglia lineari. Negli Atti della conferenza IEEE sulla visione artificiale e il riconoscimento di modelli. 4510–4520.

Fonte: towardsdatascience.com