TOggi ci immergeremo in un articolo che si basa sul grande successo di CLIP nella pre-formazione sul linguaggio-immagine e lo estende al compito di rilevamento di oggetti: GLIP — Garrotondato llingua-IOmago Priqualificazione. Tratteremo i concetti chiave e i risultati del documento e li renderemo facili da comprendere fornendo ulteriore contesto e aggiungendo annotazioni alle immagini e ai risultati degli esperimenti. Andiamo!

Carta: Pre-formazione linguistica-immagine fondata

Codice: https://github.com/microsoft/GLIP

Prima pubblicazione: 7 dicembre 2021

Autori: Liunian Harold Li, Pengchuan Zhang, Haotiano Zhang, Jianwei Yang, Chunyuan Li, Yiwu Zhong, Lijuan Wang, Lu Yuan, Lei Zhang, Jenq-Neng Hwang, Kai-Wei Chang, Jianfeng Gao

Categoria: apprendimento della rappresentazione, rilevamento di oggetti, radicamento delle frasi, apprendimento profondo multimodale, visione artificiale, elaborazione del linguaggio naturale, modelli di base

- Contesto e sfondo

- Contributi richiesti

- Metodo

- Esperimenti

- Ulteriori letture e risorse

PERDERE (Garrotondato llingua-IOmago Priqualificazione) è un modello linguaggio-immagine multimodale. Simile a CLIP (Contrastivo llingua-IOmago Pre-Training), esegue un pre-training contrastivo per apprendere rappresentazioni semanticamente ricche e allinearle attraverso le sue modalità. Mentre CLIP apprende queste rappresentazioni a livello di immagine, il che significa che una frase descrive l’intera immagine, GLIP mira ad estendere questo approccio alle rappresentazioni a livello di oggetto, il che significa che una frase potrebbe corrispondere a più oggetti all’interno dell’immagine. Viene chiamato il compito di identificare le corrispondenze tra i singoli token in un prompt di testo e gli oggetti o le regioni in un’immagine messa a terra della frase. Da qui la parola “Grounded” in GLIP.

Pertanto, GLIP mira a:

- Unifica la messa a terra delle frasi e il rilevamento degli oggetti per il pre-addestramento su larga scala.

- Fornire un framework flessibile per il rilevamento di oggetti zero-shot, dove flessibile significa che non è limitato a un insieme fisso di classi.

- Costruisci un modello pre-addestrato che si trasferisca senza problemi a varie attività e domini, in modalità zero-shot o pochi-shot.

Cosa puoi fare con un modello del genere? È possibile utilizzare istruzioni di testo per trovare oggetti o regioni di interesse all’interno di una determinata immagine di input. E la parte migliore: non sei limitato a classi predefinite.

Potresti elaborare ulteriormente questi rilevamenti (ad esempio inserendoli in un sistema di tracciamento) o creare un set di dati personalizzato con determinate classi di interesse e utilizzarli per addestrare il tuo sistema di rilevamento supervisionato. Non solo potresti coprire classi rare o molto specifiche, ma potresti anche risparmiare molto tempo e denaro per la creazione di etichette manuali. Come vedremo più avanti, gli autori di GLIP hanno avuto un’idea simile per migliorare ulteriormente le prestazioni introducendo un quadro insegnante-studente.

GLIP è stato adottato da molti altri progetti e ambiti del deep learning. Per esempio, GLIGEN (generazione dal linguaggio all’immagine) utilizza GLIP per condizionare la generazione dell’immagine di un modello di diffusione latente per aumentare la controllabilità. Inoltre, GLIP è stato combinato con altri modelli di fondazione come DINO (Autodistillazione senza etichette) E SAM (segmenta qualsiasi cosa) A Messa a terraDINO E Segmento con messa a terra: qualsiasi cosa rispettivamente. GLIPv2 estende il modello GLIP iniziale con la comprensione del linguaggio visivo non solo per migliorare la messa a terra delle frasi, ma anche per consentire attività di risposta visiva alle domande.

- Pre-formazione su larga scala per la messa a terra combinata di frasi e il rilevamento di oggetti

- Fornire una visione unificata sul rilevamento degli oggetti e sulla messa a terra delle frasi

- Profonda fusione intermodale per apprendere rappresentazioni visive di alta qualità consapevoli del linguaggio e per ottenere prestazioni di apprendimento di trasferimento superiori.

- Presentando che la pronta sintonizzazione è più efficace nella fusione profonda visione-linguaggio (ad esempio GLIP) che nelle reti a fusione superficiale (ad esempio CLIP)

Avendo un’idea approssimativa di cosa si può fare con GLIP, diamo uno sguardo più da vicino ai dettagli del documento.

Panoramica architettonica

Ad alto livello, l’architettura di GLIP è abbastanza simile a CLIPIn un certo senso consiste anche in un codificatore di testo, un codificatore di immagini e una sorta di apprendimento contrastivo sulla somiglianza delle caratteristiche del testo e dell’immagine. L’architettura di GLIP è mostrata in Fig. 2.

GLIP aggiunge un modulo di fusione profonda con riconoscimento del linguaggio e delle immagini dopo il codificatore di testo e immagini. Questo modulo esegue l’attenzione intermodale ed estrae ulteriori funzionalità. Viene calcolata una somiglianza coseno sulle caratteristiche della regione e sulle caratteristiche delle parole risultanti. Durante l’addestramento, la somiglianza delle coppie corrispondenti viene massimizzata, mentre ridotta al minimo per le coppie errate. In contrasto con CLIPdove le coppie corrispondenti si trovano sulla diagonale della matrice di somiglianza, in GLIP la corrispondenza non viene eseguita a livello di frase, ma a livello di (sotto)parola risultando in posizioni solitamente fuori diagonale.

Messa a terra della frase formulata come problema di rilevamento di oggetti

Gli autori hanno notato che il problema del radicamento della frase (= associazione di parole con oggetti/regioni in un’immagine) può essere formulato come Obiettivo di rilevamento degli oggetti, dove l’obiettivo di perdita standard è:

La perdita di localizzazione riguarda la qualità del riquadro di delimitazione previsto, che, a seconda del formato, potrebbe essere la dimensione e la posizione del riquadro. La perdita di classificazione è la parte fondamentale dell’unificazione. Calcolando i logit sul punteggio di somiglianza delle caratteristiche testo-immagine invece che sui logit di un classificatore di immagini, lo stesso obiettivo di perdita può essere utilizzato per l’addestramento.

Diverse varianti di modello

Cinque diversi modelli vengono addestrati per mostrare l’effetto delle scelte progettuali degli autori e della scala del modello:

Pre-formazione insegnante-studente

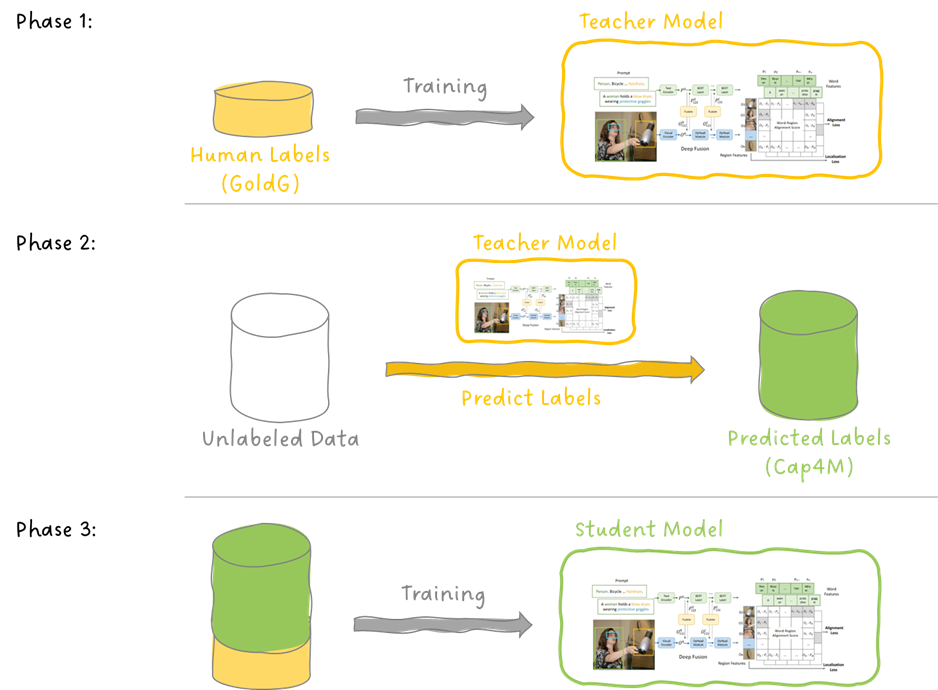

Per migliorare le prestazioni di GLIP, gli autori addestrano il modello GLIP-T (C) (vedi Fig.3) su dati annotati umani, chiamati GoldG, per generare dati di base da coppie testo-immagine da Internet. Chiamano questo modello il modello dell’insegnante e successivamente formano un modello di studente alimentandolo con i dati utilizzati per formare l’insegnante più i dati generati dall’insegnante. Vedere la Fig. 4 per un’illustrazione.

Nota: anche se vengono utilizzati i termini insegnante e studente, non si tratta dello stesso processo della distillazione della conoscenza, in cui un modello di studente più piccolo viene addestrato per corrispondere all’output di un modello di insegnante più grande.

È interessante notare che, come vedremo negli esperimenti, lo studente supera l’insegnante su molti (ma non tutti) set di dati per entrambi; rilevamento zero-shot e pochi-shot. Perché? L’articolo ipotizza che, anche se l’insegnante fornisce una previsione con scarsa sicurezza (la chiamano “ipotesi plausibile”), questa diventa la verità fondamentale (lo chiamano “segnale supervisionato”) nel set di dati generato e consumato dallo studente.

Il documento GLIP presenta vari esperimenti e studi di ablazione, riguardanti principalmente:

- Trasferimento di domini Zero-Shot

- Efficienza dei dati

- Ingegneria rapida

Ho qualche dubbio su alcuni risultati e sul modo in cui sono presentati e li segnalerò nelle note. Non voglio sminuire i risultati di GLIP e piuttosto guardarli con un occhio critico.

Ora passiamo ai dettagli!

Trasferimento di domini Zero-Shot

Innanzitutto, daremo uno sguardo ai risultati del trasferimento del dominio zero-shot. In questa attività l’obiettivo è analizzare il rendimento dei modelli GLIP pre-addestrati su un set di dati diverso (ad esempio COCO e LVIS) utilizzato durante la pre-formazione e confrontarlo con una linea di base con modelli che sono stati addestrati in modo supervisionato. Quindi, il GLIP pre-addestrato viene ulteriormente perfezionato e valutato sul set di dati in prova.

In Fig.5 vediamo i risultati dal trasferimento del dominio zero-shot in poi COCO. Vediamo che tutti i modelli GLIP hanno prestazioni migliori a 0 colpi come RCNN più veloce supervisionato. Ci viene inoltre presentato il risultato che GLIP-L supera il precedente SOTA (al momento della pubblicazione del documento). Vediamo che lo studente più grande GLIP-L supera il modello dell’insegnante GLIP-T (C).

Di seguito elenco i miei dubbi nel leggere questi risultati e le affermazioni fatte nel documento, dove si dice che GLIP-L supera il miglior modello supervisionato SoftTeacher.

- Il modello che ha parametri migliori rispetto a SoftTeacher è GLIP-L, che è migliore di 0,2 punti. Questo piccolo margine potrebbe non essere il risultato del nuovo metodo GLIP ma potrebbe essere dovuto ad alcune differenze negli iperparametri di addestramento.

- GLIP-L non utilizza nemmeno i dati (Cap4M o Cap24M) generati dal modello dell’insegnante che ha presentato come una buona soluzione.

- GLIP-L è stato addestrato su un corpus molto più ampio di dati di addestramento come SoftTeacher.

A mio avviso, i risultati del confronto tra i diversi modelli GLIP e il DyHead-T da loro addestrato sono assolutamente soddisfacenti, ho solo i miei dubbi in generale quando metodi e modelli diversi vengono confrontati con vincoli poco chiari o diversi.

In Fig.6, vediamo le prestazioni di trasferimento del dominio zero-shot su HVAC set di dati. Possiamo vedere che il modello GLIP più grande, GLIP-L, supera tutti gli altri modelli supervisionati presentati.

Infine, GLIP è stato confrontato in termini di prestazioni di messa a terra delle frasi sulle entità Flickr30K rispetto a MDETR (vedere Fig.7). Entrambi i modelli studenteschi, GLIP-T e GLIP-L, superano le linee di base MDETR.

Efficienza dei dati

Un altro esperimento riguarda l’efficienza dei dati. Questo esperimento mira a mostrare come cambiano le prestazioni (in termini di precisione media) quando si mette a punto un modello pre-addestrato su un certo numero di dati specifici dell’attività. In Fig.8, i modelli sono valutati su 13 diversi set di dati e le loro prestazioni sono riportate come precisione media mediata sui 13 set di dati. I risultati sono riportati per 0-shot, 1-shot, 3-shot, 5-shot, 10-shot e “all”-shot (dubito che sia un termine ufficiale per la messa a punto completa, ma immagino che tu abbia capito il punto 😅 ).

Ingegneria rapida

Simile come in CLIPgli autori riportano inoltre una correlazione tra le prestazioni del modello e la formulazione del prompt testuale di input. Propongono due tecniche per migliorare le prestazioni di un modello pre-addestrato, senza la necessità di riqualificare i pesi del modello:

- Sintonizzazione rapida manuale

- Sintonizzazione rapida

L’idea della sintonizzazione manuale dei prompt è quella di fornire ulteriore contesto sotto forma di parole descrittive aggiuntive, vedere Fig. 9:

L’ottimizzazione manuale dei prompt può sempre essere utilizzata per migliorare le prestazioni, il che significa che non importa se il modello è completamente ottimizzato o se viene utilizzato in uno scenario zero-shot o pochi-shot.

Il secondo approccio, la messa a punto del prompt, richiede l’accesso alle etichette di verità di base di un’attività a valle ed è particolarmente adatto per scenari in cui ogni attività di rilevamento ha un singolo prompt (ad esempio “Rileva auto”). In tale scenario, questa richiesta verrebbe prima tradotta in un’incorporamento di funzionalità utilizzando il codificatore di testo. Quindi, il codificatore di immagini e il modulo di fusione profonda vengono congelati e solo l’incorporamento dell’input viene ottimizzato utilizzando le etichette ground Truth. Gli incorporamenti ottimizzati servirebbero quindi come input per il modello e il codificatore di testo potrebbe essere rimosso.

La Fig.10 mostra il risultato di questa rapida messa a punto per vari modelli GLIP. Se applicata a modelli dotati di modulo di fusione profonda, la messa a punto rapida raggiunge quasi le stesse prestazioni della regolazione fine dei pesi del modello.

Come accennato all’inizio di questo articolo, GLIP è stato ampiamente adottato da un vasto numero di progetti.

Di seguito un elenco di documenti basati su GLIP: