Confronta le prestazioni e l’efficienza energetica della GPU Apple Silicon M2 Max con Nvidia V100 per addestrare i grandi modelli della CNN con TensorFlow

Nel mio articolo precedenteHo confrontato la GPU M2 Max con Nvidia V100, P100 e T4 durante la formazione MLP, CNN e LSTM. I risultati mostrano che M2 Max può funzionare molto bene, superando le GPU Nvidia nell’addestramento su modelli piccoli. Ma come si legge nell’articolo:

(…) queste metriche possono essere prese in considerazione solo per tipi e profondità di rete neurale simili a quelli utilizzati in questo test.

Quindi questa seconda parte testa modelli più grandi, concentrandosi solo sulla CNN e confrontando M2 Max con la GPU più potente testata in precedenza: la Nvidia V100.

Un altro punto considerato in questo test è gestione della memoria. Mentre la GPU Nvidia perde molto tempo nel trasferimento della memoria, la GPU M2 Max ha accesso diretto alla memoria unificata, quindi non richiede alcun ritardo prima di addestrare il modello. Poiché, come mostrato nei risultati nell’articolo precedente, ciò fa una grande differenza per i modelli piccoli addestrati su un numero limitato di epoche, rimuoviamo questo effetto per i modelli più grandi per confrontare solo il tempo di addestramento puro.

A questo scopo, addestriamo i modelli su dieci epoche, ma invece di utilizzare il tempo di addestramento totale, catturiamo e calcoliamo la media della durata di addestramento del passaggio dalla seconda epoca all’ultima. Ciò rimuove il sovraccarico di inizializzazione e trasferimento di memoria, che si riflette parzialmente anche nella prima epoca.

E l’ultimo, ma al giorno d’oggi il punto più cruciale, è il energia consumata dalle GPU per addestrare un grande modello. Come mostreremo qui, è qui che M2 Max rappresenta un vero punto di svolta.

In questo articolo troverai i seguenti test:

- Addestramento di quattro CNN personalizzate che vanno da 122.570 a 1.649.482 parametri su CIFAR-10¹ con dimensione batch compresa tra 32 e 1024

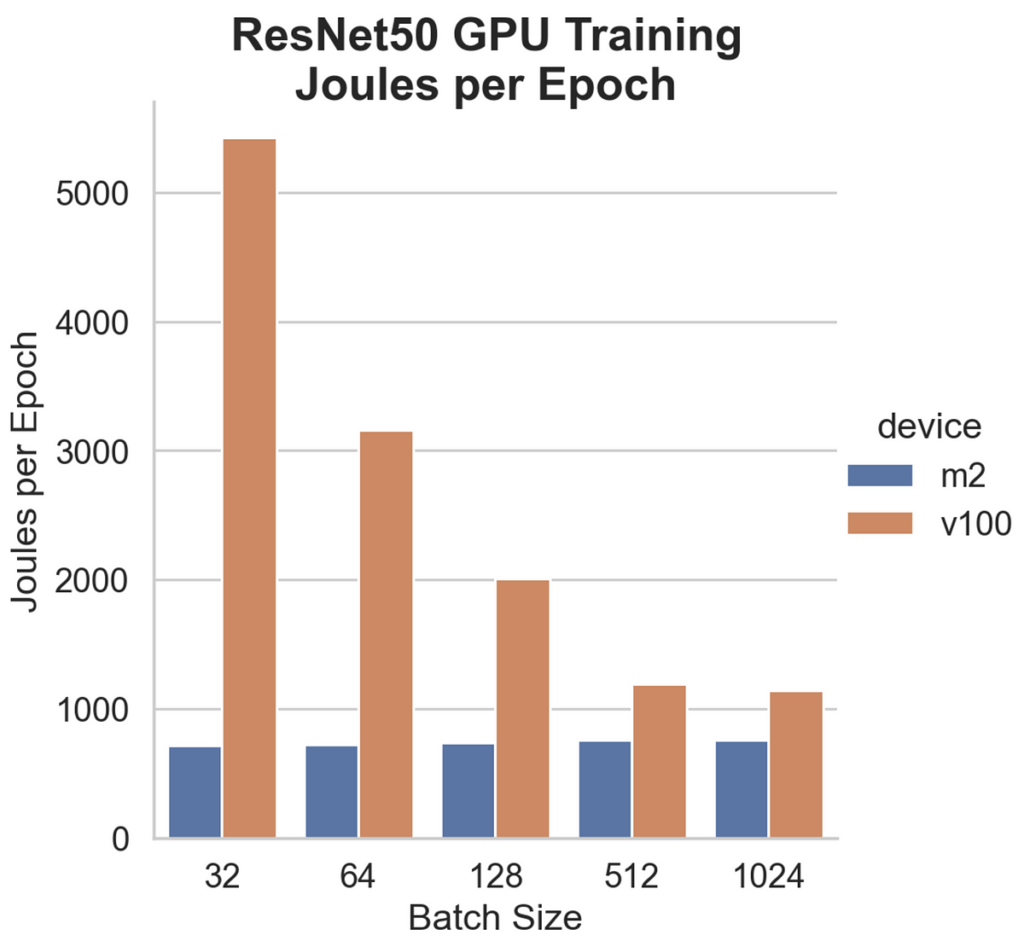

- Formazione ResNet50 modello acceso CIFAR-10 con dimensione batch compresa tra 32 e 1024

Quindi, nei due casi, confronterò:

- le prestazioni grezze dell’allenamento (durata dell’epoca in millisecondi)

- il consumo energetico per epoca

- il rapporto di efficienza energetica tra le due GPU

Fonte: towardsdatascience.com