Un’analisi empirica per verificare se i modelli ML commettono più errori quando effettuano previsioni su valori anomali

Ogli utilizzatori sono individui molto diversi dalla maggioranza della popolazione. Tradizionalmente, tra i professionisti c’è una certa sfiducia nei confronti degli outlier, ecco perché vengono spesso adottate misure ad hoc come la loro rimozione dal set di dati.

Tuttavia, quando si lavora con dati reali, i valori anomali sono all’ordine del giorno. A volte sono ancora più importanti di altre osservazioni! Prendiamo ad esempio il caso di individui che sono outlier perché sono clienti molto ben pagati: non vuoi scartarli, anzi, probabilmente vorrai trattarli con particolare attenzione.

Un aspetto interessante, e abbastanza inesplorato, degli outlier è il modo in cui interagiscono con i modelli ML. La mia sensazione è che i data scientist credano che i valori anomali danneggino le prestazioni dei loro modelli. Ma questa convinzione si basa probabilmente più su un preconcetto che su prove reali.

Pertanto, la domanda a cui cercherò di rispondere in questo articolo è la seguente:

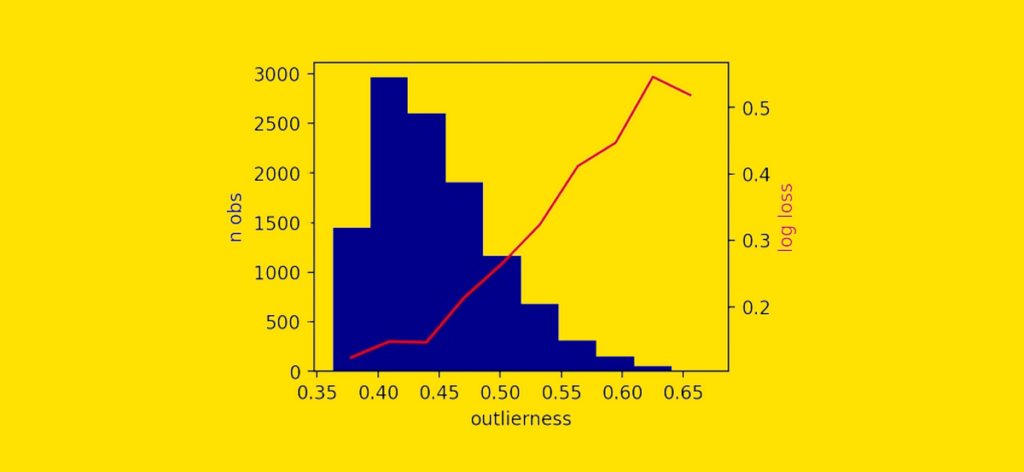

È più probabile che un modello ML commetta errori quando fa previsioni sui valori anomali?

Supponiamo di avere un modello addestrato su questi punti dati:

Riceviamo nuovi punti dati per i quali il modello dovrebbe fare previsioni.

Consideriamo due casi:

- il nuovo punto dati è un valore anomalo, cioè diverso dalla maggior parte delle osservazioni di addestramento.

- il nuovo punto dati è “standard”, cioè si trova in un’area piuttosto “densa” di punti allenamento.

Vorremmo capire se, in generale, l’outlier sia più difficile da prevedere rispetto all’osservazione standard.

Fonte: towardsdatascience.com