Il patrimonio di dati si sta evolvendo e la gestione della qualità dei dati deve evolversi di pari passo. Ecco tre approcci comuni e la direzione in cui si sta dirigendo il settore nell’era dell’intelligenza artificiale.

Sono parole diverse per la stessa cosa? Approcci unici allo stesso problema? Qualcos'altro di completamente?

E, cosa più importante: hai davvero bisogno di tutti e tre?

Come ogni cosa nell'ingegneria dei dati, la gestione della qualità dei dati si sta evolvendo alla velocità della luce. L’aumento vertiginoso dei dati e dell’intelligenza artificiale nelle aziende ha reso la qualità dei dati un rischio zero per le aziende moderne e IL problema da risolvere per i team che si occupano di dati. Con così tanta terminologia sovrapposta, non è sempre chiaro come tutto si integri insieme o Se si adatta insieme.

Ma contrariamente a quanto alcuni potrebbero sostenere, il monitoraggio della qualità dei dati, il test dei dati e l'osservabilità dei dati non sono approcci contraddittori o addirittura alternativi alla gestione della qualità dei dati: sono elementi complementari di un'unica soluzione.

In questo articolo approfondirò le specifiche di queste tre metodologie, dove funzionano meglio, dove falliscono e come puoi ottimizzare le tue pratiche di qualità dei dati per promuovere la fiducia dei dati nel 2024.

Prima di poter comprendere la soluzione attuale, dobbiamo comprendere il problema e come è cambiato nel tempo. Consideriamo la seguente analogia.

Immagina di essere un ingegnere responsabile della fornitura idrica locale. Quando hai accettato il lavoro, la città aveva solo una popolazione di 1.000 residenti. Ma dopo che l'oro viene scoperto sotto la città, la tua piccola comunità di 1.000 abitanti si trasforma in una vera e propria città di 1.000.000 di abitanti.

Come potrebbe cambiare il modo in cui svolgi il tuo lavoro?

Per cominciare, in un ambiente piccolo, i punti di guasto sono relativamente minimi: se un tubo si rompe, la causa principale potrebbe essere ridotta a uno dei due colpevoli attesi (tubi ghiacciati, qualcuno che scava nella linea di galleggiamento, il solito) e risolta altrettanto rapidamente con le risorse di uno o due dipendenti.

Con le serpeggianti condutture di 1 milione di nuovi residenti da progettare e mantenere, il ritmo frenetico necessario per soddisfare la domanda e le capacità (e visibilità) limitate del tuo team, non hai più la stessa capacità di individuare e risolvere ogni problema che ti aspetti apparire, tanto meno stare all'erta per quelli che non compaiono.

L'ambiente dati moderno è lo stesso. I team di dati hanno raggiunto l’oro e le parti interessate vogliono partecipare all’azione. Quanto più l’ambiente dei dati cresce, tanto più impegnativa diventa la qualità dei dati e meno efficaci saranno i metodi tradizionali di qualità dei dati.

Non hanno necessariamente torto. Ma non bastano neanche loro.

Per essere molto chiari, ciascuno di questi metodi tenta di affrontare qualità dei dati. Quindi, se questo è il problema, devi farlo costruire o acquistare poiché ognuno di questi teoricamente selezionerebbe quella casella. Tuttavia, solo perché queste sono tutte soluzioni per la qualità dei dati non significa che risolveranno effettivamente il problema della qualità dei dati.

Quando e come queste soluzioni dovrebbero essere utilizzate è un po’ più complesso di così.

In termini più semplici, si può pensare alla qualità dei dati come al problema; test e monitoraggio come metodi per identificare problemi di qualità; e l'osservabilità dei dati come approccio diverso e completo che combina ed estende entrambi i metodi con funzionalità di visibilità e risoluzione più profonde per risolvere la qualità dei dati su larga scala.

O per dirla in modo ancora più semplice, il monitoraggio e i test identificano i problemi: l’osservabilità dei dati identifica i problemi e li rende fruibili.

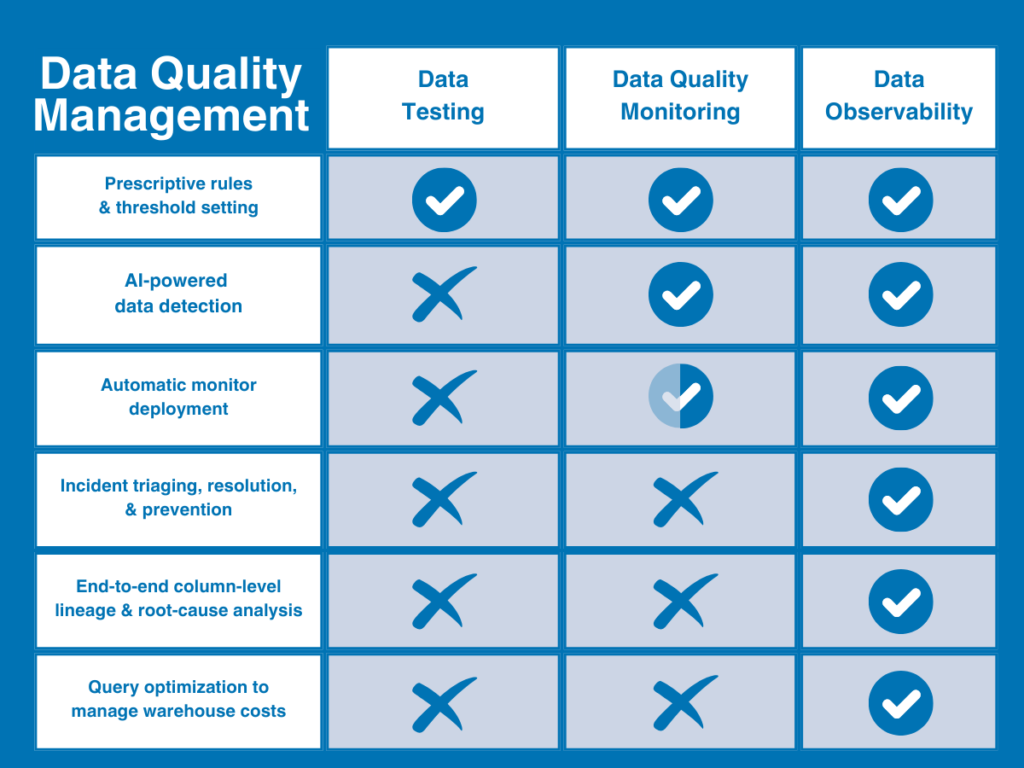

Ecco una breve illustrazione che potrebbe aiutare a visualizzare dove si inserisce l'osservabilità dei dati curva di maturità della qualità dei dati.

Ora, analizziamo ciascun metodo in modo un po' più dettagliato.

Il primo dei due approcci tradizionali alla qualità dei dati è il test dei dati. Test sulla qualità dei dati (o semplicemente test dei dati) è un metodo di rilevamento che utilizza vincoli o regole definiti dall'utente per identificare specifici problemi noti all'interno di un set di dati al fine di convalidare l'integrità dei dati e garantire specifici standard di qualità dei dati.

Per creare un test dei dati, il proprietario della qualità dei dati scriverebbe una serie di script manuali (generalmente in SQL o sfruttando una soluzione modulare come dbt) per rilevare problemi specifici come tassi null eccessivi o modelli di stringhe errati.

Quando le esigenze di dati, e di conseguenza le esigenze di qualità dei dati, sono molto ridotte, molti team saranno in grado di ottenere ciò di cui hanno bisogno con semplici test dei dati. Tuttavia, man mano che i tuoi dati crescono in dimensioni e complessità, ti ritroverai rapidamente ad affrontare nuovi problemi di qualità dei dati e ad aver bisogno di nuove funzionalità per risolverli. E quel momento arriverà molto prima o poi.

Anche se il test dei dati continuerà a essere una componente necessaria di un quadro di riferimento per la qualità dei dati, risulta insufficiente in alcune aree chiave:

- Richiede una conoscenza approfondita dei dati — Il test dei dati richiede che gli ingegneri dei dati abbiano 1) una conoscenza del dominio abbastanza specializzata per definire la qualità e 2) una conoscenza sufficiente di come i dati potrebbero rompersi per impostare test per convalidarli.

- Nessuna copertura per problemi sconosciuti – I test sui dati possono solo dirti sui problemi che ti aspetti di trovare, non sugli incidenti che non trovi. Se un test non è scritto per coprire un problema specifico, il test non lo troverà.

- Non scalabile — scrivere 10 test per 30 tabelle è leggermente diverso da scrivere 100 test per 3.000.

- Visibilità limitata — Il test dei dati testa solo i dati stessi, quindi non può dirti se il problema è davvero un problema con i dati, il sistema o il codice che li alimenta.

- Nessuna risoluzione — anche se il test dei dati rileva un problema, non ti avvicinerà alla sua risoluzione; o capire cosa e chi ha un impatto.

A qualsiasi livello di scala, i test diventano l’equivalente dei dati di gridare “al fuoco!” in una strada affollata e poi allontanarsi senza dire a nessuno dove l'hai visto.

Un altro approccio tradizionale, anche se un po’ più sofisticato, alla qualità dei dati, monitoraggio della qualità dei dati è una soluzione continua che monitora e identifica continuamente anomalie sconosciute nascoste nei tuoi dati attraverso l'impostazione manuale delle soglie o l'apprendimento automatico.

Ad esempio, i tuoi dati arrivano in tempo? Hai ottenuto il numero di righe che ti aspettavi?

Il vantaggio principale del monitoraggio della qualità dei dati è che fornisce una copertura più ampia per le incognite sconosciute e libera gli ingegneri dei dati dalla scrittura o dalla clonazione di test per ciascun set di dati per identificare manualmente i problemi comuni.

In un certo senso, potresti considerare il monitoraggio della qualità dei dati più olistico rispetto ai test perché confronta i parametri nel tempo e consente ai team di scoprire modelli che non vedrebbero da un singolo test unitario dei dati per un problema noto.

Sfortunatamente, anche il monitoraggio della qualità dei dati è insufficiente in alcune aree chiave.

- Aumento dei costi di elaborazione — il monitoraggio della qualità dei dati è costoso. Come il test dei dati, il monitoraggio della qualità dei dati interroga direttamente i dati, ma poiché è destinato a identificare incognite sconosciute, deve essere applicato ampiamente per essere efficace. Ciò significa grandi costi di elaborazione.

- Time-to-value lento — le soglie di monitoraggio possono essere automatizzate con l'apprendimento automatico, ma dovrai comunque prima creare ciascun monitoraggio tu stesso. Ciò significa che eseguirai molta codifica per ogni problema sul front-end e quindi ridimensionerai manualmente tali monitor man mano che l'ambiente dei dati cresce nel tempo.

- Visibilità limitata — i dati possono rompersi per tutti i tipi di motivi. Proprio come i test, il monitoraggio esamina solo i dati stessi, quindi può solo dirti che si è verificata un'anomalia, non il motivo.

- Nessuna risoluzione — sebbene il monitoraggio possa certamente rilevare più anomalie rispetto ai test, non è ancora in grado di dirti cosa è stato interessato, chi deve esserne informato o se qualcosa di tutto ciò è importante in primo luogo.

Inoltre, perché il monitoraggio della qualità dei dati è solo più efficace consegnare avvisi, non gestirli, è molto più probabile che il tuo team di dati li riscontri stanchezza vigile su larga scala piuttosto che migliorare effettivamente l'affidabilità dei dati nel tempo.

Ciò lascia l’osservabilità dei dati. A differenza dei metodi sopra menzionati, l’osservabilità dei dati si riferisce a a completo soluzione indipendente dal fornitore progettata per fornire una copertura completa della qualità dei dati, scalabile e utilizzabile.

Ispirato dalle migliori pratiche di ingegneria del software, osservabilità dei dati è un approccio end-to-end abilitato all'intelligenza artificiale alla gestione della qualità dei dati, progettato per rispondere a cosa, chi, perché e come dei problemi di qualità dei dati all'interno di un'unica piattaforma. Compensa le limitazioni dei metodi tradizionali di qualità dei dati sfruttando sia i test che il monitoraggio della qualità dei dati completamente automatizzato in un unico sistema, estendendo quindi tale copertura ai livelli di dati, sistema e codice dell'ambiente dati.

In combinazione con le funzionalità di gestione e risoluzione degli incidenti critici (come la derivazione automatizzata a livello di colonna e i protocolli di avviso), l'osservabilità dei dati aiuta i team di dati a rilevare, classificare e risolvere i problemi di qualità dei dati dall'acquisizione al consumo.

Inoltre, l'osservabilità dei dati è progettata per fornire valore a livello interfunzionale promuovendo la collaborazione tra i team, inclusi ingegneri dei dati, analisti, proprietari di dati e parti interessate.

L’osservabilità dei dati risolve le carenze della tradizionale pratica DQ in 4 modi chiave:

- Triage e risoluzione efficaci degli incidenti – cosa ancora più importante, l'osservabilità dei dati fornisce le risorse per risolvere gli incidenti più rapidamente. Oltre al tagging e agli avvisi, l'osservabilità dei dati accelera il processo di root-cause con una derivazione automatizzata a livello di colonna che consente ai team di vedere a colpo d'occhio cosa è stato interessato, chi deve saperlo e dove rivolgersi per risolverlo.

- Visibilità completa — L'osservabilità dei dati estende la copertura oltre le origini dati fino all'infrastruttura, alle pipeline e ai sistemi di post-acquisizione in cui i dati vengono spostati e trasformati per risolvere i problemi relativi ai dati per i team di dominio in tutta l'azienda

- Time-to-value più rapido — l'osservabilità dei dati automatizza completamente il processo di configurazione con monitor basati su ML che forniscono una copertura immediata immediatamente senza codifica o impostazione di soglie, in modo da poter ottenere una copertura più rapida che si adatta automaticamente al tuo ambiente nel tempo ( insieme a approfondimenti personalizzati e strumenti di codifica semplificati per rendere più semplici anche i test definiti dall'utente).

- Monitoraggio dello stato del prodotto dati — L'osservabilità dei dati estende inoltre il monitoraggio e il monitoraggio dello stato oltre il tradizionale formato tabellare per monitorare, misurare e visualizzare lo stato di specifici prodotti dati o risorse critiche.

Abbiamo tutti sentito la frase “immondizia dentro, spazzatura fuori”. Ebbene, questa massima è doppiamente vera per le applicazioni di intelligenza artificiale. Tuttavia, l’intelligenza artificiale non ha semplicemente bisogno di una migliore gestione della qualità dei dati per informare i suoi risultati; la gestione della qualità dei dati dovrebbe inoltre essere alimentata dall'intelligenza artificiale stessa al fine di massimizzare la scalabilità per l'evoluzione del patrimonio di dati.

L’osservabilità dei dati è di fatto – e probabilmente l’unica – soluzione di gestione della qualità dei dati che consente ai team di dati aziendali di fornire in modo efficace dati affidabili per l’intelligenza artificiale. E parte del modo in cui raggiunge questa impresa è anche essere una soluzione abilitata all’intelligenza artificiale.

Sfruttando l'intelligenza artificiale per la creazione di monitor, il rilevamento di anomalie e l'analisi delle cause principali, l'osservabilità dei dati consente una gestione della qualità dei dati iperscalabile per lo streaming di dati in tempo reale, architetture RAG e altro Casi d'uso dell'intelligenza artificiale.

Poiché il patrimonio di dati continua ad evolversi per l'azienda e non solo, i metodi tradizionali di qualità dei dati non sono in grado di monitorare tutti i modi in cui la piattaforma dati può rompersi o di aiutarti a risolverli quando lo fanno.

Soprattutto nell’era dell’intelligenza artificiale, la qualità dei dati non è solo un rischio aziendale ma anche esistenziale. Se non puoi fidarti della totalità dei dati inseriti nei tuoi modelli, non puoi fidarti nemmeno dell'output dell'intelligenza artificiale. Considerando la scala vertiginosa dell’intelligenza artificiale, i metodi tradizionali di qualità dei dati semplicemente non sono sufficienti per proteggere il valore o l’affidabilità di tali risorse di dati.

Per essere efficaci, sia il test che il monitoraggio devono essere integrati in un'unica soluzione indipendente dalla piattaforma in grado di monitorare oggettivamente l'intero ambiente dati (dati, sistemi e codice) end-to-end e quindi dotare i team di dati delle risorse per triage e risolvere i problemi più velocemente.

In altre parole, per rendere utile la gestione della qualità dei dati, i moderni data team necessitano dell’osservabilità dei dati.

Primo passo. Rileva. Secondo passo. Risolvere. Terzo passo. Prosperare.

Fonte: towardsdatascience.com