L’applicazione diffusa dell’apprendimento automatico e dell’intelligenza artificiale in vari settori comporta maggiori sfide per quanto riguarda i rischi e le valutazioni etiche. Come visto in casi di studio come il modello di recidiva penale riportato da ProPublica, Gli algoritmi di machine learning possono essere incredibilmente distorti e, di conseguenza, sono necessari robusti meccanismi di spiegabilità per garantire fiducia e sicurezza quando questi modelli vengono implementati in aree ad alto rischio.

Quindi, come bilanciare l’interpretabilità con l’accuratezza e l’espressività del modello? Bene, i ricercatori di Meta AI hanno proposto un nuovo approccio che hanno soprannominato Modelli a base neurale (NBM)(1)una sottofamiglia di modelli additivi generalizzati che raggiungono prestazioni all’avanguardia (SOTA) su set di dati di riferimento pur mantenendo l’interpretabilità della scatola di vetro.

In questo articolo, mi propongo di spiegare l’NBM e cosa lo rende un modello vantaggioso. Come al solito, incoraggio tutti a leggere il documento originale.

Se sei interessato all’apprendimento automatico interpretabile e ad altri aspetti dell’intelligenza artificiale etica, valuta la possibilità di dare un’occhiata ad alcuni dei miei altri articoli e di seguirmi!

IA interpretabile ed etica

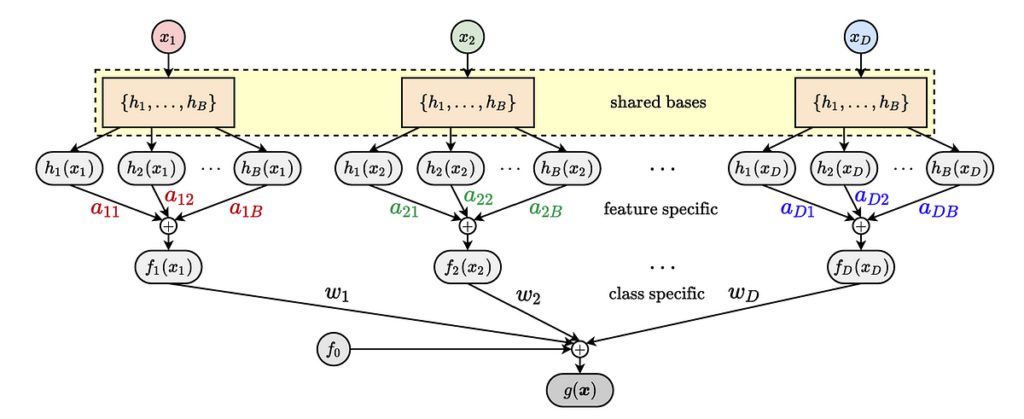

NBM è considerato un modello additivo generalizzato (GAM). I GAM sono modelli intrinsecamente interpretabili che apprendono una funzione di forma per ciascuna caratteristica e le previsioni vengono effettuate “interrogando” la funzione di forma. Poiché queste funzioni di forma sono indipendenti, l’impatto di una caratteristica sulla previsione può essere compreso visualizzando queste funzioni di forma, rendendole altamente spiegabili. Le interazioni tra le variabili vengono modellate passando più variabili nella stessa funzione e costruendo la funzione di forma basata su quella (di solito limitando il numero di variabili a 2 per l’interoperabilità), una configurazione chiamata GA2M.

I vari modelli GAM e GA2M utilizzano meccanismi diversi per sviluppare queste funzioni di forma. L’Explainable Boosting Machine (EBM) (2) utilizza una serie di alberi potenziati addestrati su ciascuna funzionalità, i Neural Additive Models (NAM) (3) utilizzano una rete neurale profonda per ciascuna funzionalità e NODE-GAM (4) utilizza insiemi di…

Fonte: towardsdatascience.com