Il Machine Learning non è mai corretto al 100%. Pertanto, un modello ML è utile solo quando gli utenti comprendono l’incertezza delle previsioni.

Quasi ogni giorno scopriamo il lancio di un nuovo prodotto, servizio o set di dati di machine learning. È l’era dell’intelligenza artificiale e, tuttavia, raramente qualcuno di questi prodotti informa su quanta fiducia l’utente dovrebbe avere nei risultati. Tuttavia, come ricerca dimostra che un buon processo decisionale richiede la conoscenza di quando fidarsi dell’IA e quando no. Altrimenti, porta alla situazione comune in cui gli utenti devono provare frequentemente il modello per capire quando fidarsi e quando non fidarsi di quel modello e per scoprire se il prodotto offerto è utile per loro.

La ragione di questo principio di prova ed errore da parte dell’utente è che ogni modello (non importa se è basato su ML o statistiche) è costruito sui dati e sulla loro incertezza. I dati sottostanti del modello non rappresentano la verità fondamentale di ciò che il modello dovrebbe prevedere. Altrimenti, se quella verità fondamentale fosse disponibile, non avresti bisogno di un modello in primo luogo. Pertanto, il modello risultante fornirà solo una stima e non un valore di verità.

In breve, la correttezza dell’apprendimento automatico e dei modelli statistici è incerta e non sempre ci si può fidare.

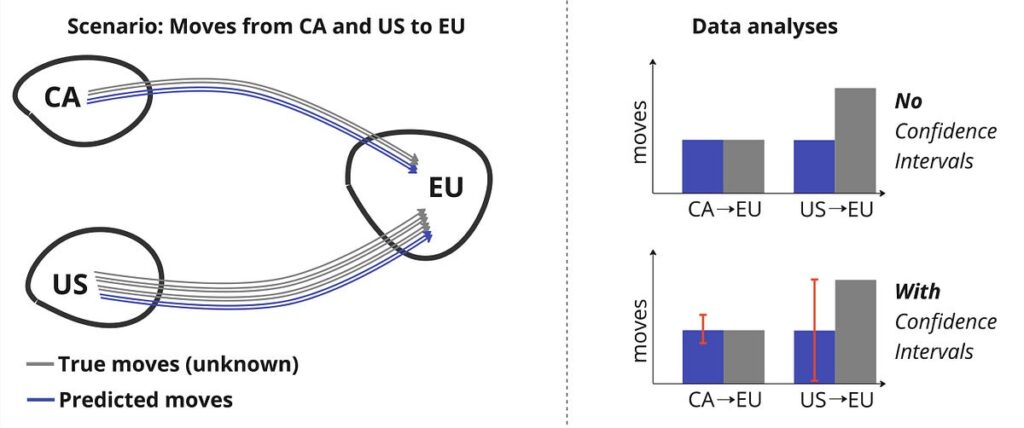

Facciamo un esempio (Figura 1). Immagina un prodotto che ti fornisca la quantità di persone che si spostano da un paese all’altro. Naturalmente, esistono dati (come le dichiarazioni fiscali) che forniranno tali informazioni, ma quei dati rappresenterebbero davvero l’intera popolazione dei movimenti? Ogni studente, immigrato o ex-padre sta modificando la propria dichiarazione dei redditi? No, molto probabilmente non è così. Pertanto, anche un prodotto semplice come fornire movimenti è distorto rispetto al campione di dati sottostante (ad esempio i resoconti fiscali disponibili al pubblico). È facile immaginare come i prodotti più sofisticati possano essere distorti.

Per l’apprendimento automatico, questa limitazione diventa ancora peggiore semplicemente a causa della sua natura probabilistica, della molteplicità degli input e ciascun input rappresenta solo una piccola parte della popolazione. Pertanto, il modello sottostante sarà sbilanciato verso la maggior parte dei casi descritti nei dati di addestramento e divergerà dal…

Fonte: towardsdatascience.com