Sfruttare modelli basati su concetti semi-supervisionati con ECM

CME si basa su un’osservazione simile evidenziata in (3), dove si è osservato che i modelli CNN vanilla spesso conservano un’elevata quantità di informazioni relative ai concetti nella loro spazio nascosto, che può essere utilizzato per l’estrazione di informazioni sui concetti senza costi di annotazione aggiuntivi. È importante sottolineare che questo lavoro ha considerato lo scenario in cui si trovano i concetti sottostanti sconosciutoe doveva essere estratto dallo spazio nascosto di una modella senza supervisione.

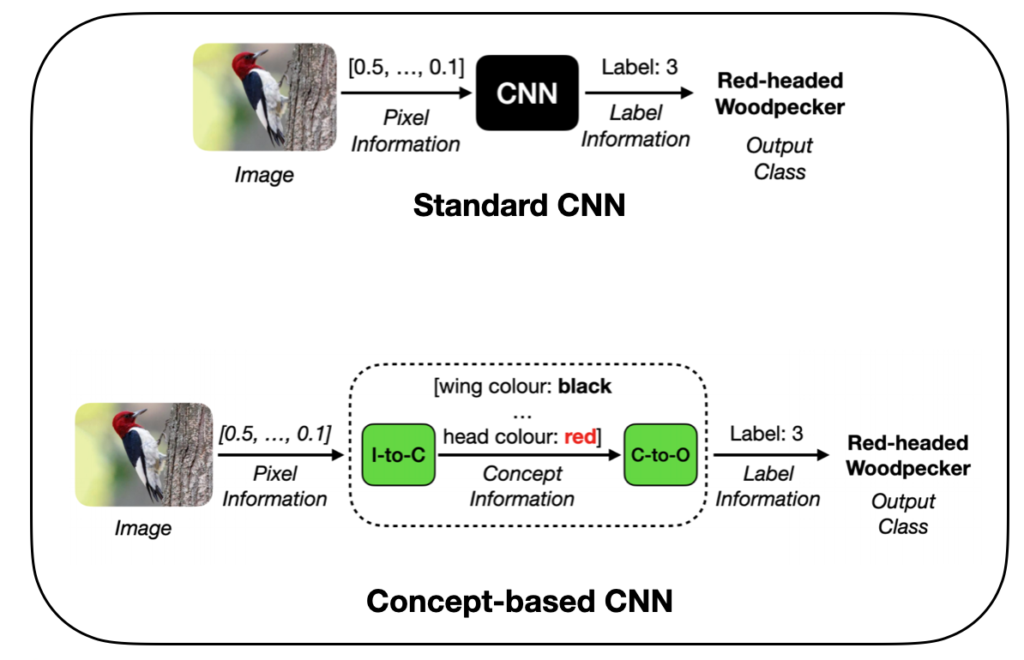

Con CME, utilizziamo l’osservazione di cui sopra e consideriamo uno scenario in cui noi Avere conoscenza dei concetti sottostanti, ma abbiamo solo una piccola quantità di annotazioni di esempio per ciascuno di questi concetti. Analogamente a (3), CME si basa su una data CNN vanilla pre-addestrata e sulla piccola quantità di annotazioni concettuali per estrarre ulteriori annotazioni concettuali in un moda semi-controllata, come mostrato di seguito:

Come mostrato sopra, CME estrae la rappresentazione concettuale utilizzando lo spazio nascosto di un modello pre-addestrato in a post-hoc moda. Ulteriori dettagli sono forniti di seguito.

Formazione sui codificatori di concetti: invece di addestrare da zero i codificatori di concetti sui dati grezzi, come fatto nel caso dei CBM, impostiamo la formazione del nostro modello di codificatore di concetti in un moda semi-controllatautilizzando lo spazio nascosto della CNN vanilla:

- Iniziamo specificando in anticipo un insieme di livelli L dalla CNN vanilla da utilizzare per l’estrazione dei concetti. Questo può variare da Tutto livelli, fino agli ultimi, a seconda della capacità di elaborazione disponibile.

- Successivamente, per ciascun concetto, addestriamo un modello separato sopra lo spazio nascosto di ogni layer in L per prevedere i valori di quel concetto dallo spazio nascosto del layer

- Procediamo selezionando il modello e il livello corrispondente con la migliore precisione del modello come modello e livello “migliori” per prevedere quel concetto.

- Di conseguenza, quando si effettuano previsioni concettuali per un concetto ioper prima cosa recuperiamo la rappresentazione dello spazio nascosto del livello migliore per quel concetto, quindi la passiamo attraverso il modello predittivo corrispondente per l’inferenza.

Nel complesso, il codificatore di concetti La funzione può essere riassunta come segue (assumendo che esistano K concetti in totale):

- Qui, il p-hat sul lato sinistro rappresenta la funzione del codificatore del concetto

- IL GI termini ᵢ rappresentano i modelli dallo spazio nascosto al concetto addestrati sopra i diversi strati di spazi nascosti, con io che rappresenta l’indice del concetto, che va da 1 a K. In pratica, questi modelli possono essere abbastanza semplici, come i regressori lineari o i classificatori con gradiente potenziato

- IL F(X) i termini rappresentano i sottomodelli della CNN vanilla originale, estraendo la rappresentazione nascosta dell’input a un livello particolare

- In entrambi i casi sopra, lʲ gli apici specificano gli strati “migliori” su cui operano questi due modelli

Formazione per elaboratori di concetti: L’addestramento del modello di processore concettuale in CME viene impostato addestrando i modelli utilizzando le etichette delle attività come output e codificatore di concetti previsioni come input. È importante sottolineare che questi modelli operano su una rappresentazione dell’input molto più compatta e di conseguenza possono essere rappresentati direttamente tramite interpretabile modelli, come gli alberi decisionali (DT) o i modelli di regressione logistica (LR).

Fonte: towardsdatascience.com