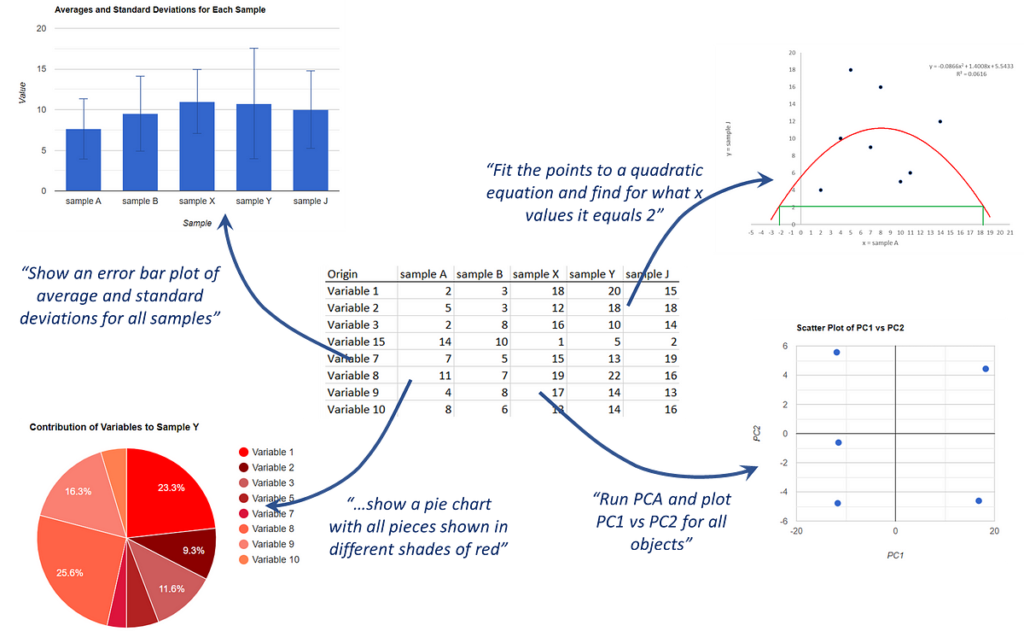

Recentemente ho iniziato a esplorare come utilizzare modelli linguistici di grandi dimensioni (LLM) per automatizzare l’analisi dei dati in modo tale da poter porre loro domande su un set di dati in forma naturale e loro rispondere generando ed eseguendo codice. Implementato tutto questo come app web, io (e tu!) abbiamo potuto provare la potenza e i limiti di questo approccio, al momento affidandomi interamente al programma che scrive JavaScript vanilla:

Come spiego in quell’articolo, il mio interesse principale è affrontare questa domanda:

Posso porre domande a un LLM su un set di dati con parole mie e fargli interpretare queste domande con la matematica o gli script necessari per rispondere?

Dopo i numerosi test ivi riportati, ho individuato diverse limitazioni che, onestamente, precludono le applicazioni più interessanti. Vale a dire, mentre sia GPT-3.5-turbo che GPT-4 dimostrano una comprensione delle query degli utenti e possono generare codice adeguato per varie attività di analisi dei dati, sorgono sfide quando si affrontano operazioni matematiche complesse e richieste di una certa complessità. E non sto parlando di una complessità molto elevata; ad esempio, entrambi i LLM potevano produrre codice corretto per eseguire la regressione lineare ma fallivano negli adattamenti quadratici e venivano completamente persi quando si tentava di implementare procedure come l’analisi delle componenti principali (PCA). La cosa peggiore è che spesso non si rendevano nemmeno conto che il compito era troppo per loro, allucinando il codice che sembrava OK in un passaggio veloce (ad esempio, la procedura PCA ha cercato di invocare la scomposizione in valori singolari, SVD) e talvolta non lo faceva. non si è nemmeno schiantato, eppure era chiaramente sbagliato.

Fonte: towardsdatascience.com