Come sfruttare ogni aspetto del tuo sistema per eseguire i LLM più velocemente? – la migliore pratica

lI moderni Large Language Models (LLM) come ChatGPT, Llama, ecc. stanno rivoluzionando il settore tecnologico e influendo sulla vita di tutti. Tuttavia, il loro costo rappresenta un ostacolo significativo. Le applicazioni che utilizzano le API OpenAI comportano spese sostanziali per il funzionamento continuo (0,03 $ per 1.000 token prompt e 0,06 $ per 1.000 token campionati).

Per ridurre i costi, le aziende tendono a ospitare i propri LLM, con spese che variano ampiamente in base alle dimensioni del modello (LLM più grandi con parametri da 100 a 200 miliardi possono costare circa 10 volte di più rispetto a quelli più piccoli con parametri da 7 a 15 miliardi). Questa tendenza ha stimolato la corsa ai chip AI, poiché le principali aziende tecnologiche mirano a sviluppare i propri chip AI, riducendo la dipendenza da hardware costoso.

Come sfruttare tutta la potenza di calcolo per eseguire LLM? In questo articolo, effettuerò un’analisi approfondita della strategia di ottimizzazione LLM su modelli, software e hardware. Ne consegue il Metodologia di co-progettazione AI SW/HW Ho scritto nell’articolo precedente, con una discussione molto più approfondita sull’ottimizzazione dei costi e delle prestazioni specifici di LLM.

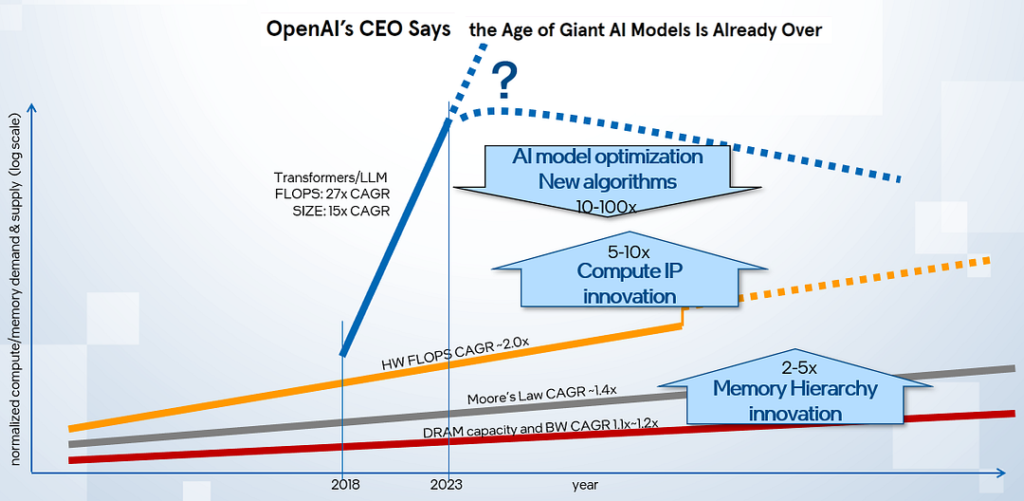

Le richieste di elaborazione e memoria per l’esecuzione di modelli LLM stanno crescendo in modo esponenziale, mentre le capacità di elaborazione/memoria sono in ritardo su una traiettoria più lenta, come illustrato nell’immagine sopra. Per colmare questo divario prestazionale, è fondamentale esplorare i miglioramenti in tre aree chiave:

- Miglioramento algoritmico e compressione del modello: Come possiamo aumentare i modelli con funzionalità per ridurre le esigenze di calcolo e memoria senza compromettere la qualità? Quali sono gli ultimi progressi nella tecnologia di quantizzazione LLM che riducono le dimensioni del modello mantenendo la qualità?

- Stack SW efficiente e librerie di accelerazione: Quali considerazioni sono vitali in…

Fonte: towardsdatascience.com