Un paio di settimane fa, ho scritto di costruire sistemi per generare più insight di qualità. Ho presentato come potresti aumentare la produttività del tuo team lavorando su aree come processi, strumenti, cultura, ecc., ma non ho mai definito cosa intendessi per “qualità”, quindi questa settimana faremo un approfondimento in questo concetto.

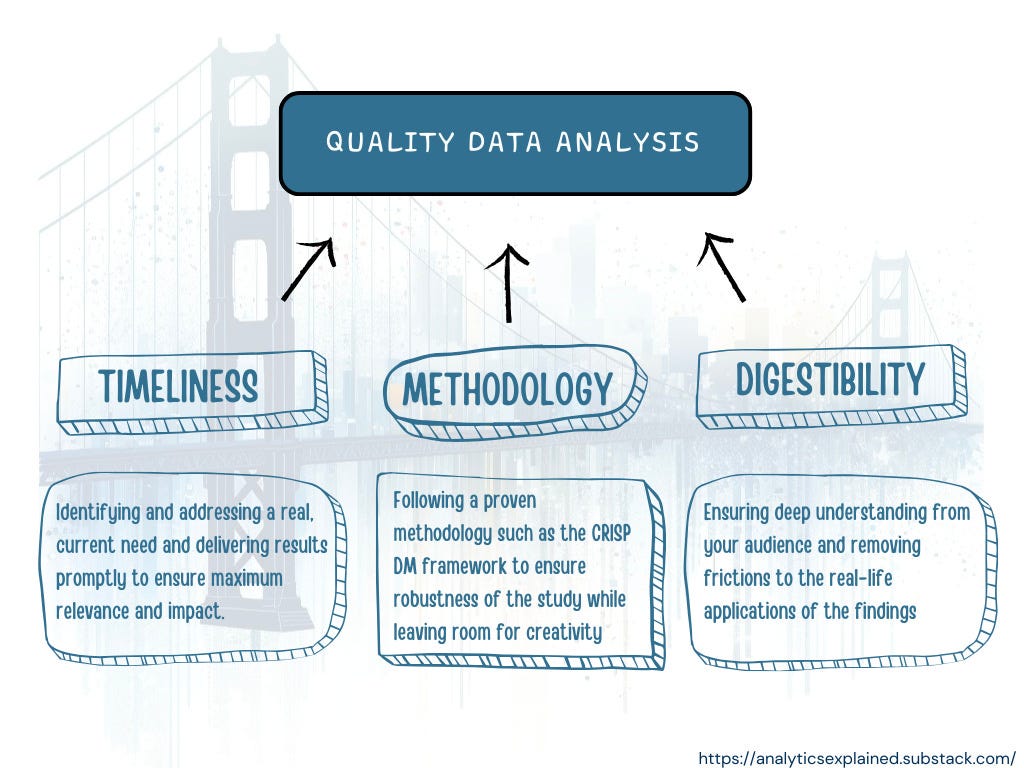

Di solito, quando qualcuno parla di qualità in merito a uno studio di dati, passiamo immediatamente a “assicurarci che l’analisi dei dati sia valida e che i risultati siano affidabili”. Credo che questa sia solo una parte della definizione. Dai miei oltre 8 anni di esperienza nell’analisi, affinché un’analisi dei dati sia un “buon lavoro” deve essere una combinazione di tre elementi fondamentali:

- Risponde a un bisogno reale con tempestiva precisione.

- È sostenuto da una metodologia solida e collaudata.

- È digeribile dall’organizzazione.

Immergiamoci!

Affinché un’analisi dei dati abbia un vero impatto, è fondamentale che si rivolga a un’esigenza reale e ben definita. Ciò significa capire esattamente quale problema viene affrontato, identificare chi interessa, riconoscere perché è rilevante in questo specifico momento ed avere chiaro come verranno utilizzati concretamente i risultati dell’analisi. La precisione di questa comprensione è direttamente correlata al valore che la tua analisi apporta ai tuoi utenti finali.

Ed è fondamentale individuare un bisogno reale, anziché percepito. Ciò garantirà che l’analisi non sia solo teoricamente utile ma praticamente applicabile. Garantirà che l’ultimo giorno del progetto, quando lo presenterai ai tuoi stakeholder, non riceverai domande del tipo “e allora… e adesso?”. Fa la differenza tra fornire dati approfonditi e utilizzabili e offrire informazioni che, sebbene interessanti, potrebbero non essere immediatamente vantaggiose.

Ad esempio, un’azienda di vendita al dettaglio potrebbe percepire la necessità di analizzare i dati demografici dei clienti in modo ampio, ma la necessità effettiva potrebbe essere quella di comprendere i modelli di acquisto di una specifica fascia di età. Quest’ultimo influenza direttamente le strategie di marketing e le decisioni sull’inventario, avendo così un impatto più profondo sulle operazioni aziendali.

Altrettanto importante è la tempestività dell’analisi. Questo aspetto comprende due elementi chiave: la rilevanza del bisogno nel momento attuale e la velocità con cui viene fornita l’analisi.

- Pertinenza della necessità: Le esigenze delle aziende sono spesso sensibili al fattore tempo e possono evolversi rapidamente, soprattutto se si lavora in un’organizzazione frenetica. Un’analisi che affronta una questione urgente e attuale è molto più preziosa di un’analisi che arriva troppo tardi o di un’analisi che è stata fatta troppo presto. Ad esempio, un’analisi delle tendenze dei consumatori nel periodo precedente alle principali festività natalizie può essere preziosa per un’azienda in termini di stoccaggio e marketing, ma se avviene dopo l’inizio della stagione, l’opportunità è persa.

- Tempestività di analisi: La velocità con cui viene fornita l’analisi è altrettanto fondamentale, poiché ciò contribuisce alla rilevanza del bisogno. E questo è un fattore importante da tenere in considerazione, poiché a volte potresti dover scendere a compromessi tra la completezza dello studio e la velocità (ad esempio, se c’è una nuova tendenza sui social media e la tua azienda desidera un’analisi per trarre vantaggio da una viralità argomento: non puoi impiegare 2 mesi per tornare con i risultati).

In sintesi: le probabilità di successo dell’analisi dei dati sono significativamente maggiori quando identifica e affronta con precisione un’esigenza reale e attuale e quando viene fornita in modo tempestivo, garantendo la massima pertinenza e impatto.

Troppo spesso: vedo analisi dei dati che non utilizzano alcuna metodologia standard. E anche se questo non significa necessariamente che lo studio non sarà buono, riduci notevolmente le tue possibilità di realizzare un lavoro di alta qualità non seguendo una metodologia comprovata.

Un approccio strutturato/standardizzato garantisce la completezza e migliora anche la credibilità e la replicabilità dell’analisi.

Una metodologia che trovo facile da seguire è il framework CRoss Industry Standard Process for Data Mining (CRISP-DM). Dopo quasi un decennio nel settore, questo è ancora il mio quadro di riferimento quando inizio un’analisi da zero. Questo quadro, che si dice sia il processo standard di “scienza dei dati”/”analisi dei dati”, prevede 6 fasi principali:

- Comprensione aziendale: Durante questa fase, l’analista dei dati dovrebbe comprendere approfonditamente il “contesto aziendale” della domanda: qual è il punto critico che stiamo cercando di risolvere, cosa abbiamo fatto in passato, chi sono gli “attori”, cosa sono i rischi, le risorse, ecc. – e, cosa molto importante, quali sarebbero i criteri di successo del progetto.

- Comprensione dei dati: Questa fase prevede la conoscenza dei dati: riguarda l’analisi descrittiva ed esplorativa dei dati e l’identificazione dei problemi di qualità dei dati. È il tuo “sondaggio preliminare”, in cui inizi a cogliere le sfumature e il potenziale dei dati.

- Preparazione dei dati: Questa fase riguarda la selezione dei dati con cui si desidera lavorare, con la logica dell’inclusione/esclusione, quindi la pulizia e la trasformazione dei dati in un formato adatto all’analisi. È come preparare gli ingredienti prima di cucinare un pasto, fondamentale per una buona riuscita.

- Modellazione: L’idea di “modellazione” può essere scoraggiante per alcune persone, ma la modellazione può essere facile come “creare una determinata soglia” per una metrica vero/falso (ad esempio, se il tuo progetto sta comprendendo/definendo il tasso di abbandono). Durante questa fase, ai dati preparati vengono applicate varie tecniche di modellazione, in modo da poterli confrontare tra loro e capire quali sono quelle di maggior successo.

- Valutazione: I modelli vengono ora valutati criticamente per garantire che soddisfino gli obiettivi aziendali e i criteri di successo stabiliti nella fase n. 1. Questo spesso porta a approfondimenti che puoi utilizzare per tornare indietro e rivedere la tua comprensione del business.

- Distribuzione: La fase finale prevede l’applicazione del modello a dati e situazioni del mondo reale, mettendo in pratica l’analisi in modo efficace e iniziando a utilizzare le intuizioni per migliorare le operazioni del team.

Questo quadro aumenta le probabilità che la tua analisi sia più solida costringendoti a passare attraverso questi diversi passaggi, lasciando spazio alla creatività.

La digeribilità non significa solo semplificare informazioni complesse e rendere più facile la comprensione delle diapositive. Coinvolge due aspetti integrali: (1) promuovere un profondo livello di comprensione da parte del pubblico e (2) consentire loro di applicare queste intuizioni in modo pratico e di grande impatto. Questo processo è simile al modo in cui il corpo non solo scompone il cibo ma utilizza anche i nutrienti per alimentare varie funzioni.

Promuovere un profondo livello di comprensione da parte del pubblico

Per raggiungere questo obiettivo è necessario rendere i dati accessibili e in risonanza con il pubblico. È qui che gli esperti in materia (PMI) svolgono un ruolo cruciale. Coinvolgendo le PMI nelle prime fasi del processo di analisi, la loro conoscenza del settore può guidare l’inquadramento e l’interpretazione dei dati, garantendo che l’analisi sia in linea con i contesti del mondo reale e sia presentata in modo significativo per il pubblico previsto.

Un’altra strategia chiave per migliorare la digeribilità è l’implementazione di un processo “stage-gate”, che prevede check-in regolari e aggiornamenti con le parti interessate o il team ricevente. Questo approccio evita di sovraccaricarli con una mole di informazioni complesse alla fine dello studio. Invece, le parti interessate vengono accompagnate nel viaggio, consentendo loro di assimilare gradualmente nuove intuizioni. Apre inoltre strade per un feedback continuo, garantendo che l’analisi rimanga allineata con le esigenze e le aspettative in evoluzione del pubblico.

Immagina di far parte di una grande organizzazione che implementa una nuova strategia basata sui dati. Se il team che si occupa dei dati presenta solo l’analisi finale senza alcun coinvolgimento preventivo, le parti interessate potrebbero avere difficoltà a coglierne le sfumature o a vederne la rilevanza per i loro contesti specifici. Tuttavia, coinvolgendo queste parti interessate a intervalli regolari – attraverso presentazioni periodiche o workshop – acquisiscono maggiore familiarità con i dati e le loro implicazioni. Possono offrire feedback preziosi, indirizzando l’analisi verso le aree per loro più pertinenti, garantendo così che il risultato finale non sia solo comprensibile ma immediatamente utilizzabile e adattato alle loro esigenze.

Consentire al pubblico di applicare le intuizioni

L’actionability ruota attorno alla traduzione di questa profonda comprensione in applicazioni o decisioni del mondo reale. Si tratta di garantire che il pubblico possa utilizzare efficacemente le informazioni per ottenere risultati tangibili. Si tratta di pensare davvero all’“ultimo miglio” tra la tua analisi e l’impatto nella vita reale e a come puoi contribuire a rimuovere qualsiasi attrito per adottare le tue intuizioni.

Ad esempio, se stai lavorando a un progetto in cui il tuo obiettivo è definire il tasso di abbandono degli utenti, rendere il tuo studio più digeribile potrebbe includere la creazione di una dashboard che consenta alle parti interessate della tua azienda di capire come si presentano concretamente i tuoi risultati.

Altre idee includono l’organizzazione di workshop, lo sviluppo di visualizzazioni interattive, ecc. – qualsiasi cosa che renda più semplice per il team partire con slancio.

In sintesi, la digeribilità di un progetto di analisi dei dati viene notevolmente migliorata coinvolgendo le PMI fin dall’inizio e mantenendo una comunicazione continua con le parti interessate. Questo approccio collaborativo garantisce che lo studio non solo sia comprensibile ma anche direttamente rilevante e prezioso per coloro a cui è destinato.

Un’analisi dei dati di successo è una fusione di competenza tecnica, allineamento strategico e applicabilità pratica. Non si tratta solo di seguire una serie di passaggi, ma di comprendere e adattare tali passaggi al contesto unico di ciascun progetto. Tempestività, corretta esecuzione e risposta alle reali esigenze organizzative sono i pilastri che supportano il ponte che collega l’analisi dei dati al successo organizzativo. L’obiettivo finale è trasformare i dati in informazioni fruibili che generino valore e informino il processo decisionale strategico.

Spero che ti sia piaciuto leggere questo pezzo! Hai qualche consiglio che vorresti condividere? Fatelo sapere a tutti nella sezione commenti!

PS: questo articolo è stato pubblicato in modo incrociato su Analisi spiegatauna newsletter in cui distillo ciò che ho imparato in vari ruoli analitici (dalle startup di Singapore alle grandi tecnologie di San Francisco) e rispondo alle domande dei lettori su analisi, crescita e carriera.

Fonte: towardsdatascience.com