Spiegare come le reti neurali “addestrano” e “imparano” i modelli nei dati manualmente e nel codice utilizzando PyTorch

Nei miei ultimi due articoli, abbiamo approfondito le origini della rete neurale da un singolo percettrone ad un grande interconnesso (percettrone multistrato (MLP)) motore di ottimizzazione non lineare. Ti consiglio vivamente di controllare i miei post precedenti se non hai familiarità con il percettrone, l’MLP e le funzioni di attivazione poiché ne discuteremo un po’ in questo articolo:

Ora è il momento di capire come queste reti neurali vengono “addestrate” e “imparano” i modelli nei dati che vi vengono trasmessi. Ci sono due componenti chiave: passaggio in avanti E propagazione all’indietro. Entriamo nel vivo!

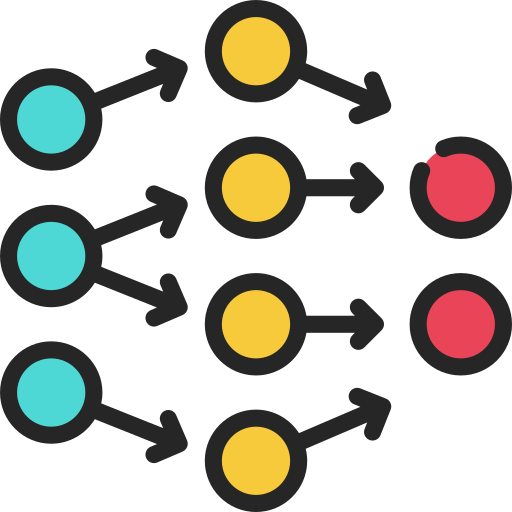

Ricapitoliamo velocemente la struttura generale di una rete neurale:

Dove ogni neurone nascosto sta eseguendo il seguente processo:

- Ingressi: Queste sono le caratteristiche dei nostri dati.

- Pesi: Alcuni coefficienti per i quali moltiplichiamo gli input. L’obiettivo dell’algoritmo è trovare i pesi ottimali.

- Somma ponderata lineare: Sommare i prodotti degli input e dei pesi e aggiungere un termine di bias/compensazione, B.

- Livello nascosto: Qui è dove vengono archiviati più neuroni per apprendere i modelli nei dati. L’apice si riferisce…

Fonte: towardsdatascience.com