La capacità di gestire oggetti invisibili in modo zero-shot rende i modelli di machine learning molto attraenti per le applicazioni nella robotica, consentendo ai robot di entrare in ambienti mai visti prima e di manipolare oggetti sconosciuti al loro interno.

Sebbene la loro precisione nel farlo sia incredibile rispetto a quanto era concepibile solo pochi anni fa, l’incertezza non solo è qui per restare, ma richiede anche un trattamento diverso rispetto a quello consueto nell’apprendimento automatico quando utilizzato nel processo decisionale.

Questo articolo descrive i risultati recenti relativi alla gestione di quelle che chiamiamo attività di “prova ed errore” e spiega come è possibile derivare decisioni ottimali modellando il sistema come una catena di Markov a tempo continuo, ovvero il processo di salto di Markov.

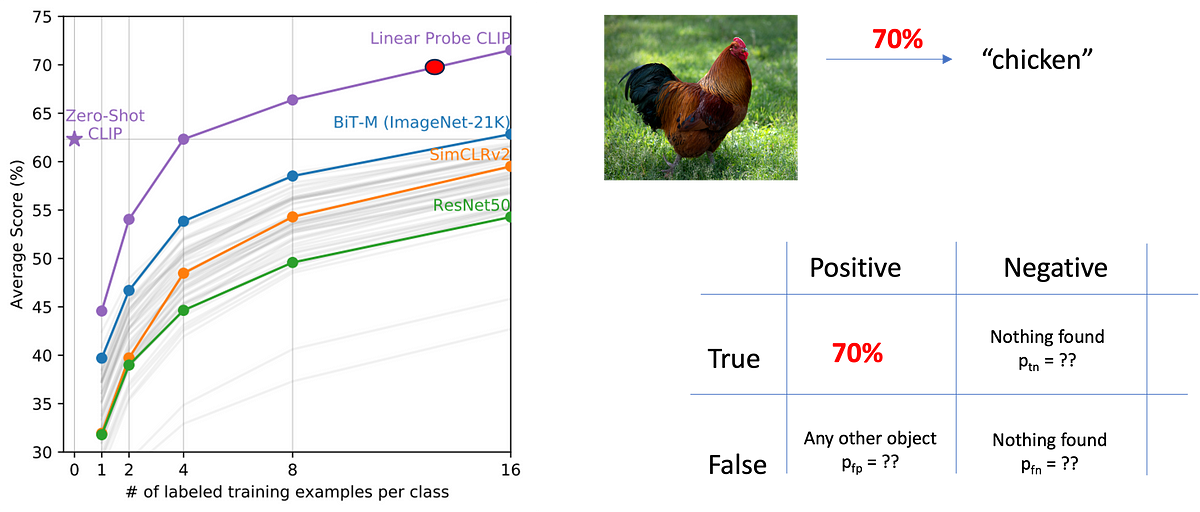

L’immagine sopra mostra le prestazioni medie per l’etichettatura di immagini zero-shot di CLIP, un modello rivoluzionario di OpenAI che costituisce la base per grandi modelli multimodali come LLava e GPTv4. Supponiamo che sia in grado di etichettare un’immagine contenente un pollo con una precisione del 70%. Sebbene si tratti di una prestazione incredibile, nel 30% dei casi l’etichetta sarà sbagliata.

L’etichettatura non è il caso d’uso che ci interessa quando utilizziamo questo output per il processo decisionale. Ad esempio, se vogliamo utilizzare un repellente automatico per polli, avremo bisogno di una risposta chiara sulla presenza o meno di un pollo. Purtroppo la risposta non è un “sì” o un “no”, ma dobbiamo considerare quattro casi:

- Vero positivo: C’è un pollo e il modello di visione lo vede

- Falso positivo: C’è un pollo, ma il modello di visione vede un cane, un gatto o un cacciavite.

- Vero negativo: Non esiste il pollo, e anche la modella la pensa così.

- Falso negativo: C’è un pollo, ma i modelli di visione non lo vedono.

Questi casi sono riassunti nell’immagine sopra. Come puoi vedere, ciò che viene fornito come “accuratezza” nel modello copre solo il caso “Vero Positivo”. Ciò che rimane sconosciuto è quali siano le probabilità degli altri possibili risultati.

Fonte: towardsdatascience.com