L’architettura Transformer è stata una componente importante del successo dei Large Language Models (LLM). È stato utilizzato per quasi tutti i LLM utilizzati oggi, dai modelli open source come Mistral ai modelli closed source come ChatGPT.

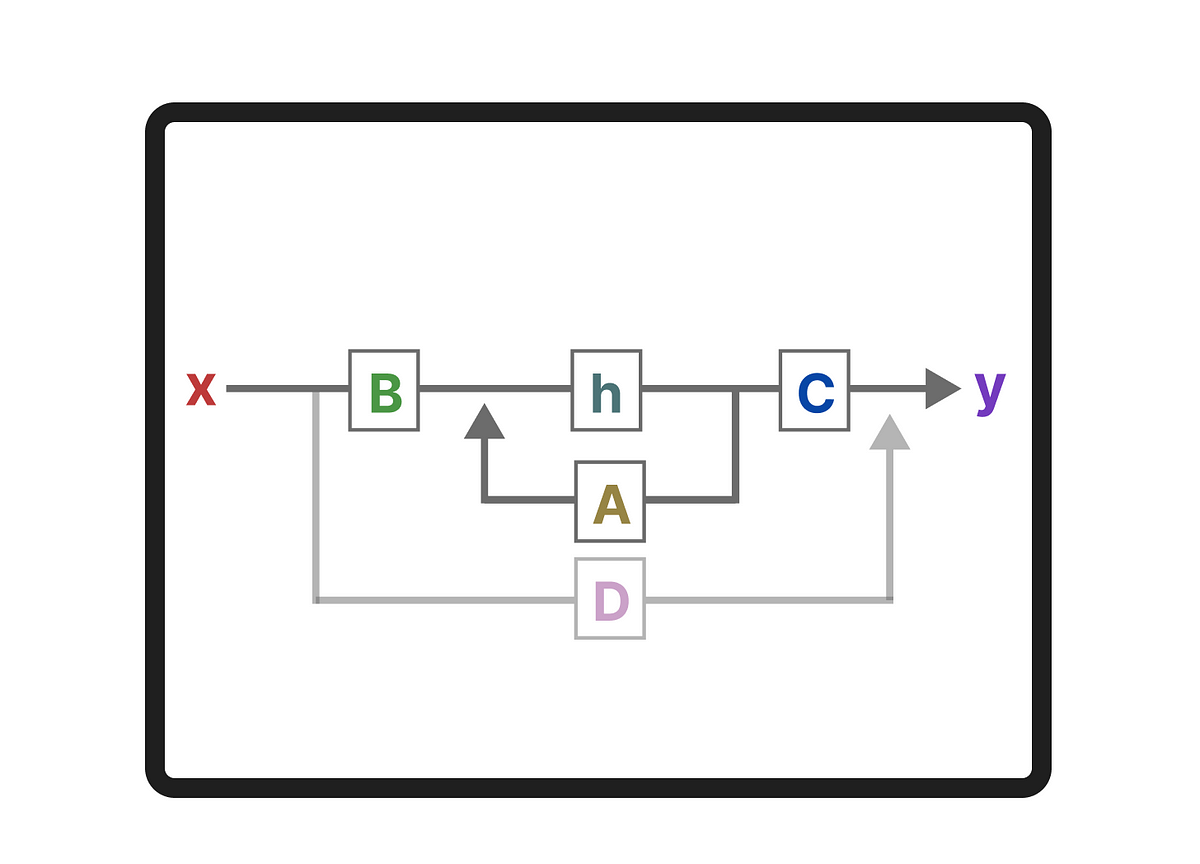

Per migliorare ulteriormente gli LLM, vengono sviluppate nuove architetture che potrebbero addirittura superare l’architettura Transformer. Uno di questi metodi è MambaUN Modello dello spazio statale.

Mamba è stato proposto nel giornale Mamba: modellazione di sequenze temporali lineari con spazi di stati selettivi. Puoi trovare la sua implementazione ufficiale e i checkpoint del modello nel suo file deposito.

In questo post, introdurrò il campo dei modelli spaziali degli stati nel contesto della modellazione del linguaggio ed esplorerò i concetti uno per uno per sviluppare un’intuizione sul campo. Successivamente, tratteremo di come Mamba potrebbe sfidare l’architettura Transformers.

Come guida visiva, aspettati che molte visualizzazioni sviluppino un’intuizione su Mamba e sui modelli spaziali statali!

Per illustrare perché Mamba è un’architettura così interessante, facciamo prima un breve riepilogo dei trasformatori ed esploriamo uno dei suoi svantaggi.

Un Transformer vede qualsiasi input testuale come a sequenza che consiste in gettoni.

Uno dei principali vantaggi di Transformers è che qualunque sia l’input ricevuto, può guardare indietro a qualsiasi token precedente nella sequenza per ricavarne la rappresentazione.

Ricorda che un Transformer è costituito da due strutture, un insieme di blocchi codificatori per rappresentare il testo e un insieme di blocchi decodificatori per generare testo. Insieme, queste strutture possono essere utilizzate per diversi compiti, inclusa la traduzione.

Fonte: towardsdatascience.com